【PyTorch图像风格迁移秘籍】:手把手教你从入门到精通

发布时间: 2024-12-12 06:53:39 阅读量: 3 订阅数: 16

基于 pytorch实现图像风格迁移示例 完整代码+数据 可直接运行

# 1. PyTorch图像风格迁移概述

## 1.1 风格迁移的起源和重要性

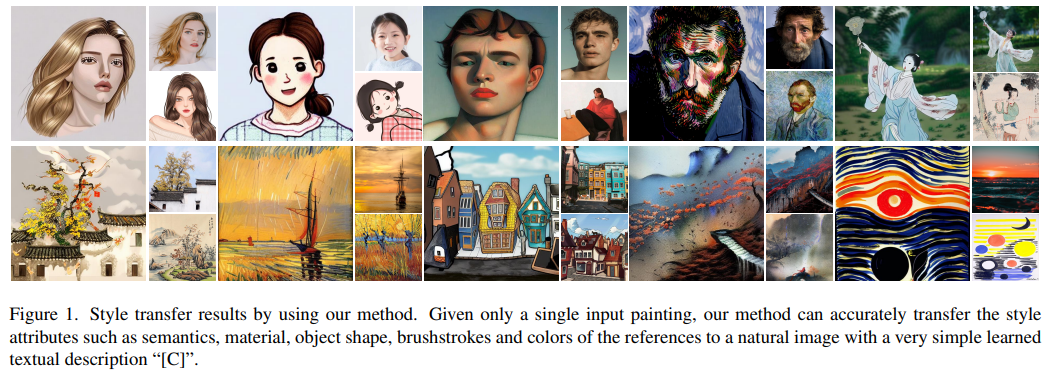

图像风格迁移是一种利用深度学习将一种艺术风格转换到普通照片的技术。它起源于2015年的一篇开创性论文《神经风格迁移》,该技术使计算机能够以一种新的艺术形式重新渲染图像,从而开启了一种全新的创作方式。随着计算能力的增强和算法的进步,风格迁移已经从一种纯粹的研究兴趣,发展成为一种商业和娱乐领域的热门技术,被广泛应用于艺术设计、游戏开发和社交媒体等多个领域。

## 1.2 风格迁移与深度学习的关系

风格迁移的实现离不开深度学习模型,尤其是卷积神经网络(CNN)。CNN能够提取图像的特征,区分内容和风格,并以一种新颖的方式组合它们。PyTorch作为一个易用、灵活的深度学习框架,为实现复杂的图像风格迁移提供了便利。通过PyTorch,研究人员和开发人员可以轻松地设计和训练自己的风格迁移模型,从而创造出各种风格独特的新图像。

## 1.3 PyTorch图像风格迁移的应用前景

随着技术的不断进步,PyTorch图像风格迁移的应用前景十分广阔。从创意艺术的创作到个性化产品的定制,再到在线教育和视觉内容的增强,风格迁移都有很大的发挥空间。它不仅能够提供给用户全新的视觉体验,还可能成为商业产品中的一种创新点,为企业打开新的增长路径。在本系列文章中,我们将深入探讨如何使用PyTorch实现高效且实用的图像风格迁移,为这一领域的发展做出贡献。

# 2. PyTorch基础与环境搭建

## 2.1 PyTorch的基本概念与结构

### 2.1.1 张量和操作

在PyTorch中,张量是一种多维数组,用于存储数值数据,类似于NumPy中的数组。它是构建和操作深度学习模型的核心数据结构。我们可以通过定义张量的类型(如float32,int64等)、形状以及存储设备(CPU或GPU)。

```python

import torch

# 创建一个5x3的未初始化的浮点型张量

x = torch.empty(5, 3)

print(x)

# 创建一个随机初始化的张量

x = torch.rand(5, 3)

print(x)

# 指定张量的数据类型和设备

x = torch.tensor([1., 2., 3.], dtype=torch.float32, device='cuda')

print(x)

```

在上述代码中,我们首先引入了PyTorch库,然后分别演示了如何创建一个空的张量、一个随机初始化的张量以及如何指定张量的数据类型和运行设备。对于想要在GPU上进行加速计算的场景,指定`device='cuda'`是常见的做法。

### 2.1.2 自动梯度与优化器

自动梯度是PyTorch的自动微分引擎,用于计算张量操作的梯度,这对于构建和训练神经网络至关重要。PyTorch通过`requires_grad`属性来标识哪些张量需要梯度计算。

```python

# 创建一个需要梯度的张量

x = torch.tensor([1., 2., 3.], requires_grad=True)

y = x * 2

z = y.sum()

# 反向传播计算梯度

z.backward()

print(x.grad)

```

代码中展示了如何创建一个需要梯度的张量`x`,执行一些操作后,调用`.backward()`来计算梯度。这个过程对于神经网络的反向传播算法来说是核心。

## 2.2 深入了解神经网络

### 2.2.1 前馈神经网络基础

前馈神经网络是最简单的神经网络之一,它由输入层、隐藏层和输出层组成。每一层的神经元仅与下一层的神经元相连。在PyTorch中,可以使用`torch.nn.Module`类及其子类来构建网络。

```python

import torch.nn as nn

class SimpleFeedforwardNet(nn.Module):

def __init__(self, input_size, hidden_size, num_classes):

super(SimpleFeedforwardNet, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(hidden_size, num_classes)

def forward(self, x):

out = self.fc1(x)

out = self.relu(out)

out = self.fc2(out)

return out

# 创建模型实例

net = SimpleFeedforwardNet(input_size=784, hidden_size=500, num_classes=10)

```

我们定义了一个简单的前馈神经网络`SimpleFeedforwardNet`,它包括两个全连接层,中间有一个ReLU激活函数。`.forward()`方法定义了数据在模型中的正向传播路径。

### 2.2.2 卷积神经网络(CNN)简介

卷积神经网络是深度学习中用于处理具有类似网格结构的数据(如图像)的神经网络。它包含卷积层、池化层等特殊层。在PyTorch中,我们可以使用`torch.nn.Conv2d`和`torch.nn.MaxPool2d`等模块构建CNN。

```python

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(in_channels=1, out_channels=32, kernel_size=3, padding=1)

self.maxpool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc = nn.Linear(32*7*7, 10)

def forward(self, x):

x = self.conv1(x)

x = self.maxpool(x)

x = x.view(x.size(0), -1) # Flatten the tensor

x = self.fc(x)

return x

# 创建CNN模型实例

cnn = SimpleCNN()

```

上述代码定义了一个简单的CNN结构,它由一个卷积层、一个最大池化层和一个全连接层构成。卷积层使用3x3的卷积核,并设置padding为1以保持输入图像尺寸不变。池化层用于降低数据的空间维度,最后通过一个全连接层输出分类结果。

### 2.2.3 搭建简单的CNN模型

构建一个完整的卷积神经网络需要考虑网络的深度(层数)、宽度(每层的卷积核数)、激活函数和连接层等。下面构建一个稍微复杂一些的CNN模型,可以用于图像分类任务。

```python

class ComplexCNN(nn.Module):

def __init__(self, num_classes=10):

super(ComplexCNN, self).__init__()

self.conv1 = nn.Conv2d(in_channels=3, out_channels=64, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(in_channels=64, out_channels=128, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc1 = nn.Linear(128*8*8, 500)

self.fc2 = nn.Linear(500, num_classes)

self.relu = nn.ReLU()

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = self.pool(x)

x = self.conv2(x)

x = self.relu(x)

x = self.pool(x)

x = x.view(x.size(0), -1) # Flatten the tensor

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

return x

# 实例化网络

complex_cnn = ComplexCNN(num_classes=10)

```

这个CNN网络拥有两个卷积层,每个卷积层后面都跟着一个ReLU激活函数和一个2x2的最大池化层。在网络的末端,通过两个全连接层将特征映射到最终的分类结果。这个模型对于学习更复杂的图像处理任务是足够的。

## 2.3 PyTorch环境配置与调试

### 2.3.1 安装PyTorch

PyTorch的安装非常简单,只需执行以下命令即可:

```bash

conda install pytorch torchvision torchaudio -c pytorch

```

或者,如果你使用的是pip:

```bash

pip3 install torch torchvision torchaudio

```

### 2.3.2 配置开发环境

一旦安装完成,需要配置开发环境。选择一个合适的IDE是关键,比如PyCharm、VSCode或者Jupyter Notebook都是不错的选择。此外,还需要确保CUDA环境与PyTorch版本兼容,以便GPU加速计算。

### 2.3.3 调试技巧和常见问题解决

调试是机器学习项目中不可避免的环节。在PyTorch中,可以利用Python的调试工具如pdb或者IDE自带的调试功能。此外,查看日志、打印中间变量、使用断点和逐行执行都是常用的调试手段。常见问题可能包括:版本不兼容、CUDA环境配置错误、内存不足等。解决这些问题通常需要对错误信息进行逐字分析,同时查看PyTorch的官方文档,以获得最新的帮助信息。

# 3. ```

# 第三章:图像风格迁移的理论基础

在本章节中,我们将探讨图像风格迁移的理论基础。图像风格迁移是深度学习领域的一个热门话题,它涉及到图像处理技术以及深度学习的高级应用。我们将从图像风格化的原理出发,深入探讨卷积神经网络在风格迁移中的作用,以及风格迁移算法的演进历程。

## 3.1 图像处理与风格化原理

### 3.1.1 图像内容与风格表示

在图像风格迁移中,我们首先需要区分图像的“内容”和“风格”。图像内容指的是图像中描绘的对象和场景,通常通过图像的结构和形状来表示。而图像风格则涉及到颜色、纹理、笔触等视觉效果,风格通常是通过艺术作品的特定表现形式体现出来。

图像内容通常可以通过卷积神经网络(CNN)的中间层来捕捉,而风格则是通过CNN的深层特征图来表达。理解这两者的区别是实现风格迁移的关键。后续章节将会深入讲解如何构建一个能够区分内容和风格的神经网络模型。

### 3.1.2 风格迁移的目标与方法

图像风格迁移的目标是将一种风格应用到另一幅图像上,同时尽可能保持原图的内容。这一过程通常需要使用深度学习方法,尤其是基于CNN的架构,来实现风格和内容的分离。

不同的风格迁移方法具有不同的实现方式。从早期的基于统计的方法如马尔可夫随机场(MRF)到如今基于深度学习的方法,这些方法主要通过优化图像在内容和风格上的表示来实现最终的风格迁移。下面的章节将着重介绍基于CNN的方法。

## 3.2 卷积神经网络在风格迁移中的应用

### 3.2.1 特征提取与风格表示

卷积神经网络特别适合于图像处理任务,因为它们能够有效地捕捉图像的局部特征,并通过层级结构构建更复杂的抽象表示。在风格迁移中,CNN的主要作用是提取图像的内容和风格特征。

为了提取图像的内容,研究人员通常会使用CNN的中间层,这些层能够捕捉到图像的边缘、纹理等信息。而为了表示风格,研究者则会利用网络的深层特征图,因为它们包含了更丰富的风格信息。

### 3.2.2 内容损失与风格损失

在构建损失函数时,我们通常会考虑两种主要的损失:内容损失和风格损失。内容损失是衡量生成图像与目标内容图像在像素级或特征级的差异,而风格损失则是衡量生成图像与目标风格图像在风格上的相似度。

内容损失通常基于均方误差(MSE)或其他距离度量来定义,确保生成图像在内容上与输入图像相似。风格损失则较为复杂,它基于Gram矩阵来衡量风格特征之间的相关性,确保生成图像与风格图像在风格上的一致性。

### 3.2.3 损失函数的构建与优化

在风格迁移中,损失函数的构建是核心问题之一。一个典型的损失函数通常由内容损失和风格损失的加权和组成,并且可能包括一个总变分损失(Total Variation Loss)用于图像平滑。

构建损失函数后,接下来就是利用梯度下降法或其他优化算法来迭代更新生成图像,使得损失函数最小化。优化过程中,图像逐渐逼近目标内容和风格。

## 3.3 风格迁移算法的演进

### 3.3.1 早期方法概述

早期的风格迁移方法依赖于预定义的特征描述符和启发式算法,比如基于图像的纹理合成方法。这些方法通过分析图像中的局部纹理和结构,试图在不同的图像之间转移这些视觉特性。

然而,这些早期方法通常计算量大,且对风格的表达能力有限。尽管如此,这些方法为现代深度学习风格迁移技术的发展打下了基础。

### 3.3.2 现代风格迁移技术

随着深度学习的崛起,现代风格迁移技术发生了质的飞跃。研究者们利用CNN的强大特征学习能力,提出了一系列基于深度神经网络的风格迁移方法,如基于优化的方法和基于模型的快速迁移方法。

基于优化的方法通常通过迭代优化过程来逐步调整图像,直至其风格与指定的艺术风格一致。而基于模型的方法则直接利用预训练的神经网络模型来进行快速风格迁移,这种方法在图像编辑和实时应用中表现优异。

### 3.3.3 算法的局限性与挑战

尽管现代风格迁移技术取得了显著的进展,但仍面临诸多挑战和局限性。例如,当前算法在处理具有复杂结构和丰富纹理的图像时效果不佳,且在风格迁移的过程中常常会出现艺术风格的细节丢失或过度渲染等问题。

此外,深度学习模型的训练需要大量计算资源和高质量的训练数据集。因此,如何在保持风格迁移效果的同时,提高算法的效率和普适性,是未来研究的重要方向。

在本章节中,我们深入探讨了图像风格迁移的理论基础,涵盖了图像处理、卷积神经网络应用、损失函数构建等多个方面。本章的内容为理解后续章节中的实践操作和应用拓展提供了坚实的理论支撑。

```

在这一章节中,我们介绍了图像风格迁移的理论基础,包括图像处理、卷积神经网络应用以及风格迁移算法的演进。通过深入分析图像内容与风格的表示、损失函数的构建和优化,为读者提供了一个从理论到实践的全面理解。下一章节我们将深入实践,探讨如何利用PyTorch实现图像风格迁移。

# 4. PyTorch图像风格迁移实践

## 4.1 实现基础风格迁移模型

### 4.1.1 预训练模型的加载与应用

在实现风格迁移之前,我们需要加载预训练的卷积神经网络模型来作为内容和风格特征的提取器。一个常用的预训练模型是VGG19,由Simonyan和Zisserman在论文《Very Deep Convolutional Networks for Large-Scale Image Recognition》中提出。VGG19具有深层的结构,能提取丰富的图像特征,非常适合用于风格迁移。

以下是一个示例代码,展示如何使用PyTorch加载预训练的VGG19模型:

```python

import torch

import torchvision.models as models

import torchvision.transforms as transforms

from PIL import Image

# 加载预训练的VGG19模型

vgg = models.vgg19(pretrained=True).features

# 设置模型为评估模式

vgg.eval()

# 为了将图像转换为模型需要的格式,需要定义相应的变换

def load_image(img_path, max_size=400, shape=None):

image = Image.open(img_path).convert('RGB')

if max(image.size) > max_size:

size = max_size

else:

size = max(image.size)

if shape is not None:

size = shape

in_transform = transforms.Compose([

transforms.Resize(size),

transforms.ToTensor(),

transforms.Normalize((0.485, 0.456, 0.406),

(0.229, 0.224, 0.225))

])

# 将PIL图像转换为tensor

image = in_transform(image)[:3,:,:].unsqueeze(0)

return image

# 使用预训练模型提取特征

def get_features(image, model, layers=None):

if layers is None:

layers = {

'0': 'conv1_1',

'5': 'conv2_1',

'10': 'conv3_1',

'19': 'conv4_1',

'21': 'conv4_2', # 内容特征层

'28': 'conv5_1'

}

features = {}

x = image

for name, layer in model._modules.items():

x = layer(x)

if name in layers:

features[layers[name]] = x

return features

# 加载图像并转换为模型可处理的格式

img = load_image('path_to_your_image.jpg', shape=(224,224))

# 获取图像特征

model = vgg

model = model.cuda() if torch.cuda.is_available() else model

model = model.eval()

img = img.cuda() if torch.cuda.is_available() else img

features = get_features(img, model)

```

在上述代码中,我们首先导入了必要的库,并加载了预训练的VGG19模型。然后我们定义了图像加载和转换函数`load_image`以及特征提取函数`get_features`。`get_features`函数通过遍历模型的每一层并检查我们感兴趣的特定层(例如内容和风格层),来提取这些层的输出特征。

### 4.1.2 风格迁移模型的搭建与训练

风格迁移模型的搭建涉及定义一个神经网络,该网络可以结合内容特征和风格特征,通过反向传播来调整输入图像,从而生成符合特定风格的图像。以下是一个简化的风格迁移模型搭建和训练过程:

```python

import torch.optim as optim

# 定义风格迁移模型

class StyleTransferModel(nn.Module):

def __init__(self):

super(StyleTransferModel, self).__init__()

# 添加网络层,此处省略具体实现细节...

def forward(self, x):

# 定义前向传播过程,此处省略具体实现细节...

return x

# 实例化模型

style_transfer_model = StyleTransferModel()

if torch.cuda.is_available():

style_transfer_model = style_transfer_model.cuda()

# 损失函数

content_loss_fn = nn.MSELoss()

style_loss_fn = nn.MSELoss()

# 优化器

optimizer = optim.Adam(style_transfer_model.parameters(), lr=0.001)

# 开始风格迁移训练

for epoch in range(num_epochs):

optimizer.zero_grad()

# 前向传播,获取模型输出

output = style_transfer_model(input_image)

# 计算内容损失和风格损失

content_loss = content_loss_fn(output['content'], content_feature)

style_loss = sum(style_loss_fn(output['styles'][i], style_features[i]) for i in range(len(style_features)))

# 计算总损失

total_loss = content_loss + style_loss

# 反向传播

total_loss.backward()

# 更新参数

optimizer.step()

# 保存或展示最终生成的风格化图像...

```

在这个简化的例子中,我们首先定义了风格迁移模型`StyleTransferModel`类,然后使用适当的损失函数和优化器来训练网络。在每个训练步骤中,我们通过前向传播获取模型输出,并计算内容损失和风格损失,然后进行反向传播和参数更新。最终生成的风格化图像可以被保存或展示。

在实际应用中,搭建和训练风格迁移模型是一个复杂的过程,需要根据具体情况调整网络结构、损失函数和训练参数。但上面提供的代码框架可作为入门实践的基础。

# 5. 风格迁移项目的拓展应用

## 风格迁移在其他领域的应用

风格迁移技术不仅仅局限于图像领域,它已经拓展到了文字和视频领域,开辟了全新的应用场景。

### 文字风格迁移

在自然语言处理(NLP)领域,风格迁移可以用来生成特定风格的文本。比如,将一段新闻报道风格的文本转换成小说风格。这涉及到理解文本内容的同时,提取并应用目标风格的特征。这通常通过循环神经网络(RNN)或Transformer架构来实现。

```python

import torch

from transformers import pipeline, set_seed

# 初始化风格迁移模型,这里使用了transformers库中的预训练模型

generator = pipeline("text2text-generation", model="t5-base")

# 定义一个函数来执行风格迁移

def text_style_transfer(content_text, style_text):

# 基于风格和内容的提示,生成新的文本

input_text = f"风格化文本: {style_text} 内容文本: {content_text}"

output = generator(input_text)

return output[0]['generated_text']

# 设置随机种子以便复现结果

set_seed(42)

# 示例内容和风格文本

content = "PyTorch是一个开源的机器学习库。"

style = "优雅而简洁的风格。"

# 执行风格迁移

result = text_style_transfer(content, style)

print(result)

```

### 视频风格迁移

视频风格迁移技术可以将一个视频的内容与另一个视频的风格结合起来,创造出既包含原始内容又具有新风格效果的视频。这通常需要将风格迁移应用于每一帧图像,然后将这些图像重新组合成视频。

## 风格迁移的商业化前景

随着人们对个性化和创意表达需求的增加,风格迁移技术在商业领域具有广阔的前景。

### 风格迁移在艺术创作中的应用

艺术家们可以利用风格迁移技术来探索新的创意,或是将经典画作的风格应用到现代作品中。同时,它也为普通用户提供了成为数字艺术家的途径,允许他们以简单的方式创造出具有专业水准的艺术作品。

### 风格迁移技术的市场潜力

由于风格迁移技术能够快速生成高质量的内容,它在市场营销、游戏开发、电影后期制作等领域有着广泛的应用。公司可以通过这一技术来降低成本并提高效率,同时创造独特的内容来吸引用户。

## 探索深度学习的其他前沿技术

风格迁移的发展也与其他深度学习技术紧密相连,例如生成对抗网络(GANs)。

### 生成对抗网络(GANs)简介

GANs由两部分组成:生成器和判别器。生成器生成新的数据实例,而判别器评估它们的真实性;生成器的目标是生成足够真实的数据来欺骗判别器。

```mermaid

graph LR

A[生成器] -->|生成数据| B[判别器]

B -->|判断真假| A

```

### GANs在风格迁移中的应用展望

GANs能够生成具有高度逼真度的图像,这使得它们在风格迁移中具有独特优势。例如,GANs可以用来学习特定艺术家的绘画风格,并将其应用于新的内容上,产生震撼的视觉效果。

结合风格迁移与GANs,研究人员已经开发出多种技术,如深度卷积生成对抗网络(DCGAN)和风格生成网络(StyleGAN),它们在生成高质量图像方面展现出巨大潜力。

以上章节内容展示了一些风格迁移技术的最新应用方向和深度学习的相关技术。通过这些内容,我们可以看到风格迁移不仅仅是一种技术,它已经成为推动创意产业发展的强大工具。随着技术的不断进步,我们有理由相信,风格迁移未来将会在更多的领域产生深远影响。

0

0