使用API与Web Scraper进行数据整合

发布时间: 2024-04-13 11:01:55 阅读量: 78 订阅数: 26

WebScraper:使用libcurl API从网页上刮取库存数据

# 1. 理解API和Web Scraper

在现代数据获取与整合领域,API(Application Programming Interface)和Web Scraper是两个核心工具。API是一种定义了通信协议的接口,通过API,不同软件系统之间可以互相通信、共享数据。而Web Scraper则是一种数据抓取工具,可以模拟用户访问网页并提取数据。API通常用于访问特定数据源或服务,获取结构化数据;而Web Scraper则更适合处理需要进行网页解析的数据提取任务。理解API和Web Scraper的差异对于选择合适的数据整合工具至关重要。接下来我们将深入探讨这两种工具的概念、特点以及应用场景。

# 2. 选择合适的数据整合工具

在数据整合的过程中,选择合适的工具至关重要。本章将介绍API和Web Scraper这两种数据整合工具,并详细探讨它们的优势、应用场景以及具体的工具推荐。

### API的优势和应用场景

API,即应用程序接口,可以实现不同软件、系统之间的数据传输和通信。它的设计让开发者可以方便地利用外部服务,从而加快开发速度,提高数据整合的效率。

#### RESTful API介绍

REST 是一种基于 HTTP 协议的轻量级架构风格。通过使用 RESTful API,可以实现对外部资源(如网页、文本、XML、JSON等)的增删改查操作,是现代Web应用中常用的数据交换方式。

```python

import requests

# 示例:通过RESTful API获取用户信息

response = requests.get('https://api.example.com/users/1')

user_info = response.json()

print(user_info)

```

#### GraphQL API简介

与 RESTful API 不同,GraphQL 允许客户端根据需求自定义返回的数据结构,避免了数据冗余和频繁请求的问题。这种灵活性使得GraphQL在需要精细控制数据返回时更加高效。

```python

import requests

# 示例:通过GraphQL API获取用户信息

query = """

{

user(id: 1) {

name

age

}

}

response = requests.post('https://api.example.com/graphql', json={'query': query})

user_info = response.json()

print(user_info)

```

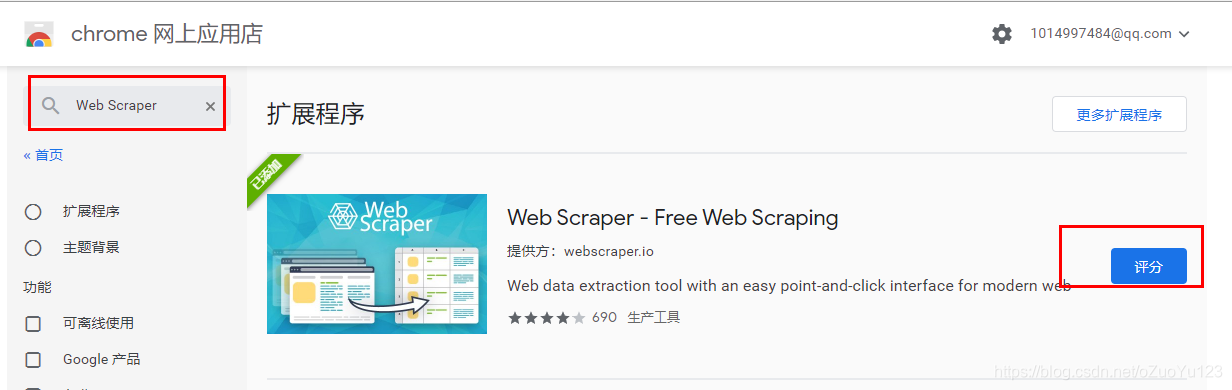

### Web Scraper工具推荐

Web Scraper工具是用来从网页上抓取信息的程序,能够帮助用户快速、自动地获取所需数据,并用于后续的数据整合和分析工作。下面将介绍两种常用的Web Scraper工具。

#### BeautifulSoup库的基本用法

BeautifulSoup 是 Python 中一个常用的 HTML 解析库,可以方便地从 HTML 或 XML 文件中提取数据。它的操作简单直观,适用于对静态网页进行信息抽取。

```python

from bs4 import BeautifulSoup

import requests

# 示例:使用BeautifulSoup解析网页内容

url = 'https://www.example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.title.text

print(title)

```

#### Scrapy框架的特点

Scrapy 是一个功能强大的 Python 爬虫框架,它提供了一个结构化的方式来定义网站抓取和数据提取规则。通过编写 Scrapy 的爬虫程序,可以高效地从多个页面抓取数据并进行深度挖掘。

```python

import scrapy

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['https://www.example.com']

def parse(self, response):

data = response.css('div.data').getall()

for d in data:

yield {

```

0

0