YOLO神经网络与其他目标检测算法的对比分析:一文看懂不同算法的优劣势

发布时间: 2024-08-17 20:16:19 阅读量: 48 订阅数: 38

(179979052)基于MATLAB车牌识别系统【带界面GUI】.zip

# 1. 目标检测算法概述**

目标检测算法是一种计算机视觉技术,用于识别和定位图像或视频中的对象。它在图像处理、视频分析和计算机视觉等领域有着广泛的应用。

目标检测算法通常分为两类:基于区域的算法和基于回归的算法。基于区域的算法首先生成候选区域,然后对每个区域进行分类和回归以预测目标的位置。基于回归的算法直接预测目标的位置和类别,而无需生成候选区域。

目标检测算法的性能通常用平均精度(mAP)来衡量,它衡量算法在不同目标类别和IoU阈值下的检测准确性。

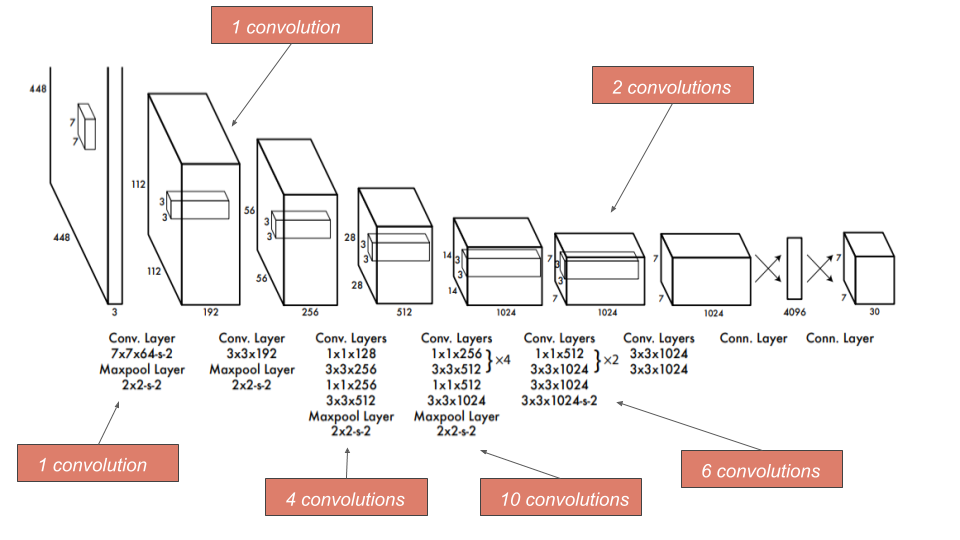

# 2.1 YOLO算法的原理和架构

### 2.1.1 单次卷积检测

YOLO算法的核心思想是将目标检测任务转化为一个回归问题。与传统的目标检测算法不同,YOLO算法不再使用滑动窗口或区域建议网络来生成候选区域,而是直接通过一次卷积操作预测目标的边界框和类别概率。

具体来说,YOLO算法将输入图像划分为一个网格,每个网格单元负责预测该单元内的目标。对于每个网格单元,YOLO算法会预测B个边界框,每个边界框包含5个参数:x、y、w、h和置信度。其中,x和y表示边界框的中心坐标,w和h表示边界框的宽和高,置信度表示该边界框包含目标的概率。

### 2.1.2 Bounding Box预测

YOLO算法使用anchor box来预测目标的边界框。anchor box是一组预定义的边界框,其大小和形状根据训练数据集中的目标特征进行设计。在训练过程中,YOLO算法会学习调整anchor box的参数,以使其与真实目标的边界框尽可能接近。

对于每个网格单元,YOLO算法会预测B个边界框。每个边界框的中心坐标(x, y)是通过相对于网格单元左上角的偏移量预测的。边界框的宽和高(w, h)是通过anchor box的宽和高的缩放因子预测的。

```python

def predict_bounding_boxes(input_tensor, anchor_boxes):

"""预测边界框。

Args:

input_tensor: 输入张量,形状为[batch_size, grid_size, grid_size, num_anchors, 5]。

anchor_boxes: anchor box,形状为[num_anchors, 4]。

Returns:

边界框,形状为[batch_size, grid_size, grid_size, num_anchors, 4]。

"""

# 获取网格单元的偏移量

x_offset = input_tensor[..., 0]

y_offset = input_tensor[..., 1]

# 获取边界框的宽和高缩放因子

w_scale = input_tensor[..., 2]

h_scale = input_tensor[..., 3]

# 预测边界框的中心坐标

x = (x_offset + grid_size) * anchor_boxes[..., 0]

y = (y_offset + grid_size) * anchor_boxes[..., 1]

# 预测边界框的宽和高

w = w_scale * anchor_boxes[..., 2]

h = h_scale * anchor_boxes[..., 3]

# 返回边界框

return tf.stack([x, y, w, h], axis=-1)

```

在预测边界框后,YOLO算法会使用非极大值抑制(NMS)算法来去除重复的边界框。NMS算法根据边界框的置信度和重叠程度来选择最合适的边界框。

# 3. YOLO神经网络的实践应用

### 3.1 YOLO算法的训练和部署

#### 3.1.1 数据集准备和模型训练

**数据集准备:**

YOLO算法需要大量带标注的图像数据集进行训练。常用的数据集包括COCO、VOC和ImageNet。数据预处理包括图像缩放、裁剪和数据增强(如翻转、旋转、颜色抖动)。

**模型训练:**

YOLO模型使用深度学习框架(如PyTorch、TensorFlow)进行训练。训练过程包括以下步骤:

1. **加载数据集:**将预处理后的图像和标注加载到训练器中。

2. **定义模型:**创建YOLO网络架构,包括主干网络、卷积层、池化层和全连接层。

3. **定义损失函数:**使用交叉熵损失和边界框回归损失的组合来计算模型的损失。

4. *

0

0