Q学习算法的实际应用:强化学习中的经典案例

发布时间: 2024-08-20 22:15:58 阅读量: 57 订阅数: 43

# 1. 强化学习基础**

强化学习是一种机器学习技术,它允许智能体通过与环境的交互来学习最佳行动。智能体在环境中采取行动,并根据其行动的奖励或惩罚来更新其行为策略。

强化学习的关键概念包括:

- **状态 (S)**:环境的当前状态。

- **动作 (A)**:智能体可以采取的可用动作。

- **奖励 (R)**:智能体采取特定动作后收到的反馈。

- **值函数 (V)**:给定状态下采取最佳行动的预期累积奖励。

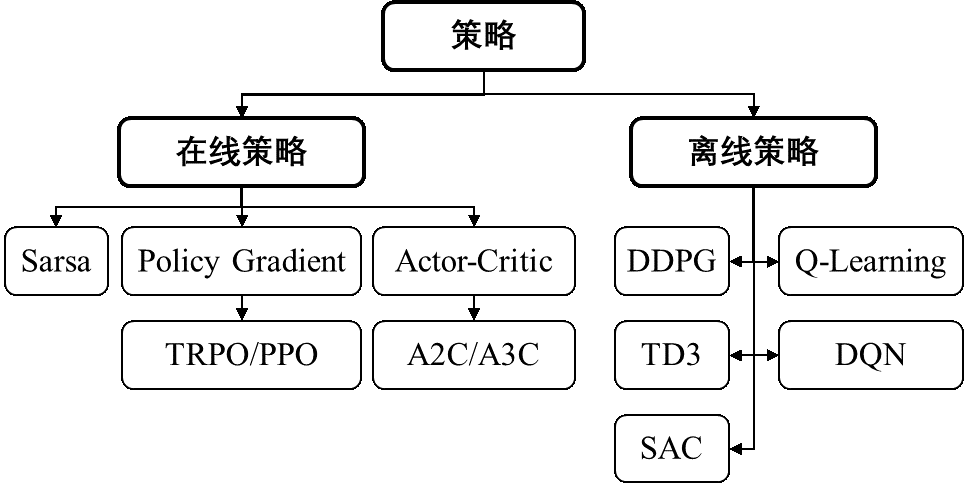

- **策略 (π)**:智能体在给定状态下选择动作的规则。

# 2. 强化学习算法

强化学习算法是强化学习的核心,它决定了智能体如何根据环境反馈进行学习和决策。本章节将介绍三种经典的强化学习算法:Q学习、SARSA和DQN。

### 2.1 Q学习

**2.1.1 Q学习算法原理**

Q学习是一种无模型的强化学习算法,它通过学习状态-动作值函数Q(s, a)来实现决策。Q(s, a)表示在状态s下执行动作a所能获得的长期奖励期望。

Q学习算法的更新公式为:

```python

Q(s, a) <- Q(s, a) + α * (r + γ * max_a' Q(s', a') - Q(s, a))

```

其中:

* α为学习率

* r为当前奖励

* γ为折扣因子

* s'为执行动作a后的下一个状态

* max_a' Q(s', a')为在状态s'下所有可能动作a'中Q值最大的动作

**2.1.2 Q学习算法实现**

```python

def q_learning(env, num_episodes, learning_rate, discount_factor):

# 初始化Q表

q_table = np.zeros((env.observation_space.n, env.action_space.n))

for episode in range(num_episodes):

# 重置环境

state = env.reset()

# 运行该回合

while True:

# 根据Q表选择动作

action = np.argmax(q_table[state, :])

# 执行动作并获取反馈

next_state, reward, done, _ = env.step(action)

# 更新Q表

q_table[state, action] += learning_rate * (reward + discount_factor * np.max(q_table[next_state, :]) - q_table[state, action])

# 更新状态

state = next_state

# 判断是否结束

if done:

break

return q_table

```

### 2.2 SARSA

**2.2.1 SARSA算法原理**

SARSA(状态-动作-奖励-状态-动作)是一种基于策略的强化学习算法,它与Q学习类似,但它使用策略π来选择动作。

SARSA算法的更新公式为:

```python

Q(s, a) <- Q(s, a) + α * (r + γ * Q(s', π(s')) - Q(s, a))

```

其中:

* α为学习率

* r为当前奖励

* γ为折扣因子

* s'为执行动作a后的下一个状态

* π(s')为在状态s'下根据策略π选择的动作

**2.2.2 SARSA算法实现**

```python

def sarsa(env, num_episodes, learning_rate, discount_factor):

# 初始化Q表

q_table = np.zeros((env.observation_space.n, env.action_space.n))

# 初始化策略

policy = np.ones((env.observation_space.n, env.action_space.n)) / env.action_space.n

for episode in range(num_episodes):

# 重置环境

state = env.reset()

# 选择初始动作

action = np.random.choice(env.action_space.n)

# 运行该回合

while True:

# 执行动作并获取反馈

next_state, reward, done, _ = env.step(action)

# 根据策略选择下一个动作

next_action = np.argmax(policy[next_state, :])

# 更新Q表

q_table[state, action] += learning_rate * (reward + discount_factor * q_table[next_state, next_action] - q_table[state, action])

# 更新策略

policy[state, action] += learning_rate * (reward + discount_factor * q_table[next_state, next_action] - policy[state, action])

# 更新状态和动作

state = next_state

action = next_action

# 判断是否结束

if done:

break

return q_table, policy

```

### 2.3 DQN

**2.3.1 DQN算法原理**

DQN(深度Q网络)是一种基于神经网络的强化学习算法,它通过学习状态-动作值函数Q(s, a)来实现决策。与Q学习不同,DQN使用一个深度神经网络来近似Q函数。

DQN算法使用一个目标网络和一个在线网络。目标网络定期更新,以提供稳定的目标值。在线网络则不断学习,并通过最小化与目标网络的损失函数来更新。

**2.3.2 DQN算法实现**

```python

import tensorflow as tf

class DQN:

def __init__(self, env, learning_rate, discount_factor):

self.env = env

self.learning_rate = learning_rate

self.discount_factor = discount_factor

# 初始化在线网络和目标网络

self.online_network = self.build_network()

self.target_network = self.build_network()

# 初始化经验回放池

self.replay_buffer = []

def build_network(self):

# 定义输入层

input_layer = tf.keras.layers.Input(shape=(self.env.observation_space.shape,))

# 定义隐藏层

hidden_layer = tf.keras.layers.Dense(128, activation='relu')(input_layer)

# 定义输出层

output_layer = tf.keras.layers.Dense(self.env.action_space.n, activation='linear')(hidden_layer)

# 构建模型

model = tf.keras.Model(input_layer, output_layer)

return model

def train(self, num_episodes, batch_size):

for

```

0

0