Java中间件日志管理优化:ELK与Log4j2结合使用的最佳策略

发布时间: 2024-11-14 18:29:40 阅读量: 19 订阅数: 26

Nodejs Express 通过log4js写日志到Logstash(ELK)

# 1. Java中间件日志管理概述

## 1.1 日志管理的重要性

日志作为软件开发和系统运维的重要组成部分,记录了应用程序运行的状态和行为。在Java中间件开发中,有效地管理日志不仅有助于快速定位和解决生产环境中的问题,还能为系统性能分析、安全审计、合规性验证提供支持。一个成熟的日志管理系统可以显著提高企业对软件的监控能力和故障响应速度。

## 1.2 日志管理的挑战

尽管日志对于故障排查和系统优化至关重要,但在实际应用中,日志管理面临着挑战。首先,随着系统复杂性的增加,日志数据量激增,导致存储和检索困难;其次,日志格式的不统一使得日志的聚合和分析变得复杂;最后,日志安全和合规性要求日益严格,对日志管理提出了更高的要求。

## 1.3 Java中间件日志管理的解决方案

Java中间件日志管理解决方案需要一个高效、可扩展的架构来处理大量的日志数据。通常包括以下几个关键部分:一个健壮的日志框架,如Log4j2,用于日志的生成和管理;一个强大的日志聚合系统,如ELK Stack(Elasticsearch, Logstash, Kibana),用于日志数据的收集、分析和可视化;以及有效的日志策略和标准,来确保日志的质量和一致性。

接下来的章节中,我们将深入探讨ELK技术栈的核心机制和Log4j2日志框架的详细使用,以及它们如何共同为Java中间件日志管理提供强大支持。

# 2. ELK技术栈深入了解

### 2.1 Elasticsearch核心机制

#### 2.1.1 索引管理与数据流

Elasticsearch是ELK技术栈的核心组件,它负责存储、检索和分析大量的日志数据。理解索引管理和数据流是掌握Elasticsearch的关键。一个索引(Index)是具有相同结构的文档集合,可以类比于关系数据库中的一个表。Elasticsearch使用倒排索引来快速进行全文搜索。

在索引创建后,Elasticsearch会自动分配一个名为_type_的字段用于标识文档类型。但自7.0.0版本起,Elasticsearch已经废弃了_type_的概念,统一索引结构成为单一类型,即每个索引只存储一种文档类型。每个文档都会被分配一个唯一标识符(ID),如果没有显式指定,Elasticsearch会自动生成。

数据流是Elasticsearch 7.0及以上版本引入的新特性,它简化了数据从源到存储的处理过程。数据流可以被视为索引的集合,并且可以跨越多个索引进行查询和管理。例如,可以为一个应用的访问日志创建一个数据流,然后它会自动管理底层索引的生命周期,包括创建、滚动和删除。

```json

PUT /my-index-000001

{

"mappings": {

"properties": {

"@timestamp": { "type": "date" },

"message": { "type": "text" }

}

}

}

```

上面的代码块创建了一个名为`my-index-000001`的新索引,并定义了映射(mappings),指定了字段类型。`@timestamp`字段被设置为日期类型,`message`字段被设置为文本类型。这使得Elasticsearch知道如何索引这些字段以及如何执行查询。

#### 2.1.2 查询DSL的使用技巧

Elasticsearch提供了丰富的查询DSL(Domain Specific Language),它允许用户定义复杂的查询。查询DSL使用JSON格式,它为用户提供了构建查询的强大方式。常见的查询包括匹配查询(match query)、范围查询(range query)和多字段查询(multi-field query)等。

使用查询DSL,我们可以根据需要精确地对数据进行搜索。例如,我们可以通过以下查询来找出所有在特定时间范围内的日志条目:

```json

GET /my-index-000001/_search

{

"query": {

"range": {

"@timestamp": {

"gte": "now-1h/h",

"lte": "now",

"time_zone": "+08:00"

}

}

}

}

```

在这个查询中,我们使用了`range`查询来获取在过去一小时内所有时间戳在`@timestamp`字段中的日志条目。查询中的`gte`表示大于等于(greater than or equal to)和`lte`表示小于等于(less than or equal to)。`time_zone`参数用来指定查询时区,这对于处理跨时区的日志数据非常有用。

Elasticsearch的查询DSL非常灵活,可以通过组合不同的查询类型和过滤器(filter)来完成复杂的数据检索任务。掌握好查询DSL可以让Elasticsearch的搜索能力得以充分发挥。

### 2.2 Logstash数据处理流程

#### 2.2.1 Logstash的输入插件

Logstash是ELK技术栈中负责数据收集和处理的部分。它通过各种插件机制来处理不同来源和格式的数据。Logstash的核心是管道(pipeline),它包含了输入(input)、过滤器(filter)和输出(output)三个主要部分。管道将输入端获取的数据流经过滤器进行处理,最后输出到指定的目的地。

Logstash的输入插件负责从不同的源收集数据。常见的输入插件包括文件(file)、TCP/UDP(tcp、udp)、syslog(syslog)、HTTP(http)等。通过不同的输入插件,Logstash可以从文件系统、网络、消息队列等多种途径收集数据。

例如,使用Logstash的`file`插件从文件系统收集日志:

```conf

input {

file {

path => "/var/log/app.log"

start_position => "beginning"

sincedb_path => "/dev/null"

}

}

```

在这个配置中,我们指定了Logstash监控`/var/log/app.log`文件的变动,并从文件的开始位置读取数据。`sincedb_path`设置为`/dev/null`是为了防止Logstash记录已读取的文件位置,因为我们希望持续地从文件开始读取。

通过各种输入插件,Logstash可以高效地整合各种日志数据,为后续的日志管理和分析打下基础。

#### 2.2.2 Logstash的过滤器与输出插件

过滤器(filter)是Logstash管道中用于处理和转换数据的关键组件。它们可以对数据进行解析、修改、增强等操作。Logstash提供了大量的过滤器插件,例如grok、mutate、drop等。

- `grok`过滤器可以将原始文本数据解析成结构化数据,这对于处理非结构化或半结构化日志特别有用。

- `mutate`过滤器可以修改字段,例如重命名、转换字段类型、合并字段等。

- `drop`过滤器可以用来丢弃不符合条件的日志条目,从而过滤掉不需要的噪声数据。

在处理完数据后,Logstash需要将数据输出到某个地方,输出插件(output)负责将处理后的数据发送到目标系统。常见的输出插件包括Elasticsearch、文件(file)、Redis等。

例如,将处理后的数据输出到Elasticsearch:

```conf

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "processed-app-%{+YYYY.MM.dd}"

}

}

```

在这个配置中,我们指定了输出到本地运行的Elasticsearch实例,并且指定了一个动态的索引名模板`processed-app-%{+YYYY.MM.dd}`,根据当前日期动态创建索引。

通过灵活地使用过滤器和输出插件,Logstash可以完成复杂的数据处理任务,满足企业对日志数据的处理需求。

# 3. Log4j2日志框架详解

## 3.1 Log4j2的基本配置和使用

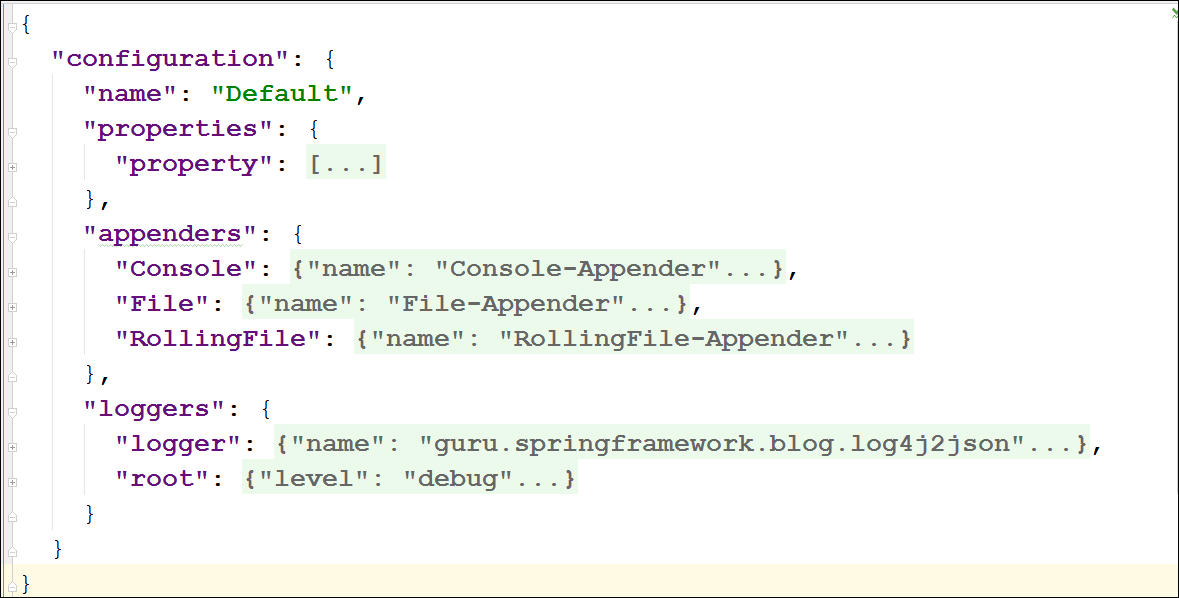

### 3.1.1 Log4j2的配置文件解析

Log4j2 是一个广泛使用的 Java 日志库,它允许开发人员通过简单配置来控制日志记录行为。配置文件通常使用 XML、JSON、YAML 或 Properties 格式。这里我们将重点讨论 XML 和 Properties 格式的配置方法。

在 XML 格式的配置中,`log4j2.xml` 文件位于类路径的根目录。该配置文件包含多个组件:`Appenders`、`Logger

0

0