【迁移状态监控】:实时跟踪PostgreSQL到达梦的10个实用工具

发布时间: 2025-01-03 22:37:16 阅读量: 13 订阅数: 17

migrate:PostgreSQL迁移的命令行工具

# 摘要

本文旨在介绍PostgreSQL与达梦数据库之间的迁移基础、准备工作以及迁移工具的选择与配置。文章首先分析了数据库结构和数据类型的差异,并探讨了数据清洗和预处理的重要性。接着,详细介绍了实时迁移监控工具的必要性、挑战以及实用工具的对比分析。文章进一步深入到工具的安装、配置与实际操作,并对迁移过程中的状态监控和问题排查进行了详细阐述。最后,总结了迁移过程的最佳实践,并对迁移监控技术的未来发展方向进行了展望,提出技术创新点和改进建议。

# 关键字

PostgreSQL;达梦数据库;数据迁移;监控工具;状态监控;问题排查

参考资源链接:[PostgreSQL数据迁移达梦数据库:步骤详解与解决方法](https://wenku.csdn.net/doc/3g09fs18ue?spm=1055.2635.3001.10343)

# 1. PostgreSQL与达梦数据库的迁移基础

## 1.1 数据库迁移概述

数据库迁移是指将一个数据库系统中的数据和数据库对象从一个环境转移到另一个环境的过程。在企业技术升级、系统重构或跨平台应用部署时,数据库迁移是常见的操作之一。特别是在选择使用 PostgreSQL 作为开源数据库解决方案,而达梦数据库则作为国产数据库代表时,两者之间的迁移更显得尤为重要。

## 1.2 PostgreSQL与达梦数据库特点

PostgreSQL 是一个成熟的开源关系数据库管理系统,以其稳定性、扩展性、开源性而受到全球开发者的青睐。它支持复杂的查询、外键、触发器、视图和事务完整性。

达梦数据库是国产数据库产品之一,专门为满足中国用户对数据库的各种需求而设计。它支持SQL标准,具备高安全、高可用、高性能的特点,并且符合中国法律法规的要求。

## 1.3 迁移的必要性与挑战

随着企业数据量的日益庞大,以及数据安全性和合规性的要求提高,数据库迁移的必要性愈发显著。迁移的主要挑战包括数据的完整性、迁移过程的无中断、性能的保持以及新旧系统兼容性问题。

通过理解这些基础概念,我们可以更好地把握数据库迁移的关键点,为接下来的准备工作和迁移策略的制定打下坚实基础。

# 2. 迁移前的准备工作与工具选择

### 2.1 数据库结构和数据类型分析

#### 2.1.1 数据库架构的对比分析

在进行数据库迁移时,首先要分析源数据库与目标数据库之间的架构差异。架构分析涉及数据库的表结构、索引、触发器、存储过程、视图等对象。不同数据库系统之间的架构差异可能很大,需要特别注意。

例如,PostgreSQL 与 达梦数据库在存储过程编写和使用上可能有不同的语法和函数支持。详细对比两者的功能特性,识别哪些对象可以1:1映射,哪些需要特别调整或转换,是迁移前必须要做的功课。

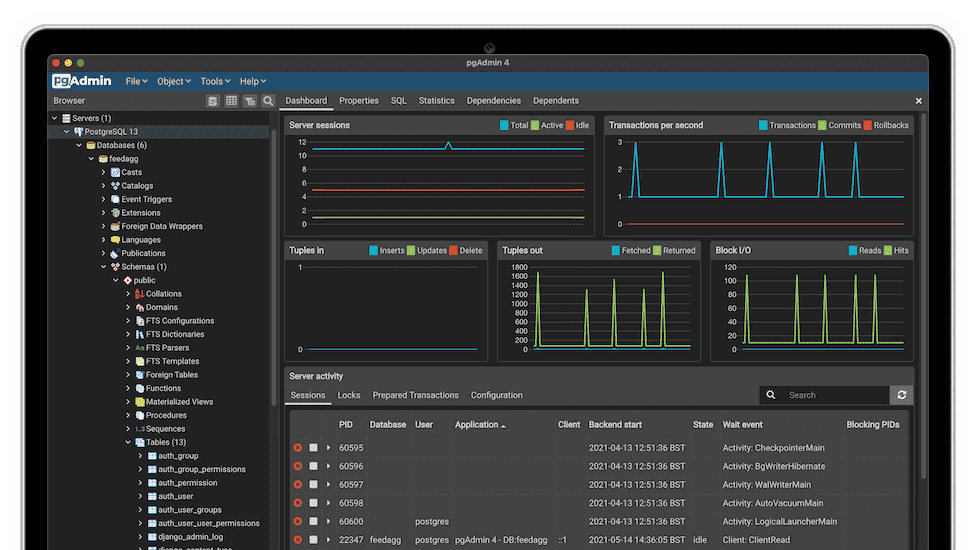

具体操作时,可以使用各自的数据库管理工具导出元数据,例如使用pgAdmin导出PostgreSQL的表结构定义,再与达梦数据库通过工具如DMMS导出的元数据进行对比,创建一个对象映射报告。

#### 2.1.2 数据类型的一致性和转换策略

数据类型的一致性直接影响数据迁移的准确性。需要分析两种数据库在数据类型上的异同,并制定相应的转换策略。比如PostgreSQL支持的JSON类型在达梦数据库中可能要转换为文本类型或者通过特殊的JSON数据类型来处理。

在确定数据类型转换策略时,要考虑到数据精度、范围、以及存储空间的差异。表格类型的对比是关键,以表格形式清晰地列出每种数据类型在两种数据库中的映射关系。

```markdown

| PostgreSQL 数据类型 | 达梦数据库数据类型 | 转换策略 |

|---------------------|---------------------|----------|

| INT | INTEGER | 直接映射 |

| SERIAL | NUMBER(9) | 直接映射 |

| JSON | TEXT | 转换为文本并解析 |

```

### 2.2 数据迁移前的数据清洗和预处理

#### 2.2.1 清洗数据的重要性

数据清洗是保证数据质量和完整性的关键步骤。在迁移前彻底清洗数据可以避免将错误或不一致的数据迁移到新数据库中。数据清洗包括识别和纠正错误的记录、删除重复数据、填充缺失值等。

对数据清洗的重视程度直接关系到迁移的成功与否。使用数据清洗工具如OpenRefine可以帮助识别数据质量问题并提供批量处理功能。

#### 2.2.2 实用的数据预处理工具和方法

在实际操作中,数据预处理是一个需要大量手动参与的过程,但也有一些工具可以自动化处理一部分任务。比如,可以使用SQL脚本对特定的错误或异常进行批量修正,也可以采用R或Python语言中数据处理库如Pandas进行更为复杂的数据处理。

```python

import pandas as pd

# 读取数据

df = pd.read_csv('data.csv')

# 处理空值

df.fillna(method='ffill', inplace=True)

# 写入清洗后的数据到新文件

df.to_csv('clean_data.csv', index=False)

```

### 2.3 迁移工具的性能评估与选择

#### 2.3.1 迁移工具的功能对比

在选择迁移工具时,需要基于其功能集、易用性、兼容性以及迁移的可靠性进行评估。常见的数据库迁移工具包括开源的如pgLoader,以及商业的如Oracle的Data Integrator等。每种工具都有自己的特定优势和局限性,例如:

- **pgLoader**:支持PostgreSQL到PostgreSQL的迁移,并可以处理大量的数据类型转换。

- **Oracle Data Integrator**:适用于复杂的Oracle迁移,但可能需要额外的配置工作。

#### 2.3.2 性能测试与评估标准

性能测试需要在与实际环境相似的测试环境中进行。测试标准应该包含数据迁移的速度、中断服务的时间、以及迁移过程中数据的一致性和完整性。

使用实际的数据集进行性能测试,记录迁移前后的数据库性能,包括读写速度、查询响应时间等。可以构建一个表格来记录不同工具的性能测试结果:

```markdown

| 迁移工具 | 数据迁移速度 | 中断服务时间 | 数据一致性检查 | 总体评价 |

|--------------|--------------|--------------|----------------|----------|

| pgLoader | 5GB/小时 | 10分钟 | 一致 | 良

```

0

0