【R语言深度学习】:用Keras打造R语言中的深度学习模型

发布时间: 2024-11-01 20:44:41 阅读量: 43 订阅数: 34

# 1. R语言与深度学习概览

## 1.1 R语言在数据分析中的应用

R语言是一个专门用于统计分析和图形表示的编程语言和环境,它的语法简洁明了,非常适合于数据分析领域。R语言拥有强大的库,可以进行数据清洗、处理、模型建立以及结果展示。此外,R语言还提供了大量用于深度学习的扩展包,使得在R环境中实现复杂的机器学习任务变得可能。

## 1.2 深度学习的发展与意义

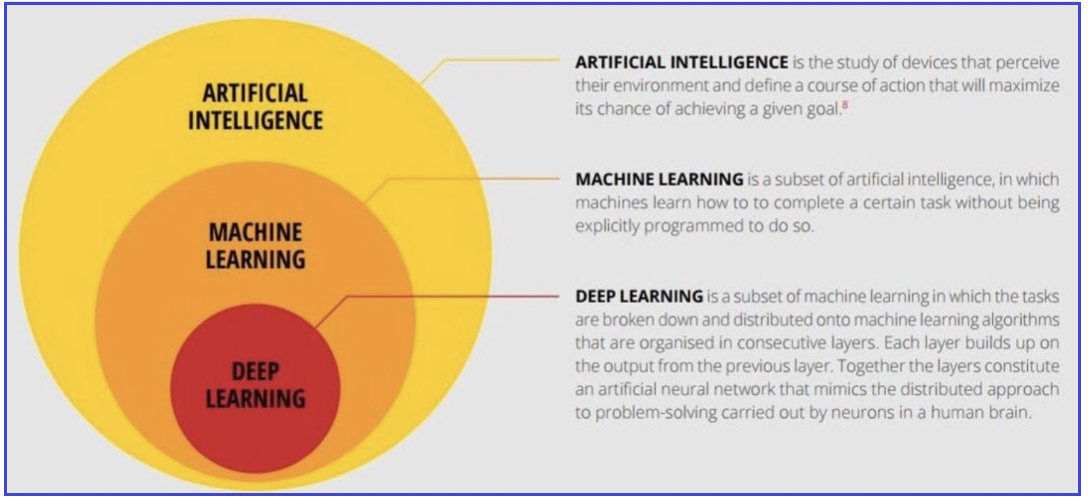

深度学习是机器学习的一个分支,它通过模仿人脑神经网络的结构,使得机器能够从大量的数据中学习复杂的模式和特征。近年来,深度学习在图像识别、语音识别、自然语言处理等领域取得了突破性的成果。它的出现推动了人工智能的快速发展,并为各行各业带来了革新。

## 1.3 R语言与深度学习的结合

将R语言和深度学习结合,不仅可以利用R在统计分析上的优势,还可以通过深度学习模型解决更加复杂的非线性问题。这使得R语言用户能够在保留已知统计分析工具和数据处理能力的同时,进一步拓展数据分析的深度和广度。本章将为读者提供一个R语言和深度学习结合的概览,为后续章节深入探讨打下基础。

# 2. 深度学习基础理论

### 2.1 神经网络基础

神经网络是深度学习的基石,它模仿人类大脑的神经元网络结构,通过多层处理单元来进行数据的转换和学习。理解神经网络的基础概念,对于深入研究深度学习至关重要。

#### 2.1.1 神经元和层的概念

神经元是构成神经网络的基本单元,它接收输入信号,对这些信号进行加权求和,然后通过一个非线性激活函数生成输出。一个神经元可以类比为一个决策树节点,其决策能力由输入信号的加权和决定,而激活函数则为决策提供了非线性变换的能力,确保神经网络可以学习复杂的模式。

在多层神经网络中,神经元被组织成多个层次,每层可以包含多个神经元。数据在神经网络中的流动从输入层开始,逐层传递,直到输出层产生最终的预测结果。每一层的神经元可以分为三类:

- **输入层**:接收原始数据作为输入。

- **隐藏层**:位于输入层和输出层之间,负责数据的特征学习。

- **输出层**:根据前一层的输出生成最终的预测结果。

层与层之间通过权重连接,权重是神经网络中的学习参数,决定了神经元之间信号的强度。通过不断地训练和优化权重,神经网络能够逐渐提升其预测准确性。

```mermaid

graph LR

A[输入层] -->|权重| B[隐藏层]

B -->|权重| C[输出层]

```

#### 2.1.2 激活函数的作用与选择

激活函数为神经网络引入非线性因素,使得网络能够学习和表示复杂的函数。如果没有激活函数,无论神经网络有多少层,最终的表现形式都仅仅是输入的线性组合,极大地限制了网络的表达能力。常见的激活函数包括:

- **Sigmoid**:将输入压缩到0和1之间,适用于二分类问题。

- **Tanh**:类似于Sigmoid,但输出范围是-1到1,通常比Sigmoid函数具有更好的收敛性能。

- **ReLU (Rectified Linear Unit)**:将所有负值置为0,正值保持不变,计算简单且通常比Sigmoid和Tanh收敛更快。

- **Leaky ReLU**:ReLU的一个变种,对于负值采用一个小的固定斜率,避免了ReLU在负值区间的“死亡”问题。

选择合适的激活函数对于模型的性能至关重要。一般情况下,ReLU及其变种在隐藏层中表现较好,而Sigmoid和Tanh则常用于输出层,特别是在需要概率输出的场合。

```python

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def tanh(x):

return np.tanh(x)

def relu(x):

return np.maximum(0, x)

def leaky_relu(x, alpha=0.01):

return np.where(x > 0, x, x * alpha)

```

在上述代码块中,我们定义了四种激活函数。`sigmoid`函数将输入压缩到0和1之间,`tanh`函数的输出范围是-1到1。`relu`函数将所有负值置为0,正值保持不变。`leaky_relu`函数则为负值提供了一个小的固定斜率。

### 2.2 优化算法与损失函数

为了训练神经网络,我们需要定义一个损失函数来衡量模型的预测值与真实值之间的差异,并选择合适的优化算法来最小化这个损失函数。

#### 2.2.1 常见的优化算法

优化算法负责调整神经网络中的权重,以便最小化损失函数。以下是一些常见的优化算法:

- **梯度下降法**:基本的优化算法,通过计算损失函数相对于权重的梯度,然后沿着梯度的反方向更新权重。

- **随机梯度下降法(SGD)**:在梯度下降法的基础上加入了随机性,每次更新只基于一个或者一小部分样本。

- **动量法(Momentum)**:在更新权重时加入动量项,有助于加速SGD并减少震荡。

- **Adagrad**:自适应学习率方法,对每个参数使用不同的学习率。

- **RMSprop**:一种自适应学习率方法,用于解决Adagrad的学习率衰减问题。

- **Adam**:结合了Momentum和RMSprop的方法,是一种目前非常流行的优化算法。

每种优化算法都有其优缺点,并适用于不同的场景。选择哪种算法往往需要根据具体问题和经验进行尝试。

#### 2.2.2 损失函数的类型及应用场景

损失函数用于衡量模型的预测值和真实值之间的差异。不同的问题类型通常需要不同的损失函数:

- **均方误差(MSE)**:常用于回归问题,衡量预测值和真实值之间的平均平方差。

- **交叉熵(Cross-Entropy)**:用于分类问题,衡量两个概率分布之间的差异。

- **对数损失(Log Loss)**:是交叉熵在二分类问题上的特例,常用于二元分类问题。

损失函数的选择依赖于具体的问题类型和需求。例如,对于多分类问题,我们可能会选择多类交叉熵损失函数。

### 2.3 模型正则化与泛化能力

在深度学习中,正则化是避免过拟合(模型在训练数据上表现良好,但在未知数据上表现差)和提升模型泛化能力(在新数据上的预测能力)的重要手段。

#### 2.3.1 过拟合与欠拟合的识别

过拟合和欠拟合是两种常见的模型训练问题。

- **过拟合**:模型对训练数据的噪声和细节学习过多,导致模型泛化能力差。

- **欠拟合**:模型过于简单,无法捕捉数据的底层规律,同样导致泛化能力差。

识别过拟合与欠拟合的常用方法包括:绘制训练和验证的损失或准确率曲线,检查模型在训练集和验证集上的性能差异,以及检查学习曲线的走势。

#### 2.3.2 正则化技术的应用

为了防止过拟合,可以采用多种正则化技术:

- **权重衰减(L2正则化)**:在损失函数中增加一个权重平方的惩罚项,通过限制权重值的大小,防止模型复杂度过高。

- **Dropout**:在训练过程中随机“丢弃”部分神经元,迫使网络学习更鲁棒的特征。

- **数据增强**:通过对训练数据进行变换(如旋转、缩放、裁剪等),增加数据多样性,从而提高模型泛化能力。

- **早停法(Early Stopping)**:在验证集上监视模型性能,一旦性能不再提升,则停止训练。

在实际应用中,可以根据具体情况结合使用多种正则化技术。

```python

from keras.layers import Dropout

from keras.callbacks import EarlyStopping

# 示例代码,展示如何在Keras中应用Dropout和EarlyStopping

model = Sequential([

...

Dense(64, activation='relu'),

Dropout(0.5), # 在隐藏层后添加Dropout

...

])

early_stopping = EarlyStopping(monitor='val_loss', patience=3)

model.fit(x_train, y_train, epochs=50, validation_data=(x_val, y_val), callbacks=[early_stopping])

```

在上述代码段中,我们首先导入了必要的Keras组件。然后在模型构建中添加了Dropout层,并在模型训练时使用了EarlyStopping回调函数。这有助于提高模型的泛化能力,避免过拟合。

# 3. Keras框架详解

## 3.1 Keras的基本构成

### 3.1.1 Keras与TensorFlow的关系

Keras是一个高层神经网络API,最初被设计为可以快速实验多种深度学习架构的平台,它具备高度的模块化、易扩展性和对CPU和GPU的支持。Keras可以在Python中运行,并且它能够运行在TensorFlow、Microsoft Cognitive Toolkit (CNTK) 或者 Theano之上。尽管Keras能够与多种后端进行配合,但它的主要目标是作为TensorFlow的高层API而存在,因此,理解Keras与TensorFlow的关系对于构建高效的深度学习模型至关重要。

在使用Keras时,我们可以指定后端引擎,这在Keras配置文件或者在创建模型之前通过`backend`模块来设定。Keras主要利用了TensorFlow的计算图(Graph)和会话(Session)概念,来有效地管理底层的计算资源。这种设计让Keras可以聚焦于构建和编译神经网络模型,而将张量操作、梯度计算和会话执行等底层细节交由TensorFlow处理。

**代码示例:** 如何在Keras中设置TensorFlow为后端引擎。

```python

from keras import backend as K

# 设置TensorFlow为后端引擎

K.set_backend('tensorflow')

# 可以检查当前后端是否为TensorFlow

print(K.backend()) # 输出: 'tensorflow'

```

### 3.1.2 序列模型与函数式API

在Keras中,有两种主要的方式来构建神经网络模型:序列模型(Sequential)和函数式API(Functional API)。序列模型是一种线性堆叠层的方式,每个层只有一个输入和输出,非常适合于常见的神经网络结构。函数式API则提供了更高的灵活性,允许构建任意结构的模型,包括具有多个输入或输出的模型。

**序列模型**是Keras中最简单的模型类型,它通过`Sequential`类实现,可以通过添加层的方式(使用`.add()`方法)来构建。

```python

from keras.models import Sequential

from keras.layers import Dense

# 创建一个Sequential模型实例

model = Sequential()

# 添加层到模型中

model.add(Dense(64, activation='relu', input_shape=(100,)))

model.add(Dense(10, activation='softmax'))

# 查看模型概况

model.summary()

```

**函数式API**则是通过`Model`类来构建复杂的模型结构。函数式API允许我们定义一个层的多输入和多输出模型,并且可以方便地实现共享层结构。

```python

from keras.layers import Input, Dense

from keras.models import Model

# 定义输入层,指定输入的形状

input_tensor = Input(shape=(100,))

# 定义第一个隐藏层,使用Dense层

x = Dense(64, activation='relu')(input_tensor)

# 定义输出层

output_tensor = Dense(10, activation='softmax')(x)

# 创建一个Model实例

model = Model(inputs=input_tensor, outputs=output_tensor)

# 查看模型概况

model.summary()

```

在选择模型构建方式时,如果模型结构较为简单且符合线性堆叠的特征,那么使用序列模型会更加简单。而当遇到需要构建复杂的神经网络结构时,如具有共享层、多输出的模型,函数式API会是更好的选择。

## 3.2 高级接口与模型编排

### 3.2.1 回调函数的使用

在深度学习模型的训练过程中,回调函数(Callbacks)是一种非常有用的工具,允许在训练过程中的某些点(如每个epoch开始或结束时)执行自定义操作。Keras提供了多种内置的回调函数,例如`ModelCheckpoint`、`EarlyStopping`等,也可以让用户自定义回调函数来满足特定需求。

**

0

0