因果推断与机器学习的性能评估:衡量因果关系分析的准确性和鲁棒性

发布时间: 2024-08-22 20:57:57 阅读量: 73 订阅数: 24

因果-机器学习.pdf

# 1. 因果推断基础**

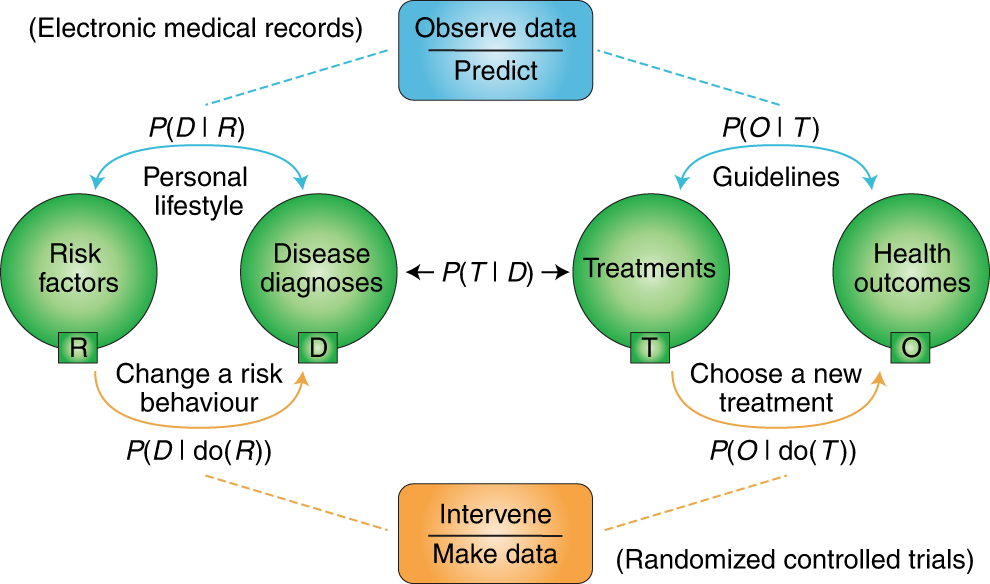

因果推断是确定事件之间因果关系的过程。它在机器学习中至关重要,因为能够理解和利用因果关系可以提高模型的性能和可解释性。

因果关系可以通过观察数据来推断,但这种方法受到混杂因素的影响,即可能同时影响因和果的其他因素。为了解决这个问题,因果推断方法使用各种技术,例如随机对照试验、匹配和加权,以控制混杂因素并估计因果效应。

# 2. 机器学习模型在因果推断中的应用**

**2.1 机器学习算法的因果推断能力**

**2.1.1 监督学习算法**

监督学习算法利用标记数据学习输入和输出之间的关系。它们在因果推断中具有以下优点:

- **预测性:**监督学习模型可以预测给定输入的输出,从而可以推断输入和输出之间的因果关系。

- **鲁棒性:**这些模型对数据噪声和异常值具有鲁棒性,使其能够从现实世界数据中学习因果关系。

常见的监督学习算法包括:

- **线性回归:**用于预测连续输出。

- **逻辑回归:**用于预测二进制输出。

- **决策树:**用于预测分类输出。

**2.1.2 无监督学习算法**

无监督学习算法利用未标记数据发现数据中的模式和结构。它们在因果推断中具有以下优点:

- **探索性:**无监督学习算法可以发现数据中隐藏的因果关系,而无需先验知识。

- **生成性:**这些算法可以生成新数据,从而可以模拟因果关系并进行预测。

常见的无监督学习算法包括:

- **聚类:**将数据点分组为具有相似特征的簇。

- **主成分分析(PCA):**将高维数据投影到低维空间,从而揭示数据中的主要模式。

- **异常值检测:**识别与数据其余部分明显不同的数据点。

**2.2 机器学习模型的因果推断实践**

**2.2.1 数据预处理和特征工程**

在使用机器学习模型进行因果推断之前,必须对数据进行预处理和特征工程。这包括:

- **数据清理:**删除缺失值、异常值和重复数据。

- **特征选择:**选择与因果关系相关的特征。

- **特征转换:**将特征转换为更适合因果推断的格式。

**2.2.2 模型训练和评估**

一旦数据准备好,就可以训练机器学习模型。模型训练涉及调整模型参数以最小化损失函数。模型评估涉及使用验证数据评估模型的性能。

因果推断中常用的评估指标包括:

- **平均绝对误差(MAE):**预测值与真实值之间的平均绝对差。

- **均方根误差(RMSE):**预测值与真实值之间的均方根差。

- **R 平方(R^2):**模型预测值与真实值之间拟合程度的度量。

**示例代码:**

```python

import pandas as pd

from sklearn.linear_model import LinearRegression

# 加载数据

data = pd.read_csv('data.csv')

# 数据预处理

data = data.dropna()

data = data.drop_duplicates()

# 特征工程

data['feature_1'] = data['feature_1'].astype('float')

data['feature_2'] = data['feature_2'].astype('category')

# 模型训练

model = LinearRegression()

model.fit(data[['feature_1', 'feature_2']], data['target'])

# 模型评估

mae = mean_absolute_error(model.predict(data[['feature_1', 'feature_2']]), data['target'])

rmse = mean_squared_er

```

0

0