实时推理中的知识蒸馏技术:提升模型性能的高效方法(权威解读)

发布时间: 2024-09-04 08:55:34 阅读量: 200 订阅数: 88

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. 知识蒸馏技术简介

随着深度学习模型的性能不断提升,模型大小和计算复杂度也在不断增加。这不仅限制了模型在资源有限的设备上的部署,还影响了模型的推理速度。为了解决这一挑战,知识蒸馏技术应运而生。它通过将大型复杂模型(教师模型)的知识转移到小型模型(学生模型)中,来实现性能与资源消耗之间的平衡。这种方法不仅可以提升模型的泛化能力,还能有效地减少模型在部署时的资源需求。在本章节中,我们将探讨知识蒸馏的基本概念,以及它如何帮助我们优化深度学习模型,使其更加轻量级且易于部署。

# 2. 理论基础与方法论

## 2.1 知识蒸馏的理论背景

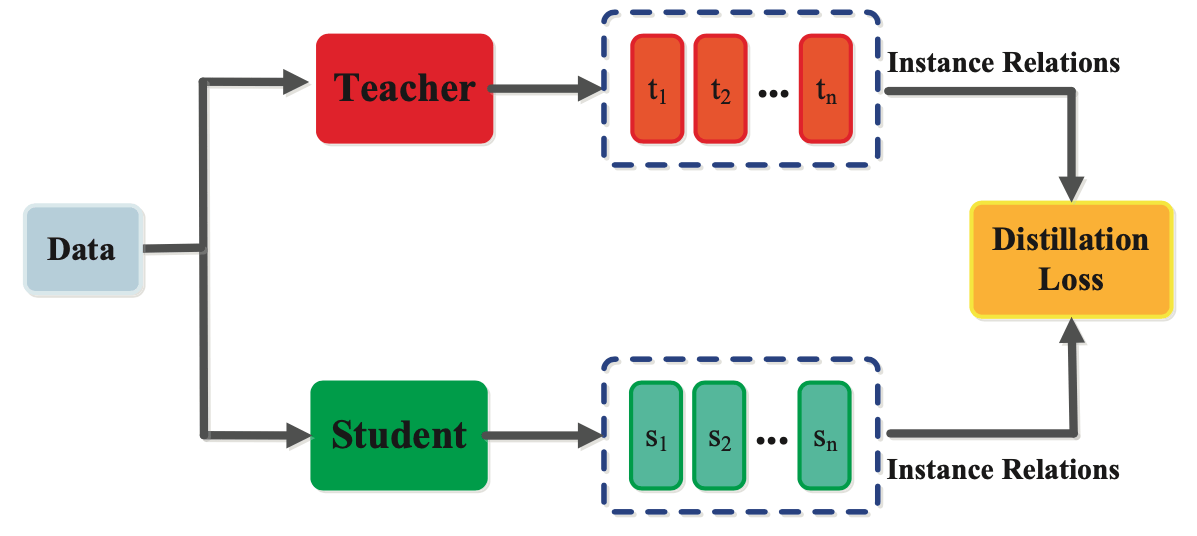

知识蒸馏(Knowledge Distillation)是模型压缩的一种技术,其核心思想是将一个复杂度较高的模型(教师模型)的知识转移到一个较小的模型(学生模型)中。这种方法尤其适用于深度神经网络模型,它能够在不显著降低准确性的前提下,减小模型的体积,降低计算资源的使用。

### 2.1.1 模型复杂度与泛化能力

在神经网络模型中,复杂度较高的模型拥有大量的参数,能够拟合较为复杂的函数,从而具有较强的泛化能力。然而,这种复杂度也带来了许多缺点,如训练时间长、存储和推理成本高,且容易过拟合,导致模型泛化能力的下降。因此,研究者提出知识蒸馏的概念,旨在通过从大型网络中提取知识来指导小型网络的训练,使其在保持较高准确率的同时拥有更少的参数。

### 2.1.2 软标签与硬标签的差异

传统的监督学习使用硬标签(one-hot编码),只提供目标类别的信息,忽略了其他类别的重要性。相比之下,软标签(soft targets)包含了所有类别的概率分布,即使不完全正确,也能够提供更加丰富和有用的信息。知识蒸馏正是利用软标签,来传达教师模型的中间表示信息,使得学生模型能够学习到更多细节,从而达到更好的学习效果。

## 2.2 知识蒸馏的技术流程

### 2.2.1 教师模型与学生模型

知识蒸馏的流程中,首先需要准备两个模型:教师模型和学生模型。教师模型是一个预训练过的、性能良好的大型模型,它具有高度复杂性和良好的学习能力。学生模型是需要训练的小型模型,其参数数量相对较少,需要通过知识蒸馏来达到与教师模型相近的性能。

### 2.2.2 损失函数的设计与优化

在知识蒸馏的过程中,损失函数的设计至关重要。损失函数不仅要考虑对学生模型预测结果与真实标签之间的差异,还要考虑学生模型输出与教师模型输出之间的差异。这种损失函数被称为蒸馏损失函数。一个经典的蒸馏损失函数的构造通常包含两部分:一部分是学生模型预测与真实标签之间的交叉熵损失,另一部分是学生模型与教师模型输出软标签之间的KL散度或其他形式的损失。

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class DistillationLoss(nn.Module):

def __init__(self, alpha=0.5):

super(DistillationLoss, self).__init__()

self.alpha = alpha

def forward(self, outputs, labels, teacher_outputs):

hard_loss = F.cross_entropy(outputs, labels) # 计算hard部分的损失

soft_loss = F.kl_div(F.log_softmax(outputs, dim=1), F.softmax(teacher_outputs, dim=1), reduction='batchmean') # 计算soft部分的损失

loss = self.alpha * hard_loss + (1 - self.alpha) * soft_loss # 组合hard和soft损失

return loss

```

上述代码中定义了一个用于知识蒸馏的损失函数类 `DistillationLoss`,其中 `alpha` 参数用于平衡hard loss和soft loss之间的权重。

## 2.3 知识蒸馏的关键技术点

### 2.3.1 温度调整与软化输出

在知识蒸馏中,软化输出通常与温度参数有关。温度参数调整了软标签输出的分布,通过提高温度,可以使软标签输出更加平滑,更加接近真实的数据分布。同时,温度调整也使得软标签更加具有信息量,帮助学生模型学习到更多的细节和特征。

### 2.3.2 任务特定的蒸馏策略

不同的任务需要特定的蒸馏策略,这些策略针对特定的任务领域来优化。例如,在图像识别任务中,可能需要关注不同区域的特征,而在自然语言处理任务中,则可能更关注上下文信息的保留。任务特定的蒸馏策略能够使得学生模型更好地适应于具体任务,达到更高的性能。

```mermaid

graph LR

A[开始] --> B[定义教师模型]

B --> C[定义学生模型]

C --> D[准备训练数据]

D --> E[设置蒸馏损失函数]

E --> F[训练学生模型]

F --> G[验证学生模型性能]

G --> H{是否满足性能标准}

H --> |是| I[结束]

H --> |否| E

```

以上mermaid图展示了知识蒸馏的基本流程,从定义模型开始,准备数据,设定损失函数,训练模型,并不断验证模型的性能,直到达到满意的性能标准。

通过这些理论基础与方法论的介绍,我们可以看到知识蒸馏技术的深度和复杂性,以及如何将其应用于不同的任务和场景中。在下一章节中,我们将深入了解知识蒸馏在不同实际应用中的具体实现和挑战。

# 3. 实践中的知识蒸馏应用

## 3.1 图像识别任务中的应用

在本章中,我们将深入了解知识蒸馏技术在图像识别任务中的实际应用。图像识别是深度学习中最为广泛研究的领域之一,从基本的图像分类到复杂的对象检测和图像分割,该技术都在发挥着重要的作用。

### 3.1.1 数据集准备与模型选择

在准备进行知识蒸馏之前,数据集的选择和预处理是至关重要的步骤。根据应用的具体需求,选择合适的数据集,并对其进行必要的清洗和标注。例如,如果我们在进行一个面部识别系统开发,那么就需要一个包含不同角度、表情和光照条件下人脸的高质量数据集。

在模型选择方面,通常会用到一个预训练的大型模型作为教师模型,比如在图像识别任务中,ResNet、Inception、VGG等预训练模型可以

0

0