编译原理全攻略:陈意云教授带你深入理解编译过程(14大核心概念深度剖析)

发布时间: 2024-12-29 08:24:16 阅读量: 29 订阅数: 15

编译原理-陈意云

# 摘要

编译原理是计算机科学中的核心领域之一,涉及到程序从源代码到机器可执行代码的转换过程。本文首先概述了编译原理的基本概念,并对词法分析、语法分析、语义分析、中间代码生成以及目标代码生成与优化这些关键阶段进行了详细阐述。词法分析部分探讨了分析器的角色、正则表达式和有限自动机的应用;语法分析部分分析了上下文无关文法、语法树的构建和解析算法;语义分析和中间代码生成章节讨论了符号表的管理、类型检查及中间表示的选择和转换;最后,在目标代码生成与优化部分,本文探讨了代码调度、寄存器分配和优化技术。本论文旨在为编译过程中的关键概念和实践提供清晰的指导,帮助读者深入理解编译器的内部工作原理及其优化策略。

# 关键字

编译原理;词法分析;语法分析;语义分析;中间代码生成;目标代码优化

参考资源链接:[编译原理(陈意云)课后答案](https://wenku.csdn.net/doc/6412b476be7fbd1778d3faa5?spm=1055.2635.3001.10343)

# 1. 编译原理概述

## 1.1 编译过程的基本概念

编译是一个将源代码转换成机器代码的复杂过程。在高层次上,编译器将源代码分解为更小的单元,经过分析和优化,最终生成目标程序。编译过程通常包括前端和后端两部分。前端负责解析源代码并生成中间表示(Intermediate Representation,IR),而后端则将IR转换为目标机器代码。

## 1.2 编译器的主要组成部分

一个典型的编译器包含以下主要部分:词法分析器(Lexer)、语法分析器(Parser)、语义分析器(Semantic Analyzer)、中间代码生成器(Intermediate Code Generator)、优化器(Optimizer)和目标代码生成器(Code Generator)。每个部分都承担着转换源代码到可执行程序的特定步骤。

## 1.3 编译原理研究的意义

深入理解编译原理对于提高程序执行效率、改善编程语言设计和实施高级优化具有重要意义。随着编程语言和硬件技术的发展,编译器不仅要处理多种语言的源代码,还需对多种硬件平台进行优化。掌握编译原理,可以帮助开发者构建性能更优、兼容性更强的应用程序。

# 2. 词法分析的理论与实践

## 2.1 词法分析器的角色和功能

### 2.1.1 词法分析器的定义和任务

词法分析器(Lexer或Scanner)是编译器的第一个阶段,它的主要职责是将源程序的字符序列转换为标记(Token)序列。这些标记是编译器可以理解的最小逻辑单元,比如标识符、常量、运算符等。词法分析器处理的主要任务包括:移除空白字符、注释、识别关键字、标识符和常量、判断运算符与分隔符等。

在技术层面,词法分析器经常使用正则表达式来匹配源代码中的模式,并将这些模式转换为标记。正则表达式是描述文本模式的一种方式,而有限自动机(Finite Automata,FA)是一种数学模型,用来描述词法分析器如何根据有限的规则识别输入字符串中的模式。

### 2.1.2 正则表达式和有限自动机

正则表达式是一种定义字符序列模式的方法,它可以用简洁的形式表示复杂和重复的字符串模式。例如,正则表达式`[0-9]+`可以匹配任意长度的数字序列。

有限自动机是一种抽象的计算模型,由一系列状态和转移函数组成。词法分析器使用的是确定性有限自动机(DFA)或非确定性有限自动机(NFA)。DFA对于每一个可能的输入字符和状态都只有一种可能的转移,而NFA则允许多种可能。

```mermaid

graph LR

A(开始) --> B{读取字符}

B -- 字符'0' --> C(状态1)

B -- 字符'1' --> D(状态2)

C -- 字符'0' --> C

C -- 字符'1' --> E(接受状态)

D -- 字符'0' --> F(接受状态)

D -- 字符'1' --> D

E -- 字符'0' or '1' --> E

F -- 字符'0' or '1' --> F

```

上图表示了一个简单的有限自动机,其中一些状态是用来接受特定模式的,如二进制数。

## 2.2 实现词法分析器的工具和方法

### 2.2.1 词法分析器生成器Lex的使用

Lex是一种常用的词法分析器生成器。它根据程序员定义的正则表达式规则来生成C语言编写的词法分析器。Lex的输入是一个规则集,每个规则定义了某种标记的模式,以及当该模式被匹配时应该执行的动作。使用Lex,程序员可以专注于正则表达式的定义,而不需要手动编写状态转换逻辑。

```

%{

#include <stdio.h>

%}

[0-9]+ { printf("NUMBER: %s\n", yytext); }

"+" { printf("PLUS\n"); }

"-" { printf("MINUS\n"); }

"*" { printf("MULT\n"); }

"/" { printf("DIV\n"); }

. { /* 忽略其他字符 */ }

int yywrap() { return 1; }

```

这段代码定义了一个简单的Lex词法分析器,它可以识别和打印数字和基本的运算符。

### 2.2.2 手写词法分析器的设计要点

尽管有生成器如Lex,某些情况下我们可能需要手动设计和实现词法分析器,尤其是在需要高度定制化或者优化时。手写词法分析器的设计要点包括:

- 明确标记的识别规则和语法。

- 实现高效的状态转换机制。

- 优化内存和性能开销,确保处理大文件时的效率。

- 引入错误处理机制,以便在遇到不符合任何规则的输入时给出明确的错误信息。

```c

struct Token {

TokenType type;

char* value;

};

void tokenize(char* input) {

// 伪代码表示的手写词法分析器核心逻辑

while (*input != '\0') {

if (isWhitespace(*input)) {

skipWhitespace(input);

continue;

} else if (isdigit(*input)) {

input = parseNumber(input);

} else if (isOperator(*input)) {

input = parseOperator(input);

}

// 其他逻辑...

}

}

```

这段伪代码展示了基本的手写词法分析器的结构,包括读取输入、跳过空白字符、解析数字和运算符等。

### 2.2.3 词法分析器的测试和验证

词法分析器的测试是确保它正确识别各种输入的过程。验证通常包括单元测试、集成测试和系统测试。单元测试关注于单个标记的识别,而集成测试可能会使用真实的源代码样本,来确保标记的识别逻辑在复杂场景下也有效。系统测试则会验证整个编译过程是否顺畅。

测试词法分析器的一个关键部分是处理边界情况和错误输入,确保分析器能够给出恰当的错误提示。

```c

void testTokenize() {

char* input = "123 + 456 - 789*2";

tokenize(input);

// 测试逻辑应验证输入是否被正确地分解为NUMBER, PLUS, NUMBER, MINUS, NUMBER, MULT, NUMBER

}

```

此测试函数仅作为示例,实际测试过程会更加复杂,需要验证各种可能的输入和预期的输出。

在下一章节中,我们将深入探讨语法分析的理论与实践,包括上下文无关文法和语法树的构建与应用,以及解析算法的选择和实现。

# 3. 语法分析的理论与实践

## 3.1 上下文无关文法和语法树

### 3.1.1 上下文无关文法的定义和性质

上下文无关文法(Context-Free Grammar,CFG)是一种用于描述语言形式结构的语法体系,其在编译原理中扮演着核心角色,特别是在语法分析阶段。CFG由一组产生式规则组成,每个产生式由一个非终结符和一个可替换的字符串组成,这个字符串由终结符(如关键字、标识符)和/或非终结符构成。

在CFG中,所有规则左边的非终结符都可以被任意终结符或非终结符字符串所替代,这种替换并不依赖于任何上下文环境。这种特性让CFG成为了构建语法树的理论基础,因为语法树是一种用树状结构来表示语言推导过程的方法,使得可以直观地表示出程序的语法结构。

CFG主要具备以下几个性质:

- 递归性:CFG支持递归规则,这允许语言包含嵌套结构,如括号表达式。

- 无歧义性:理论上,一个CFG可以被设计为无歧义,即每个句子有唯一的推导树。然而,在实践中构造无歧义的CFG可能会非常复杂。

- 多义性:存在这样的CFG,对于同一输入句子,可以构建多于一个的语法树,这被称为语言的多义性。编译器设计时需要通过一些技术来处理这种多义性。

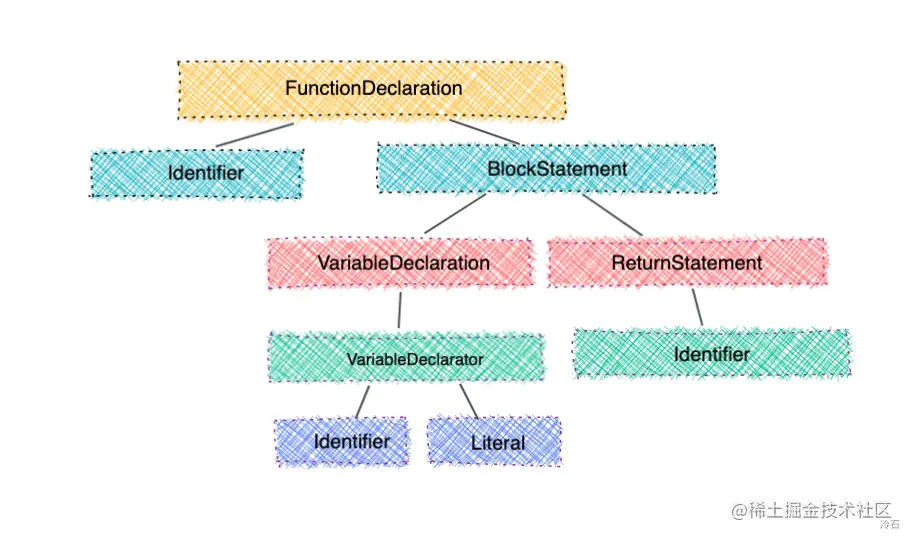

### 3.1.2 语法树的构建和应用

语法树(Parse Tree)是CFG的具体应用之一,它将源程序的符号串按照CFG的规则分解成树状结构,树的每个节点代表一个语法单位(如表达式、语句等),叶节点为终结符,内部节点为非终结符。语法树是理解程序语法结构的重要工具,它直观地反映了程序的层次和组合关系。

构建语法树通常有自顶向下和自底向上两种策略。在自顶向下方法中,从根节点(通常是程序的开始符号)开始,递归地将非终结符替换为对应的产生式,直至所有叶节点都是终结符。而在自底向上方法中,从输入的终结符号序列开始,逐步应用产生式规则,将终结符组合成更高层次的非终结符,直到构建出完整的树。

语法树在编译器中的应用非常广泛,它用于:

- 语法检查:通过检查语法树是否符合特定的规则来执行语句的正确性。

- 语义分析:基于语法树可以进行符号表的建立和类型检查等。

- 中间代码生成:语法树可以被转换成一种中间表示形式,以便进一步的优化和目标代码生成。

- 代码优化:通过分析语法树结构,进行一些结构上的优化,如公共子表达式的提取。

### 3.1.3 代码示例

下面是一个简单的自顶向下构建语法树的伪代码示例:

```pseudo

// 伪代码展示构建语法树过程

function buildParseTree(input):

grammar = {

'S': ['A', 'B'],

'A': ['a', 'A', 'b'],

'B': ['c']

}

return buildTree('S', input, grammar)

function buildTree(nonTerminal, input, grammar):

if nonTerminal == 'leaf':

return leafNode(input) // 创建叶节点

productions = grammar[nonTerminal]

for production in productions:

tree = new TreeNode(nonTerminal)

symbols = production.split()

for symbol in symbols:

if isNonTerminal(symbol):

subtree = buildTree(symbol, input, grammar)

tree.appendChild(subtree)

input = inputAfterSubtree(input, subtree)

else:

tree.appendChild(leafNode(symbol))

input = inputAfterSymbol(input, symbol)

if isValidTree(tree):

return tree

return null // 如果没有合适的产生式,则返回null

// 辅助函数

function isNonTerminal(symbol):

// 判断一个符号是否为非终结符

...

function leafNode(symbol):

// 创建一个叶节点

...

function inputAfterSubtree(input, subtree):

// 根据已构建的子树调整输入

...

function inputAfterSymbol(input, symbol):

// 根据已识别的符号调整输入

...

function isValidTree(tree):

// 检查构建的树是否有效

...

```

通过这个示例,我们可以看到,构建语法树的过程实际上是一个递归过程,它从一个非终结符开始,递归地使用产生式规则,直到叶节点都是终结符为止。这个过程在编译器设计中至关重要,因为只有正确地构建了语法树,才能进行后续的语义分析和中间代码生成等步骤。

## 3.2 解析算法的选择和实现

### 3.2.1 递归下降解析技术

递归下降解析是一种自顶向下的解析方法,它通过一组递归函数来实现,每个函数对应于文法中的一个非终结符。当一个非终结符需要被展开时,对应的递归函数会被调用,如果展开规则中包含终结符,解析器会检查当前输入并匹配该终结符。

递归下降解析器的编写通常较为简单,因为它直接反映了文法的结构。开发者可以直观地将产生式规则转化为编程语言中的函数调用。递归下降解析器适合手写,并且其结构清晰易于调试。不过,编写这种解析器需要对文法进行一些调整,比如消除左递归,以避免无限递归的情况发生。

尽管递归下降解析器易于实现和理解,但它们通常缺乏错误恢复的能力。因此,在实际应用中,开发者往往需要自己实现错误恢复策略。

### 3.2.2 LR分析算法和工具

与递归下降解析相对的是自底向上的解析方法,其中最著名的是LR分析算法。LR分析器从输入的终结符序列开始,逐步应用文法规则将输入序列归约为起始符号。LR分析器能够处理比递归下降更复杂的语法结构,包括有左递归的文法,并且具有良好的错误报告和恢复能力。

LR分析器的实现比递归下降解析器复杂,通常需要借助一些工具(如YACC,GNU bison等)来生成。这些工具根据文法输入生成状态机和解析表,然后在运行时使用这些表来指导解析过程。

LR分析器主要有两类:SLR(简单LR)、LR(1)和LALR(向前看LR)。其中,LALR是最常用的一种,因为它在SLR和LR(1)之间提供了一个良好的平衡,既能够处理相对复杂的语法,又不会有过高的状态数量。

### 3.2.3 解析器的错误处理机制

不管选择哪一种解析技术,错误处理机制都是编译器设计中的一个重要方面。良好的错误处理机制可以在发现错误时给出准确的错误信息,并尽可能地从错误中恢复,继续进行后续的解析工作。

递归下降解析器中的错误处理通常依赖于程序员自己实现的策略,比如:

- 当发现一个输入字符不符合任何期望时,可以跳过这个字符,直到遇到下一个可接受的字符。

- 当出现语法错误时,可以尝试丢弃一些符号,以回到一个已知的状态。

而在LR分析器中,错误恢复通常通过解析表中的错误项来实现。当解析器遇到无法处理的输入时,它可以查找解析表中的错误项,并根据表中的信息进行错误恢复。

### 3.2.4 代码示例:递归下降解析器

以下是一个简单的递归下降解析器的代码示例,用于解析简单的算术表达式:

```pseudo

// 递归下降解析器的伪代码示例

// 解析表达式的函数

function parseExpression():

parseSum()

if currentToken != EOF:

raise SyntaxError("Unexpected token after expression")

// 解析加法和减法的函数

function parseSum():

parseProduct()

while currentToken in ('+', '-'):

operator = currentToken

nextToken() // 移动到下一个输入符号

parseProduct()

if operator == '+':

// 构建加法语法树节点

else if operator == '-':

// 构建减法语法树节点

// 解析乘法和除法的函数

function parseProduct():

parseFactor()

while currentToken in ('*', '/'):

operator = currentToken

nextToken() // 移动到下一个输入符号

parseFactor()

if operator == '*':

// 构建乘法语法树节点

else if operator == '/':

// 构建除法语法树节点

// 解析单个因子的函数

function parseFactor():

if currentToken.isNumber():

// 处理数字因子,构建数字语法树节点

nextToken()

else if currentToken == '(':

nextToken() // 移动到下一个输入符号

parseExpression()

if currentToken == ')':

nextToken()

else:

raise SyntaxError("Mismatched parentheses")

else:

raise SyntaxError("Unexpected token")

// 辅助函数,用于获取下一个输入符号

function nextToken():

// 更新currentToken为下一个符号

...

// 主程序

function main():

initializeInput() // 初始化输入符号序列

nextToken() // 开始解析

try:

parseExpression()

if currentToken != EOF:

raise SyntaxError("Unexpected input at end of expression")

except SyntaxError as error:

print(error)

```

通过这个例子,我们可以看到递归下降解析器的实现非常直观,每个函数对应于文法中的一种产生式。当输入不匹配时,程序会抛出一个语法错误,这需要程序员自己实现错误处理逻辑。

### 3.2.5 代码示例:LR分析器生成

下面是使用YACC工具生成的LR分析器的伪代码片段:

```pseudo

// YACC代码片段,用于生成LR分析器

// 定义终结符和非终结符

%token NUMBER PLUS MINUS TIMES DIVIDE

%token LPAREN RPAREN

%type expr term

// 产生式规则

expr: term

| expr PLUS term { /* 构建加法语法树节点 */ }

| expr MINUS term { /* 构建减法语法树节点 */ }

;

term: NUMBER

| LPAREN expr RPAREN

;

// 自定义错误恢复函数

int yyerror(char* s) {

// 错误恢复逻辑

printf("%s\n", s);

return 0;

}

// 主程序

int main() {

// 初始化词法分析器和解析器

yyparse();

return 0;

}

```

在上述YACC伪代码中,我们定义了终结符和非终结符,写出了产生式规则,并通过特殊的注释指定了产生式规则的语义动作。这些动作在解析时执行,用于构建语法树。YACC根据这些输入生成一个完整的LR解析器。该解析器在发生错误时通过调用自定义的`yyerror`函数来报告和恢复错误。

通过这两段代码示例,我们展示了递归下降解析器和LR分析器的基本实现思路与方法。在实际的编译器开发中,这样的解析器需要针对具体的语言语法进行详细的定义和调整。

# 4. 语义分析和中间代码生成

## 4.1 语义分析的主要任务和方法

### 4.1.1 符号表的构建和管理

在编译器的语义分析阶段,符号表是核心数据结构之一,它负责存储程序中出现的所有标识符的相关信息,比如变量名、函数名、类型等。构建和管理符号表的过程涉及以下几个步骤:

- **声明信息收集**:编译器在词法分析阶段已经识别了所有的标识符,并在语法分析阶段确定了它们的结构关系。语义分析阶段,编译器需要为每个标识符建立一个条目,并收集它们的声明信息。

- **符号表结构设计**:设计合理的符号表结构是提高编译效率的关键。一般符号表采用哈希表或平衡树等数据结构实现,以加快查找、插入和删除操作的速度。

- **作用域规则实现**:编程语言通常支持局部作用域和全局作用域。语义分析器必须处理好标识符的作用域规则,以确保变量和函数名的唯一性。

- **类型管理**:编译器需要对各种数据类型进行管理和检查。在符号表中,每个标识符的类型信息是必不可少的,编译器将根据这些信息进行类型检查。

- **符号生命周期追踪**:编译器还需要追踪每个变量的生命周期,以正确地分配和释放内存资源。

下面是一个简单的符号表管理伪代码示例:

```python

class SymbolTable:

def __init__(self):

self.table = {} # 使用哈希表存储符号信息

self.scope = None # 当前作用域

def enter_scope(self):

# 进入新的作用域,创建一个新的符号表

new_scope = {}

self.table[self.scope] = new_scope

self.scope = new_scope

def exit_scope(self):

# 离开当前作用域,回到上一作用域

self.scope = list(self.table.keys())[list(self.table.values()).index(self.scope)]

def add_symbol(self, name, type):

# 在当前作用域添加一个符号

if name not in self.scope:

self.scope[name] = type

else:

raise Exception(f"Symbol {name} already exists in this scope.")

def lookup_symbol(self, name):

# 查找符号信息

scope = self.scope

while scope:

if name in scope:

return scope[name]

scope = self.table[list(self.table.keys())[list(self.table.values()).index(scope) - 1]]

raise Exception(f"Symbol {name} not found.")

```

### 4.1.2 类型检查和类型系统的角色

类型检查是编译器在语义分析阶段确保程序类型安全的重要过程。它涉及以下两个主要方面:

- **类型推断**:编译器尝试从上下文中推断变量和表达式的类型。类型推断可以是显式也可以是隐式的。隐式类型推断通常称为类型推导。

- **类型一致性检查**:对于程序中所有的赋值和运算操作,编译器需要确保操作数的类型兼容。比如在C语言中,不能将一个整型变量赋值给一个字符型变量。

类型系统为类型检查提供了理论基础,它规定了如何定义类型、类型之间的关系以及类型如何影响程序的运行。类型系统通常包括如下几个关键点:

- **类型安全**:类型安全的语言可以避免运行时的类型错误,如数组越界、空指针引用等。

- **类型推断**:一些高级语言如Haskell和ML支持类型推断,编译器能够在编译时自动推断出表达式的类型,从而减少程序员显式声明类型的需要。

- **泛型类型**:泛型提供了编写与类型无关的代码的能力,如C++中的模板或者Java中的泛型类。

- **多态性**:多态允许使用单个接口来表示不同的底层形式。在面向对象编程中,方法和对象可以根据其类型以不同的方式表现。

## 4.2 中间表示IR的选择和转换

### 4.2.1 三地址代码和静态单赋值形式

中间表示(Intermediate Representation,IR)是编译器在源代码和目标代码之间的中间步骤,它为代码优化和目标代码生成提供了便利。常见的IR有:

- **三地址代码(Three Address Code, TAC)**:一种类似于汇编语言的抽象层次更高的代码形式,每个语句最多涉及三个操作数,如 `a = b op c`。这种形式易于生成,也便于后续的优化。

- **静态单赋值形式(Static Single Assignment, SSA)**:在SSA形式中,每个变量仅被赋值一次。SSA形式有助于数据流分析,它是现代编译器优化技术中不可或缺的一部分。

### 4.2.2 代码优化的基础和策略

代码优化旨在改善生成的IR的性能,而不改变程序的正确性。它主要分为两类:

- **机器无关优化**:在不考虑具体机器特点的情况下进行的优化,比如公共子表达式的消除、常数传播等。

- **机器相关优化**:这类优化考虑了特定目标机器的特性,例如指令选择、寄存器分配等。

代码优化的一些常见策略包括:

- **循环优化**:包括循环不变代码外提、循环展开、强度削弱等。

- **死代码消除**:移除未被使用或对程序结果不影响的代码段。

- **常数传播**:通过将变量的值传播并计算出来,来替换变量和表达式。

- **函数内联**:将函数调用替换为函数体的副本,减少函数调用的开销。

- **尾调用优化**:通过特殊的处理机制减少递归调用的栈空间开销。

下面是一个简单的死代码消除的代码示例:

```c

void example_function() {

int a = 5;

int b = a + 10;

int c = 0; // 这行代码是死代码,因为它的结果从未被使用过

b = b + 20;

return;

}

```

经过死代码消除优化后,我们可以移除变量 `c` 的声明以及相关的计算,得到的优化代码如下:

```c

void example_function() {

int a = 5;

int b = a + 30;

return;

}

```

通过以上的优化,程序的运行时效率得到了提升,同时生成的机器代码可能也会更加简洁。

在编译器的各个阶段,语义分析和中间代码生成是承上启下的关键步骤。它们确保了代码的语义正确性和结构优化,为最终的目标代码生成奠定了坚实的基础。

# 5. 目标代码生成与优化

## 5.1 目标代码生成的策略和方法

目标代码生成是编译过程的最后阶段,它的任务是将中间代码转换为特定目标机器上的机器代码。这个转换过程必须高效,以便生成的机器代码性能最优,同时也是编译器设计中最富有挑战的部分之一。

### 5.1.1 代码调度和寄存器分配

代码调度是目标代码生成中的一个重要环节。它涉及重新排列指令的顺序来减少延迟,并提高资源的利用率。这通常是为了优化执行时间和吞吐量。寄存器分配是与代码调度紧密相关的任务,它确定哪些变量或中间结果应该存储在有限的寄存器中,以减少对慢速主存的访问。

示例代码块展示了在目标代码生成中如何实施简单的寄存器分配策略:

```c

// 示例伪代码,描述寄存器分配的基本思路

for (每个变量) {

if (寄存器空闲) {

分配寄存器;

} else {

保存寄存器内容至内存;

分配寄存器;

恢复寄存器内容;

}

}

```

### 5.1.2 指令选择和机器指令编码

指令选择是将抽象的中间代码指令转换为对应目标机器上的具体机器指令的过程。这个步骤必须考虑目标机器的指令集架构(ISA),并且通常涉及到一个优化选择,以减少生成代码的数量和提高执行效率。

下面是一个指令选择和编码的示例代码:

```c

// 示例伪代码,描述指令选择的基本思路

for (每个中间指令) {

if (ISA中有直接对应的机器指令) {

使用直接对应指令;

} else if (ISA中有可合成的指令组合) {

合成指令组合;

} else {

报告错误;

}

}

```

## 5.2 编译器后端的优化技术

编译器的后端优化包括循环优化、数据流分析、控制流分析等,它在目标代码生成之后进行,但对生成代码的质量有重要影响。

### 5.2.1 循环优化和公共子表达式消除

循环优化关注于提高循环的效率,例如通过减少循环内部的计算次数或消除冗余操作来达到目的。公共子表达式消除是识别并消除计算中重复的子表达式,以减少计算负担。

示例操作步骤来消除公共子表达式:

1. 对代码进行遍历,标记公共子表达式。

2. 替换已计算过的公共子表达式为临时变量。

3. 确保这些替换不会干扰原代码的正确性。

### 5.2.2 数据流分析和死代码删除

数据流分析是一种确定程序中变量值信息的技术,死代码删除利用这些信息来消除那些对程序执行结果没有影响的代码片段。

```c

// 伪代码,描述数据流分析和死代码删除的基本思路

for (每个基本块) {

计算到达定义集合;

标记死代码;

}

删除标记的死代码;

```

### 5.2.3 控制流分析和优化

控制流分析用于理解程序的执行路径,包括分支、循环等结构。通过控制流分析,编译器可以发现并优化那些能够提高执行效率的代码结构。

优化控制流的一个例子是消除冗余的跳转指令:

```c

// 伪代码,描述控制流优化的基本思路

for (每个基本块) {

if (存在冗余跳转) {

消除冗余跳转;

}

}

```

在整个编译器优化过程中,这些技术相互作用,相互依赖,通过精确的分析与深入的优化,最终生成高性能的机器代码。这为最终用户带来直接的性能提升,特别是在性能敏感型的应用上显得尤为重要。随着新的硬件架构的出现,编译器的优化技术也需要不断地演进,以适应新的挑战。

0

0