模型训练的幕后英雄

发布时间: 2024-12-11 16:24:59 阅读量: 2 订阅数: 14

毕业设计-线性规划模型Python代码.rar

# 1. 模型训练的理论基础

## 1.1 机器学习与模型训练

机器学习是一门人工智能的科学,通过让计算机从数据中学习,无需明确编程即可做出决策或预测。模型训练是机器学习的核心,它涉及使用算法来分析数据并从中学习规律或模式。在训练过程中,算法会根据输入的数据进行自我调整,以提升预测准确性。

## 1.2 模型训练的原理

模型训练分为监督学习和非监督学习两大类。在监督学习中,模型通过大量的输入输出对学习规律,如分类任务中的标签。非监督学习则处理未标记数据,试图发现隐藏的结构或分群。训练过程需要通过迭代地调整模型参数(即学习权重),最小化预测误差。

## 1.3 训练、验证与测试

模型训练完成之后,还需要通过验证和测试来确保模型的泛化能力。通常将数据分为训练集、验证集和测试集。模型在训练集上学习,在验证集上调整超参数,在测试集上评估性能,以确保模型不会过拟合或欠拟合。

```mermaid

graph LR

A[开始训练] --> B[模型在训练集上学习]

B --> C[模型在验证集上调整超参数]

C --> D{是否过拟合/欠拟合?}

D -- 是 --> E[调整模型或输入]

D -- 否 --> F[模型在测试集上评估性能]

E --> B

F --> G[模型部署]

```

通过上述流程,可以确保训练得到的模型具有良好的泛化能力,并能够在实际应用中发挥作用。

# 2. 数据预处理的艺术

在机器学习和数据科学项目中,数据预处理是一个不可或缺的步骤。它涉及数据清洗、特征工程、数据转换等一系列操作,确保输入模型的数据质量。良好的数据预处理工作不仅可以提升模型的性能,还能加快模型训练的速度,使模型更加稳定和可靠。

### 2.1 数据清洗

数据清洗主要集中在处理数据集中存在的问题,如缺失值、重复记录、异常值等,以便为后续的分析和建模准备出干净的数据集。

#### 2.1.1 缺失值处理

在真实世界的数据集中,缺失值是一个常见问题。缺失值处理方法包括删除含有缺失值的记录、填充缺失值或使用算法能够处理缺失值的模型。

##### 代码示例:使用均值填充缺失值

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 创建一个含有缺失值的DataFrame

df = pd.DataFrame([[1, 2], [np.nan, 3], [7, 6]])

# 使用均值填充缺失值

imputer = SimpleImputer(strategy='mean')

df_imputed = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)

print(df_imputed)

```

在上述代码中,`SimpleImputer` 类用于填充缺失值。`strategy='mean'` 参数指定了填充策略为列均值。

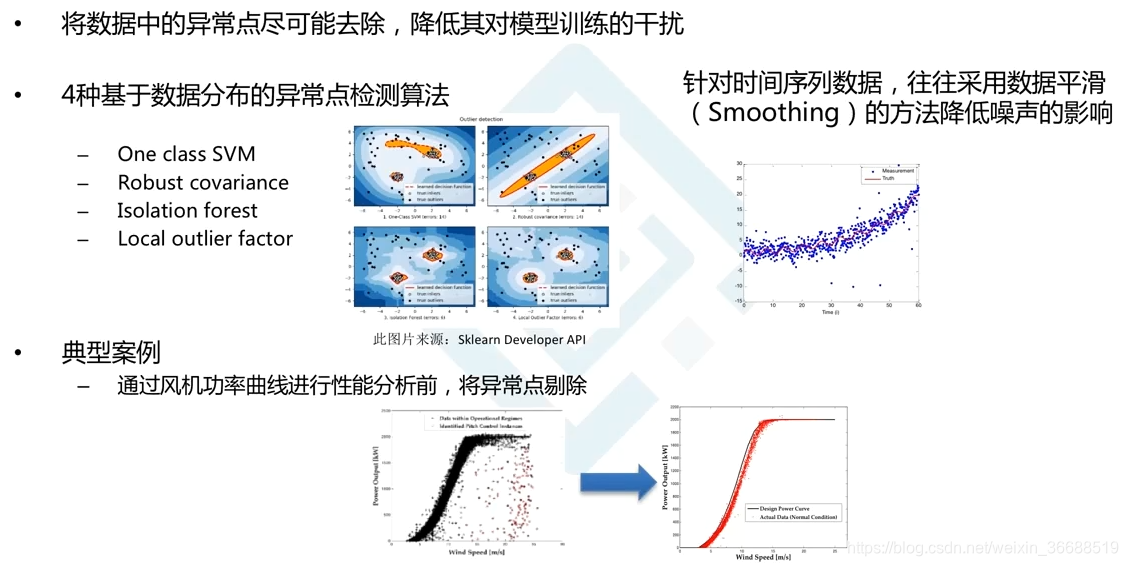

#### 2.1.2 异常值检测与处理

异常值是数据集中的值,它们与期望的值相差甚远或者与数据集中其他的值很不相同,可能是由错误或者罕见事件造成的。

##### Mermaid 流程图:异常值检测与处理流程

```mermaid

graph TD

A[开始异常值检测] --> B[统计分析]

B --> C[确定异常值范围]

C --> D[异常值标记]

D --> E[选择处理策略]

E --> F[处理异常值]

F --> G[结束处理]

```

### 2.2 特征工程

特征工程是数据预处理中创造性最强的环节,它涉及到从原始数据中构造新的特征以提升模型性能。

#### 2.2.1 特征选择的方法

特征选择旨在识别出对模型预测能力贡献最大的特征子集。这可以通过过滤方法、包装方法和嵌入方法来实现。

##### 表格:特征选择方法比较

| 方法分类 | 描述 | 优点 | 缺点 |

| --- | --- | --- | --- |

| 过滤方法 | 基于数据的统计测试 | 实施简单、速度较快 | 可能忽略特征间的依赖关系 |

| 包装方法 | 基于模型表现来选择特征 | 考虑特征间的交互 | 计算成本高、容易过拟合 |

| 嵌入方法 | 在模型训练过程中选择特征 | 结合前两种方法的优点 | 模型和特征选择过程需并行优化 |

#### 2.2.2 特征提取技术

特征提取技术能够将原始数据转换为较少数量的特征,便于模型训练。常见的方法包括主成分分析(PCA)、线性判别分析(LDA)等。

##### 代码示例:使用PCA进行特征提取

```python

from sklearn.decomposition import PCA

# 假设X_train为已经标准化的训练数据

pca = PCA(n_components=0.95) # 保留95%的方差

X_train_pca = pca.fit_transform(X_train)

```

在本段代码中,PCA用于特征提取,通过`n_components=0.95`参数保留了原始特征集95%的方差,而降维到更低的特征空间。

### 2.3 数据归一化与标准化

数据归一化和标准化是将数据调整为特定范围或分布的过程,这有助于改善模型的收敛速度和性能。

#### 2.3.1 归一化的概念与应用

归一化是指将数据缩放到[0, 1]区间的过程,通常用于需要对数据范围敏感的算法,例如神经网络。

##### 代码示例:数据归一化

```python

from sklearn.preprocessing import MinMaxScaler

# 假设x为待归一化的特征数据

scaler = MinMaxScaler()

x_normalized = scaler.fit_transform(x.reshape(-1, 1))

```

在这个例子中,`MinMaxScaler` 类将数据归一化到了[0, 1]的范围。

#### 2.3.2 标准化的意义与技巧

标准化是指将数据调整为具有0均值和单位方差的过程,这有助于加快大多数基于梯度优化的算法的收敛速度。

##### 代码示例:数据标准化

```python

from sklearn.preprocessing import StandardScaler

# 假设x为待标准化的数据

scaler = StandardScaler()

x_standardized = scaler.fit_transform(x.reshape(-1, 1))

```

使用`StandardScaler` 类可以实现数据的标准化处理,使得特征均值为0,标准差为1。这对于许多机器学习算法至关重要。

通过上述的各节内容,我们可以看到数据预处理不仅需要专业的知识,还需要对具体问题的深入理解。每一种方法的选取和应用都可能对最终的模型性能产生重大影响。在实际操作中,数据科学家往往需要反复尝试和验证,以确定最适合项目的预处理策略。

# 3. 模型训练的实践技巧

## 3.1 选择合适的模型

选择合适模型的过程是机器学习任务的核心。这一过程涉及到模型比较和超参数调优。了解不同模型的优劣和适用场景是获得高性能模型的起点。

### 3.1.1 模型比较与评估指标

在机器学习中,模型评估是为了衡量模型在未知数据上的表现。选择的评估指标要与业务目标紧密相关。对于分类问题,常用的评估指标包括准确率(Accuracy)、精确度(Precision)、召回率(Recall)和F1分数(F1 Score)。准确率衡量了正确分类的比例,但在数据不平衡的情况下,精确度和召回率能提供更为细致的性能评估。

准确率虽然直观,但可能由于样本分布不均导致误导。例如,如果数据集中的正类远多于负类,简单地预测所有样本为正类也可以获得很高的准确率。这时,F1分数,即精确度和召回率的调和平均,可以平衡这两者的关系,是模型选择中非常有用的指标。

### 3.1.2 超参数调优方法

超参数是模型训练前设定好的参数,它们不会在训练过程中自动优化。超参数的设置对模型性能影响显著。超参数调优的常见方法有:

- 网格搜索(Grid Search):遍历预定义的超参数组合,尝试找出性能最佳的模型。

- 随机搜索(Random Search):从指定分布中随机选择超参数组合进行尝试,可能在较短时间内找到较好的参数组合。

- 贝叶斯优化(Bayesian Optimization):通过构建概率模型来指导搜索过程,能有效利用先前评估的结果来减少搜索空间。

0

0