CR5000后端优化:提升处理速度与响应能力的实战策略

发布时间: 2024-12-19 10:36:16 阅读量: 13 订阅数: 11

基于智能温度监测系统设计.doc

# 摘要

本文针对CR5000后端性能优化提供了全面的概览和深入分析。首先,通过多种性能分析工具的选择与应用,识别后端服务的瓶颈,并收集关键性能数据。其次,优化实践聚焦于代码层面,包括代码重构、算法改进及数据库操作,以及并发处理和异步任务的设计。系统架构层面的调整,如服务拆分、负载均衡、缓存策略及CDN集成,进一步提升性能与高可用性。此外,后端服务的安全加固也是本文探讨的重点,涉及安全漏洞的识别与修复,安全监控与应急响应。最后,讨论了持续集成和自动化部署在现代后端开发中的重要性和实践,包括CI流程的构建、自动化测试以及自动化部署策略。整体而言,本文通过系统性的方法论,为后端性能优化提供了实用的策略和工具,以实现更高效、安全的后端服务。

# 关键字

性能优化;瓶颈分析;代码重构;并发处理;系统架构;安全加固;持续集成;自动化部署

参考资源链接:[CR5000手把手教程](https://wenku.csdn.net/doc/6412b740be7fbd1778d499fe?spm=1055.2635.3001.10343)

# 1. CR5000后端性能优化概览

在现代IT行业中,随着业务的不断扩展和用户需求的日益增长,CR5000后端服务面临着前所未有的性能挑战。优化工作不仅涉及软件层面的代码重构和资源管理,还包括系统架构的调整和安全加固等多个层面。本章将为读者提供CR5000后端性能优化的整体概览,分析性能优化的重要性和挑战,并概述接下来各章节将要深入讨论的内容。

性能优化是一项系统工程,它要求开发者不仅要有扎实的编程基础,还要有对系统整体架构的深入理解和优化的全局视角。我们将从性能分析与瓶颈定位开始,逐步深入到代码优化、系统架构调整、安全加固以及持续集成与自动化部署等关键环节。通过对这些关键因素的优化,可以显著提高CR5000后端服务的响应速度、稳定性和安全性,最终达到提升用户体验和业务效率的目标。

在进入下一章节之前,建议读者先了解性能优化的基本概念以及优化的目标和预期效果,这将有助于更好地理解后续各章节内容的实践意义和应用价值。接下来,我们将深入探讨如何选择合适的性能分析工具,并识别和定位后端服务中的性能瓶颈。

# 2. 性能分析与瓶颈定位

性能分析是优化后端服务的首要步骤,通过使用恰当的工具和方法论,可以识别出影响性能的瓶颈,从而有针对性地进行优化。性能分析的精准度直接影响了优化措施的效率和效果。本章节将详细探讨性能分析工具的选择与应用,后端服务的瓶颈识别方法,以及性能数据的收集与管理。

## 2.1 性能分析工具的选择与应用

性能分析工具可以帮助开发人员和运维人员监控系统状态,及时发现性能瓶颈,从而快速定位问题所在。

### 2.1.1 CPU和内存分析工具

对CPU和内存的分析是性能分析的起点。以下是一些常用的性能分析工具,它们在监测CPU和内存使用情况方面非常有用。

- **htop**

htop是一个增强版的top工具,提供了更友好的交互界面,实时显示系统中的进程和资源使用情况。使用htop可以直观地看到各个进程的CPU和内存使用情况,并通过上下文菜单进行进程管理。

```bash

htop

```

- **Valgrind**

Valgrind是一个主要用于检测内存泄漏的工具。它模拟了一个CPU,并在运行程序的同时监视对内存的访问。该工具尤其适用于在开发阶段捕捉难以发现的内存问题。

```bash

valgrind --leak-check=full ./your_program

```

### 2.1.2 网络I/O分析工具

网络I/O分析对于理解后端服务与外部通信的效率至关重要。以下是一些网络I/O分析工具:

- **Wireshark**

Wireshark是一个网络协议分析器,用于捕获和交互式地浏览网络上正在传输的数据。它能帮助开发者理解网络通信过程中的细节,包括请求响应时间、数据包大小等关键性能指标。

### 2.1.3 数据库性能分析工具

数据库性能分析对于识别数据库操作是否为性能瓶颈至关重要。以下是一些数据库性能分析工具:

- **MySQL Workbench**

MySQL Workbench是一个图形化的界面工具,可以对MySQL数据库进行性能分析。通过它,可以监控查询性能,分析执行计划等。

```sql

EXPLAIN SELECT * FROM your_table;

```

- **Percona Toolkit**

Percona Toolkit是一组用于MySQL的高级命令行工具集合,用于监控、修复和优化数据库性能。它的工具包括`pt-query-digest`用于分析慢查询日志。

```bash

pt-query-digest /var/lib/mysql/mysql-slow.log

```

## 2.2 后端服务的瓶颈识别

瓶颈识别是性能分析中较为复杂的一个环节,需要结合多种方法和工具来实施。

### 2.2.1 瓶颈现象与日志分析

在应用运行过程中,特定的性能瓶颈会通过日志体现出来。例如,慢查询日志、应用程序日志、系统日志等都能提供性能问题的线索。

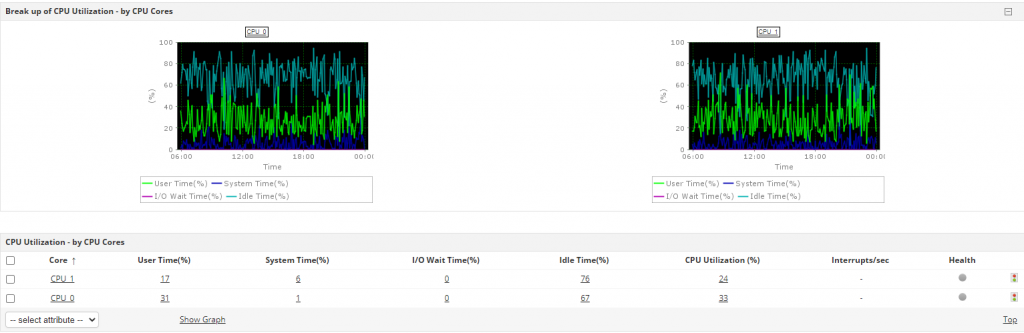

### 2.2.2 资源消耗与利用率监控

资源消耗监控主要关注系统的CPU、内存、磁盘I/O和网络I/O等资源的使用情况。一个有效的监控系统可以展示资源的实时使用情况,并设置阈值报警。

### 2.2.3 用户请求性能分析

用户请求性能分析通常依赖于APM(应用性能管理)工具来完成。APM工具能够跟踪用户请求在应用各个层面的处理时间,帮助开发者了解请求的生命周期。

## 2.3 性能数据的收集与管理

性能数据的收集与管理是性能优化过程中的重要组成部分,是后续优化决策制定的基础。

### 2.3.1 实时监控与告警系统

实时监控系统可以持续跟踪关键性能指标,并且在性能达到预设的阈值时及时通知相关人员。例如,Prometheus结合Grafana就可以实现高效的性能监控与告警。

### 2.3.2 性能数据存储与历史趋势分析

性能数据需要被存储在一种高效的存储系统中,以便于进行历史趋势分析。时间序列数据库如InfluxDB非常适合于存储性能数据,因为它们能够处理大量的时间点数据并支持复杂的查询。

### 2.3.3 数据驱动的性能决策制定

数据驱动的决策制定是性能优化的科学方法。通过收集性能数据,可以使用统计和机器学习方法分析性能趋势,并据此作出合理的优化决策。

```mermaid

graph LR

A[开始性能分析] --> B[选择性能分析工具]

B --> C[监控资源消耗]

C --> D[瓶颈识别]

D --> E[收集性能数据]

E --> F[存储与趋势分析]

F --> G[数据驱动的优化决策]

```

性能分析与瓶颈定位是后端性能优化的基础,通过选择合适的工具和方法进行细致的监控和分析,能够帮助我们在优化的道路上迈出坚实的第一步。

# 3. 代码层面的优化实践

代码层面的优化是性能提升过程中非常重要的一环,它直接影响到程序的运行效率和资源使用。通过合理的代码重构、数据库操作优化以及引入并发处理机制,可以显著提高后端服务的响应速度和处理能力。本章将深入探讨这些方面的优化策略和实践案例。

## 3.1 代码重构与算法改进

### 3.1.1 识别低效代码与重构策略

在软件开发中,低效代码往往是性能问题的源头。识别低效代码需要开发者具备敏锐的洞察力和对代码逻辑的深刻理解。常见的低效代码包括过度的资源占用、不必要的计算、以及低效的循环和条件判断等。

重构是一种提升代码质量和性能的过程,它不改变程序的外部行为,只改善其内部结构。有效的重构策略通常包括:

- **移除冗余代码**:删除重复的代码块,减少计算和维护成本。

- **分解复杂函数**:将长函数拆分成小的、易于理解的函数,提高代码的可读性。

- **提取重复逻辑**:将重复的逻辑抽象为通用函数或类,以便复用和维护。

### 3.1.2 算法复杂度分析与优化

算法是程序的核心,其复杂度直接影响到程序的运行时间。算法优化的核心是减少时间复杂度和空间复杂度。

以排序算法为例,如果原始实现使用了冒泡排序(时间复杂度为O(n^2)),通过替换为快速排序(平均时间复杂度为O(n log n))可以显著减少运行时间。

### 3.1.3 利用数据结构优化存储与检索

选择合适的数据结构可以极大提升存储和检索效率。例如,使用哈希表可以将查找时间从线性时间降低到常数时间。而红黑树等平衡二叉搜索树结构,在处理有序数据时具有优秀的搜索和插入性能。

在实际开发中,应根据需求选择合适的数据结构。例如,在处理大量日志文件时,使用Trie树可以快速检索和统计特定模式的日志。

```python

class TrieNode:

def __init__(self):

self.children = {}

self.is_end_of_word = False

class Trie:

def __init__(self):

self.root = TrieNode()

```

0

0