Python库文件学习之registration.models部署指南:模型部署到生产环境的步骤

发布时间: 2024-10-17 06:38:45 阅读量: 20 订阅数: 20

ONNXRuntime部署PaddleOCR-v3包含C++和Python源码+模型+说明.zip

# 1. registration.models库概述

在现代软件开发中,`registration.models`库是一个关键组件,它为用户提供了强大的数据模型管理和操作功能。这个库不仅仅是一个简单的数据封装工具,它还提供了丰富的接口来处理模型的生命周期,包括数据的创建、查询、更新和删除(CRUD)操作。通过深入分析`registration.models`的内部工作机制,我们可以更好地理解如何有效地利用这个库来提高应用程序的性能和可维护性。

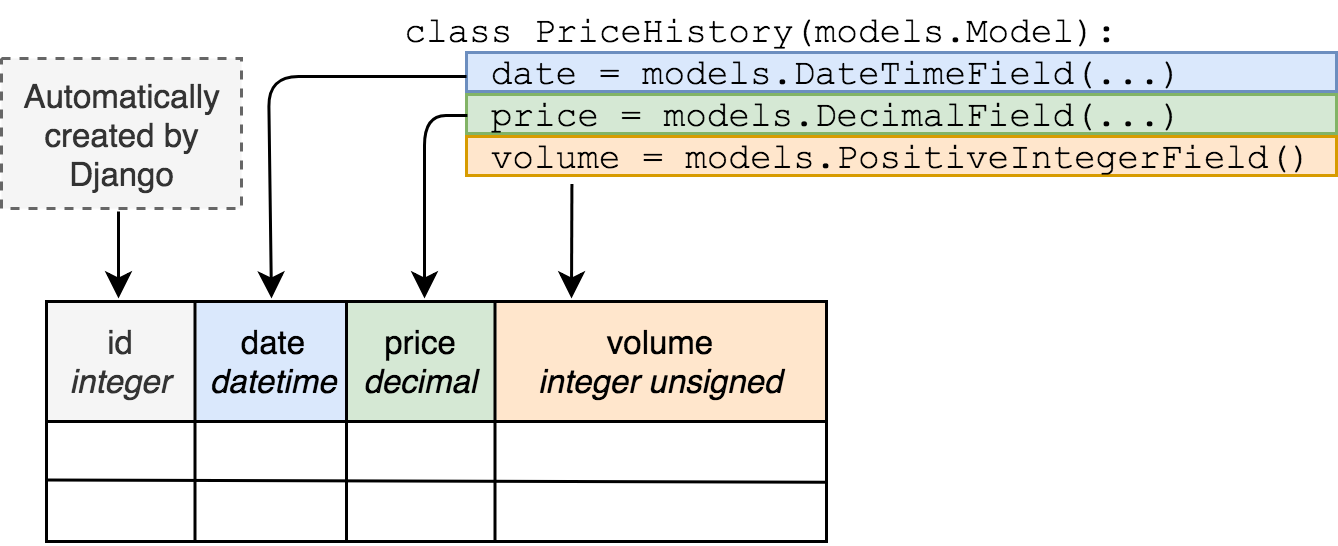

## 模型定义和字段类型

`registration.models`库的核心是模型的定义,它允许开发者定义数据表的结构,以及每个字段的数据类型和属性。例如,一个简单的用户模型可以定义如下:

```python

from registration.models import Model

class User(Model):

username = CharField(max_length=255)

email = EmailField(max_length=255)

password = CharField(max_length=255)

```

在这个例子中,`CharField`和`EmailField`是`registration.models`提供的两种字段类型,分别用于处理文本和电子邮件数据。通过定义这些字段,我们可以轻松地创建数据库表,并且库会自动提供相应的表单处理逻辑和数据库操作方法。

## 数据库迁移和ORM优势

使用`registration.models`的另一个好处是数据库迁移机制。开发者可以使用库提供的迁移工具来跟踪模型的变更,并且将这些变更应用到数据库中,而无需直接操作SQL语句。这种方式不仅提高了开发效率,还确保了数据库操作的一致性和安全性。

此外,`registration.models`的ORM(对象关系映射)功能允许开发者以面向对象的方式操作数据库,这大大简化了数据库的交互操作,并且使得代码更加清晰和易于维护。

在接下来的章节中,我们将深入探讨模型部署的理论基础,包括从开发到生产的转变、模型部署的目标和挑战,以及如何进行模型选择和优化。这些知识将为我们提供一个坚实的理论基础,以便我们能够更好地理解和实践模型部署的最佳实践。

# 2. 模型部署的理论基础

模型部署是机器学习生命周期中的一个重要环节,它涉及到将训练好的模型应用到实际生产环境中,以便为最终用户提供价值。在这一章节中,我们将深入探讨模型部署的必要性、基本流程以及技术选型等方面的内容。

## 2.1 模型部署的必要性

### 2.1.1 从开发到生产的转变

在模型开发阶段,数据科学家和机器学习工程师主要关注于模型的准确性、可解释性和效率。他们使用各种技术手段,如数据清洗、特征工程、模型选择和超参数调优等,来提升模型性能。然而,当模型从开发阶段过渡到生产环境时,关注点发生了显著的变化。

生产环境要求模型不仅要准确,还要稳定、可靠,并且能够高效地处理大量实时数据。此外,还需要考虑模型的可维护性、可扩展性和安全性等因素。因此,模型部署不仅仅是技术上的转变,更是从理论研究到实际应用的质的飞跃。

### 2.1.2 模型部署的目标和挑战

模型部署的目标可以概括为以下几点:

- **性能保障**:确保模型在生产环境中的预测速度和准确性符合预期。

- **可扩展性**:模型能够处理不断增长的数据量,并且可以水平或垂直扩展以适应更多的用户。

- **可维护性**:模型易于更新和维护,以适应数据分布的变化或业务需求的变化。

- **安全性**:保护模型不受恶意攻击,并确保用户数据的隐私和安全。

然而,在实现这些目标的过程中,我们面临着一系列挑战:

- **资源限制**:生产环境中的资源可能有限,需要在资源消耗和模型性能之间找到平衡。

- **数据一致性**:生产环境中的数据可能与训练数据不一致,需要处理数据漂移问题。

- **模型泛化能力**:模型在新数据上的表现可能不如在训练集上,需要评估和提高模型的泛化能力。

## 2.2 模型部署的基本流程

### 2.2.1 模型选择和优化

选择合适的模型对于成功的模型部署至关重要。通常,模型的选择基于多种因素,包括数据特性、任务需求、性能指标和资源限制等。在模型优化方面,我们可以采取以下策略:

- **模型简化**:使用更简单的模型结构或减少模型参数数量,以减少资源消耗和提高预测速度。

- **模型量化**:将模型参数从浮点数转换为整数,以减少模型大小和提高推理速度。

- **知识蒸馏**:通过训练一个轻量级的模型(学生模型)来模仿一个复杂模型(教师模型)的行为,以实现轻量化。

### 2.2.2 环境搭建和依赖管理

为了确保模型在生产环境中稳定运行,需要搭建一个合适的运行环境,并管理好模型的依赖项。以下是环境搭建和依赖管理的一些关键步骤:

- **容器化**:使用Docker等容器技术将模型及其依赖打包,确保模型在不同环境中的一致性和可移植性。

- **依赖管理**:使用pip、conda等工具管理模型的Python依赖,确保依赖版本的一致性和兼容性。

- **环境隔离**:使用虚拟环境或容器化技术隔离模型的运行环境,避免不同项目之间的依赖冲突。

### 2.2.3 模型持久化和版本控制

模型持久化是指将训练好的模型保存到磁盘或数据库中,以便在生产环境中使用。版本控制则是管理模型版本的重要手段,它可以帮助我们跟踪模型的迭代历史,并在出现问题时快速回滚。

- **模型持久化**:使用模型序列化技术(如pickle、joblib、ONNX等)保存模型的结构和参数。

- **版本控制**:使用Git等版本控制系统管理模型代码和配置文件,记录每次迭代的详细信息。

## 2.3 模型部署的技术选型

### 2.3.1 服务器和云服务提供商选择

在选择服务器或云服务提供商时,需要考虑以下因素:

- **性能需求**:根据模型的预测性能要求选择合适的硬件配置。

- **成本效益**:评估不同服务提供商的成本和性能,选择性价比最高的方案。

- **可扩展性**:考虑云服务提供商提供的可扩展性选项,以便应对业务增长。

### 2.3.2 容器化技术的应用

容器化技术,如Docker,可以将模型及其依赖打包成一个轻量级、可移植的容器,从而简化部署和运行流程。

- **容器镜像**:创建一个包含模型和所有依赖的Docker镜像,确保在任何环境中的运行一致性。

- **容器编排**:使用Kubernetes等容器编排工具管理容器的部署、扩展和维护。

### 2.3.3 自动化部署工具的使用

自动化部署工具可以简化部署流程,提高部署效率和可靠性。

- **CI/CD流程**:使用Jenkins、GitLab CI等工具实现持续集成和持续部署(CI/CD),自动化代码的编译、测试和部署过程。

- **部署脚本**:编写自动化部署脚本,使用Ansible、Chef等自动化配置管理工具自动化服务器配置和应用部署。

通过本章节的介绍,我们了解了模型部署的理论基础,包括模型部署的必要性、基本流程和技术选型等方面的内容。在下一章节中,我们将具体实践如何使用`registration.models`库进行模型的部署,并分享部署过程中的经验和常见问题的解决方案。

# 3. registration.models模型的实践部署

## 3.1 模型准备和优化

### 3.1.1 模型转换和压缩技术

在本章节中,我们将深入探讨如何将训练好的模型转换为适合生产环境的格式,并采用模型压缩技术来减小模型尺寸,提高部署效率。

首先,模型转换是将训练好的模型转换为部署平台所支持的格式的过程。例如,将TensorFlow训练的模型转换为ONNX格式,以便在多种平台上部署。这一步骤对于确保模型在不同环境下的兼容性和

0

0