Geolog 6.7.1数据处理流程大揭秘:掌握常规到复杂的每一步

发布时间: 2024-12-23 16:39:20 阅读量: 5 订阅数: 7

趋势面法测井曲线标准化的数据处理技巧.pdf

# 摘要

本文综合介绍了Geolog 6.7.1版本的核心功能和在数据处理中的应用。首先概述了Geolog的基本概念、新特性及其在数据处理中的作用。随后,深入探讨了基础数据处理的各个方面,包括数据导入、预处理、格式转换、校验与质控。在高级数据处理技巧章节,分析了复杂数据处理策略、数据分析与统计方法以及流程自动化的重要性。文章还详细阐述了数据可视化技术、地质数据解释方法和地质模型构建的先进应用。最后,通过多个实践案例展示了Geolog的实际应用情况,并提供了宝贵的数据处理和项目应用策略。本文旨在为地质数据处理人员提供一份详尽的Geolog操作指南,以提高数据处理效率和精确性。

# 关键字

Geolog;数据处理;数据可视化;地质模型;自动化流程;案例分析

参考资源链接:[Paradigm Geolog6.7.1 初级教程:入门指南](https://wenku.csdn.net/doc/2yv11n5qem?spm=1055.2635.3001.10343)

# 1. Geolog 6.7.1概述

在本章中,我们将对 Geolog 6.7.1 这一强大的数据处理软件进行全面介绍。从它的基本概念和功能,到它在行业中的作用,我们将详细探讨。

## 1.1 Geolog简介

Geolog 是由法国石油研究院(IFP)开发的一款专业的地质数据处理软件,广泛应用于石油和天然气行业。它提供的多功能模块能够满足地质数据处理的各个阶段的需求,从数据输入到最终的解释分析,Geolog都提供了强大的工具和方法。

## 1.2 Geolog 6.7.1新特性

在Geolog 6.7.1版本中,开发者增加了许多新的功能和改进,包括但不限于更高效的批量处理能力,更精准的数据分析算法,以及更灵活的用户界面。这些改进使得Geolog 6.7.1 在处理复杂数据方面更具优势。

## 1.3 Geolog在数据处理中的作用

Geolog在数据处理中的作用是不可或缺的。它不仅能处理大量数据,而且能提供精确的数据分析结果,这对于石油和天然气勘探具有重要的意义。通过Geolog,地质学家能够更深入地理解地下结构,从而做出更精确的预测。

# 2. Geolog基础数据处理

## 2.1 数据导入和预处理

### 2.1.1 数据导入技巧

在Geolog 6.7.1中,数据导入是一项基础且关键的操作。正确导入数据能够为后续的数据处理奠定坚实的基础。在这一部分,我们将讨论一些高效导入数据的技巧。

首先,了解数据源的结构是至关重要的。不同的数据源可能有着不同的数据格式,例如:*.log文件、*.txt文本文件等。Geolog提供了广泛的数据导入模板,适用于各种行业标准,确保了数据的快速准确导入。

其次,使用Geolog内置的导入向导进行数据导入时,应按照以下步骤操作:

1. 打开Geolog软件,进入数据导入模块。

2. 选择数据源类型,例如:井下测井数据。

3. 选择模板:依据数据源和所需处理的数据类型,选择合适的模板进行数据导入。

4. 设置参数:这里包括源文件路径、数据过滤条件等。

5. 检查预览:在导入前检查数据预览,确保数据正确读取。

6. 导入数据:确认无误后执行数据导入。

最后,对于一些具有特殊格式的数据,可能需要自定义导入模板。这通常涉及到使用Geolog的高级脚本语言,如Loglan,编写自定义的导入脚本。这种情况下,详细记录数据字段和格式显得尤其重要。

```loglan

# 示例:自定义导入脚本

LOGLAN

INPLOT

.multiinput

.multitrack

.text "Wellname: " WEL

.text "Date: " DATE

ENDINPLOT

DATA

.log

"mydata.log"

ENDDATA

```

该脚本示例展示了如何导入一个名为`mydata.log`的自定义日志文件。通过这种方式,我们可以处理那些标准模板不支持的复杂数据文件。

### 2.1.2 缺失值处理和数据清洗

数据导入之后,常常需要进行数据清洗,以处理数据集中的缺失值和异常值。在这一部分,我们将讨论处理缺失值的方法。

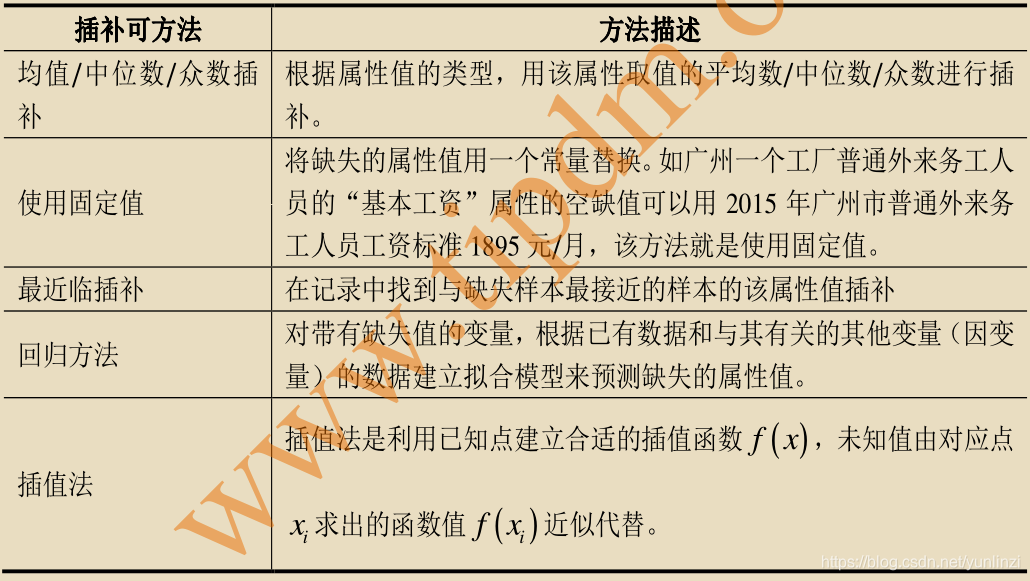

缺失值的处理通常有以下几种方法:

1. 删除含有缺失值的记录:这种方法适用于缺失数据比例较低且数据集较大时,能够快速减少数据量。

2. 缺失值填充:使用统计方法,如平均值、中位数、众数等,填充缺失值。

以Loglan脚本为例,下面展示如何用平均值填充某一列的缺失值:

```loglan

# 使用平均值填充缺失值

COLDEF

.name "Pressure"

.average

.fill

ENDCOLDEF

```

此外,异常值的处理也是数据清洗的一部分。异常值的定义是那些与大部分数据明显不同的数值。处理异常值可以使用的方法包括:

1. 删除:直接删除异常值,特别是当确定这些值是由于输入错误引起时。

2. 转换:通过数学转换,如取对数、平方等手段,使异常值看起来与其它数据更相似。

3. 替换:用一些统计指标(如均值、中位数)替换异常值。

```loglan

# 用均值替换特定列的异常值

COLDEF

.name "Porosity"

.clip .mean

ENDCOLDEF

```

在处理缺失值和异常值时,重要的是对数据集的背景和数据的采集过程有深入的理解,从而做出最合适的处理决策。

## 2.2 数据格式转换和规范

### 2.2.1 标准化数据格式

在实际应用中,不同来源和时期的数据往往采用不同的格式,这可能给数据整合和后续分析带来困难。因此,标准化数据格式是数据处理的重要一步。

标准化数据格式可以确保数据的一致性,便于在不同的工作流程中使用。例如,时间戳、深度测量单位和数据精度等都需要被统一。在Geolog中,标准化数据可以通过数据校准和转换功能实现。

使用Geolog 6.7.1进行数据格式转换时,可以按照以下步骤进行:

1. 选择需要转换的列或数据段。

2. 设置目标格式的参数。例如,时间格式转换为ISO标准,深度数据转换为米(m)。

3. 应用转换并验证结果。

下面是一个简单的转换示例:

```loglan

# 将深度数据从英尺转换为米

CONVERT

.units DEPTH

.from "feet"

.to "meters"

ENDCONVERT

```

以上代码块将数据中的深度单位从英尺转换为米,确保数据格式一致且适用于国际标准。

### 2.2.2 规范化流程设计

规范化流程设计不仅仅局限于数据格式的统一,还包括数据处理的标准化步骤,确保分析的可重复性和准确性。

规范化流程设计应遵循以下原则:

1. 确定数据处理步骤的标准操作程序(SOP),确保每一步骤都清晰定义且一致。

2. 使用自动化工具和脚本记录每一个操作,便于跟踪和审计。

3. 确保流程的灵活性,能够适应不同数据集和项目的需求。

在Geolog中,可以利用内置的自动化工具和宏来设计规范化的流程。创建宏(Macros)可以将一系列复杂的操作序列化,简化重复性工作流程。

```loglan

# 创建宏来标准化处理流程

MACRO

.name "StandardLoggingWorkflow"

.execute "ImportTemplate" "StandardTemplate"

.execute "DataCleaning" "StandardCleaningMethod"

.execute "DataExport" "StandardExportFormat"

ENDMACRO

```

上述宏定义了一个标准的测井工作流程,包括导入标准模板、数据清洗方法和标准输出格式。

## 2.3 基础数据校验与质控

### 2.3.1 校验规则的设定

数据校验是确保数据质量的不可或缺的步骤。在基础数据处理阶段,建立数据校验规则能够有效捕捉和纠正数据错误。

通常情况下,校验规则会根据数据的特性以及业务需求来设定,包括但不限于:

1. 值范围校验:确保数据值在预期的范围内。

2. 一致性校验:比对数据间的一致性,如井口坐标和井底坐标是否合理。

3. 唯一性校验:检查是否有重复记录或数据项。

在Geolog中可以使用内置的校验工具或编写Loglan脚本来设定校验规则。

```loglan

# 设定数据值范围校验规则

VALIDATE

.column "Depth"

.min "100m"

.max "5000m"

ENDVALIDATE

```

该脚本设定了一条校验规则,限制了"Depth"列中的所有值必须在100到5000米之间。

### 2.3.2 数据质量控制方法

数据质量控制不仅仅包括校验规则的设定,还涉及到一系列的步骤和方法。下面是一些常用的数据质量控制方法:

1. 实时监控:在数据导入和处理的过程中,实时监控数据流以快速发现异常情况。

2. 批量检查:对大规模数据集进行定期检查,确保数据满足质量标准。

3. 样本测试:通过随机抽样或关键数据抽样对数据集进行测试,以评估数据整体质量。

在Geolog中,可以通过Loglan脚本实现数据质量的批量检查和样本测试。

```loglan

# 执行数据质量批量检查

CHECK

.for "Pressure"

.with "QualityControlMethod"

ENDCHECK

```

该脚本将使用"QualityControlMethod"方法对"Pressure"列的数据质量进行批量检查。

数据质量控制是贯穿整个数据处理流程的重要环节,需要不断地评估和优化以保证数

0

0