yolo数据集构建秘籍:打造高质量数据集的终极指南

发布时间: 2024-08-16 07:14:20 阅读量: 49 订阅数: 22

河道漂浮物检测数据集:用于YOLO模型训练的高质量数据集

# 1. yolo数据集构建概述

### 1.1 YOLO数据集简介

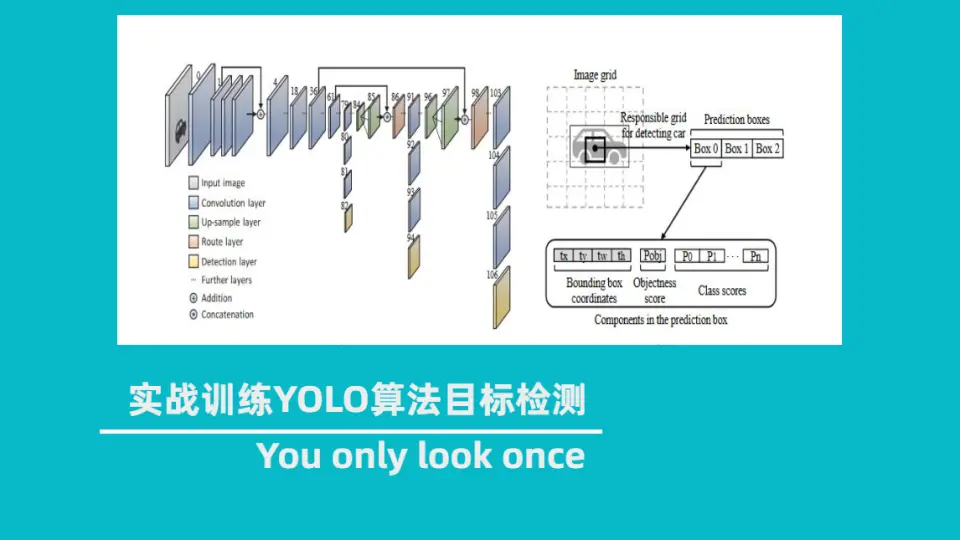

YOLO(You Only Look Once)是一种实时目标检测算法,它需要大量高质量的数据集进行训练。数据集的质量直接影响模型的性能,因此构建高质量的YOLO数据集至关重要。

### 1.2 YOLO数据集构建流程

YOLO数据集构建是一个多步骤的过程,包括:

- 数据采集:收集与目标检测任务相关的图像和标签。

- 数据标注:为图像中的目标绘制边界框并分配标签。

- 数据预处理:调整图像大小、转换格式并增强数据。

- 数据增强:通过旋转、裁剪和翻转等技术增加数据集的多样性。

# 2. yolo数据集构建理论基础**

## 2.1 数据集质量评估指标

数据集质量是衡量数据集好坏的重要标准,直接影响模型的训练效果。常用的数据集质量评估指标包括:

**1. 数据量:**数据集中的样本数量,样本数量越多,模型训练时可获取的信息越多,模型泛化能力更强。

**2. 数据多样性:**数据集包含不同类型、不同场景、不同角度的样本,数据多样性越高,模型对不同情况的适应能力越强。

**3. 数据准确性:**数据集中的样本标注是否准确,标注错误会误导模型训练,导致模型性能下降。

**4. 数据一致性:**数据集中的样本标注是否遵循统一的标准,标注不一致会影响模型的训练效果。

**5. 数据分布:**数据集中的样本分布是否均衡,样本分布不均衡会导致模型对某些类别预测不准确。

## 2.2 数据集构建方法论

数据集构建是一项复杂且耗时的任务,需要遵循科学的方法论,包括:

**1. 确定数据集目标:**明确数据集的用途和目标,例如目标检测、图像分类或语义分割。

**2. 数据采集:**根据数据集目标,从各种来源(如网络、摄像头、传感器)采集数据。

**3. 数据标注:**对采集到的数据进行标注,包括目标框标注、语义分割标注或其他形式的标注。

**4. 数据预处理:**对标注后的数据进行预处理,包括图像缩放、裁剪、归一化等操作。

**5. 数据增强:**对预处理后的数据进行增强,包括旋转、翻转、裁剪、添加噪声等操作,以增加数据集多样性。

**6. 数据验证:**对增强后的数据进行验证,确保数据质量符合要求。

**7. 数据集管理:**对构建好的数据集进行管理,包括存储、备份、版本控制等。

# 3. yolo数据集构建实践操作

### 3.1 数据采集和标注

**3.1.1 数据采集策略**

数据采集是数据集构建的关键环节,直接影响数据集的质量和适用性。在进行数据采集时,需要遵循以下策略:

- **明确数据采集目标:**明确数据集的用途和目标应用场景,确定所需数据的类型和数量。

- **选择合适的数据源:**根据数据集目标,选择可靠且相关的数据源,如公开数据集、网络爬虫或内部数据。

- **制定数据采集计划:**制定详细的数据采集计划,包括采集方式、采集时间和数据存储策略。

- **确保数据多样性:**收集具有不同场景、视角和光照条件的数据,以增强数据集的鲁棒性。

**3.1.2 数据标注工具和方法**

数据标注是将原始数据转换为训练模型所需格式的过程。常用的数据标注工具和方法包括:

- **LabelImg:**一款开源的图像标注工具,支持矩形、多边形和关键点标注。

- **VGG Image Annotator:**一款在线图像标注工具,提供丰富的标注功能和协作支持。

- **COCO Annotator:**一款用于COCO数据集标注的专用工具,支持多目标、多类别标注。

### 3.2 数据预处理和增强

**3.2.1 数据预处理技术**

数据预处理是将原始数据转换为模型可用的格式的过程。常用的数据预处理技术包括:

- **图像尺寸调整:**将图像调整为模型输入所需的尺寸。

- **数据归一化:**将图像像素值归一化到特定范围,提高模型训练的稳定性。

- **数据增强:**通过随机裁剪、旋转、翻转等方式增强数据集,提高模型的泛化能力。

**3.2.2 数据增强方法**

数据增强是通过对原始数据进行变换,生成更多训练样本的技术。常用的数据增强方法包括:

- **随机裁剪:**从图像中随机裁剪出不同大小和形状的子区域。

- **随机旋转:**将图像随机旋转一定角度。

- **随机翻转:**沿水平或垂直轴随机翻转图像。

- **颜色抖动:**随机调整图像的亮度、对比度和饱和度。

**代码块:**

```python

import cv2

import numpy as np

def random_crop(image, size):

"""随机裁剪图像

Args:

image (np.ndarray): 输入图像

size (tuple): 裁剪后图像尺寸

Returns:

np.ndarray: 裁剪后的图像

"""

h, w, _ = image.shape

x = np.random.randint(0, w - size[0])

y = np.random.randint(0, h - size[1])

return image[y:y+size[1], x:x+size[0], :]

```

**逻辑分析:**

该代码块实现了随机裁剪图像的功能。它首先获取图像的尺寸,然后随机生成裁剪区域的起始坐标。最后,使用NumPy切片操作裁剪图像并返回裁剪后的图像。

**参数说明:**

- `image`: 输入图像,形状为`(H, W, C)`。

- `size`: 裁剪后图像尺寸,形状为`(h, w)`。

# 4. yolo数据集构建进阶技巧

### 4.1 数据集优化和管理

#### 4.1.1 数据集优化策略

**1. 数据降噪**

数据降噪是指去除数据集中的异常值和噪声数据,以提高数据集的质量。常用的数据降噪方法包括:

- **中值滤波:**使用中值滤波器替换异常值,使其与周围像素的值更加一致。

- **均值滤波:**使用均值滤波器替换异常值,使其与周围像素的平均值更加一致。

- **高斯滤波:**使用高斯滤波器模糊异常值,使其与周围像素的值更加平滑。

```python

import cv2

# 读取图像

image = cv2.imread('image.jpg')

# 应用中值滤波

denoised_image = cv2.medianBlur(image, 5)

# 显示结果

cv2.imshow('Original Image', image)

cv2.imshow('Denoised Image', denoised_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**2. 数据增强**

数据增强是指通过对现有数据进行变换和处理,生成新的数据样本,以增加数据集的多样性。常用的数据增强方法包括:

- **随机裁剪:**从图像中随机裁剪出不同大小和位置的子图像。

- **随机翻转:**水平或垂直翻转图像。

- **随机旋转:**随机旋转图像一定角度。

- **随机缩放:**随机缩放图像一定比例。

```python

import cv2

import numpy as np

# 读取图像

image = cv2.imread('image.jpg')

# 应用随机裁剪

cropped_image = cv2.resize(image[100:300, 100:300], (224, 224))

# 应用随机翻转

flipped_image = cv2.flip(image, 1)

# 应用随机旋转

rotated_image = cv2.rotate(image, cv2.ROTATE_90_CLOCKWISE)

# 应用随机缩放

scaled_image = cv2.resize(image, (int(image.shape[1] * 1.2), int(image.shape[0] * 1.2)))

# 显示结果

cv2.imshow('Original Image', image)

cv2.imshow('Cropped Image', cropped_image)

cv2.imshow('Flipped Image', flipped_image)

cv2.imshow('Rotated Image', rotated_image)

cv2.imshow('Scaled Image', scaled_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

#### 4.1.2 数据集管理工具

数据集管理工具可以帮助用户高效地组织、管理和访问数据集。常用的数据集管理工具包括:

- **Labelbox:**一个基于云的平台,用于数据标注、数据集管理和模型训练。

- **SuperAnnotate:**一个基于云的平台,用于数据标注、数据集管理和计算机视觉模型开发。

- **CVAT:**一个开源的平台,用于数据标注、数据集管理和计算机视觉模型训练。

### 4.2 数据集验证和评估

#### 4.2.1 数据集验证方法

数据集验证是指检查数据集是否存在错误或不一致之处。常用的数据集验证方法包括:

- **数据类型检查:**检查数据集中的数据类型是否正确。

- **数据范围检查:**检查数据集中的数据值是否在合理的范围内。

- **数据一致性检查:**检查数据集中的数据是否相互一致。

```python

import pandas as pd

# 读取数据集

df = pd.read_csv('dataset.csv')

# 检查数据类型

print(df.dtypes)

# 检查数据范围

print(df.describe())

# 检查数据一致性

print(df.isnull().sum())

```

#### 4.2.2 数据集评估指标

数据集评估指标用于衡量数据集的质量。常用的数据集评估指标包括:

- **准确率:**数据集中的正确标注数据的比例。

- **召回率:**数据集中的所有正确标注数据被识别出来的比例。

- **F1分数:**准确率和召回率的调和平均值。

```python

from sklearn.metrics import accuracy_score, recall_score, f1_score

# 预测结果

y_pred = [0, 1, 0, 1]

# 真实标签

y_true = [0, 1, 1, 0]

# 计算准确率

accuracy = accuracy_score(y_true, y_pred)

# 计算召回率

recall = recall_score(y_true, y_pred)

# 计算F1分数

f1 = f1_score(y_true, y_pred)

# 打印结果

print('Accuracy:', accuracy)

print('Recall:', recall)

print('F1 Score:', f1)

```

# 5. yolo数据集构建案例分享

### 5.1 常见数据集构建场景

在实际应用中,yolo数据集构建场景多种多样,以下列举一些常见的场景:

- **目标检测:**构建包含目标对象图像和标注信息的数据集,用于训练目标检测模型,例如行人检测、车辆检测等。

- **图像分类:**构建包含不同类别图像和标签的数据集,用于训练图像分类模型,例如动物分类、场景分类等。

- **语义分割:**构建包含图像及其像素级标注信息的数据集,用于训练语义分割模型,例如图像分割、医学图像分割等。

- **实例分割:**构建包含图像及其每个实例的标注信息的数据集,用于训练实例分割模型,例如人脸分割、物体分割等。

- **姿态估计:**构建包含图像及其人体姿态标注信息的数据集,用于训练姿态估计模型,例如人体姿态识别、动作识别等。

### 5.2 数据集构建成功案例分析

**案例一:COCO数据集**

COCO(Common Objects in Context)数据集是一个大型目标检测和图像分割数据集,包含超过20万张图像和160万个标注。COCO数据集的成功案例在于:

- **数据量大:**庞大的数据量提供了丰富的训练样本,提高了模型的泛化能力。

- **标注质量高:**数据集中的图像和标注均经过仔细检查和验证,确保了数据质量。

- **场景多样:**数据集包含各种场景和对象,增强了模型的鲁棒性。

**案例二:ImageNet数据集**

ImageNet数据集是一个图像分类数据集,包含超过1400万张图像和2.2万个类别。ImageNet数据集的成功案例在于:

- **类别丰富:**数据集覆盖了广泛的类别,涵盖了自然界、物体、场景等。

- **数据开放:**数据集免费开放,促进了研究和模型开发。

- **推动了深度学习发展:**ImageNet数据集为深度学习模型的训练和评估提供了基准,推动了深度学习技术的发展。

0

0