【PyTorch自适应样本权重技巧】:动态调整样本重要性

发布时间: 2024-12-11 12:51:37 阅读量: 34 订阅数: 11

深圳混泥土搅拌站生产过程中环境管理制度.docx

# 1. PyTorch自适应样本权重概念与重要性

## 1.1 为何关注样本权重

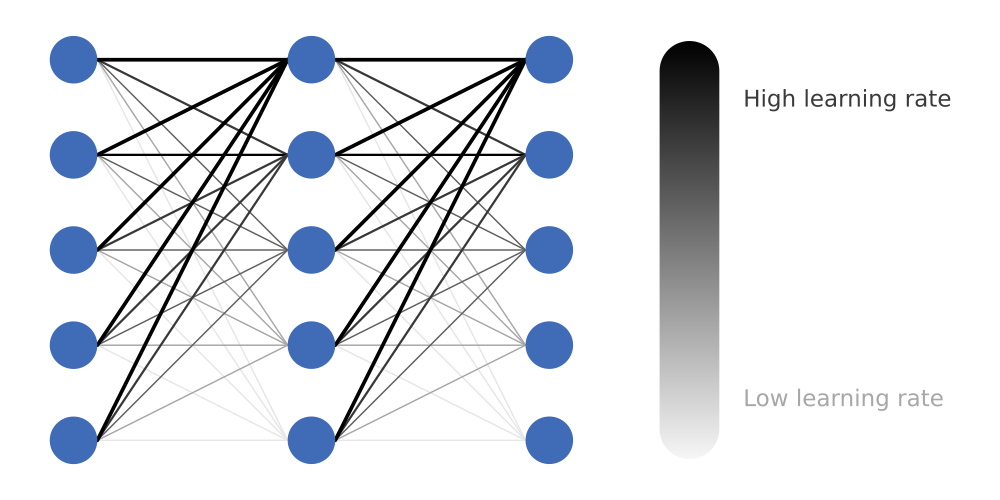

在机器学习和深度学习项目中,数据通常并不都是同等重要的。有些数据可能具有更高的信息价值,或者更能代表实际问题域。样本权重是调整模型学习过程中不同数据点重要性的一种方法。在PyTorch这样的深度学习框架中,自适应地调整样本权重可以帮助改善模型性能,特别是处理数据不平衡、噪声数据或异常值时。自适应样本权重的概念让模型能够动态地对有代表性的数据给予更高的重视,从而提高整体学习效果。

## 1.2 自适应样本权重在PyTorch中的应用

PyTorch通过其灵活的计算图和模块化设计,允许开发者轻松地实现自适应样本权重。从定义自定义损失函数开始,到在训练循环中动态更新权重,PyTorch提供了丰富的接口来支持这一过程。掌握自适应样本权重的使用不仅可以提升模型的泛化能力,还有助于在面对现实世界复杂数据时作出更好的预测。本章将探讨自适应样本权重的基本概念、重要性以及如何在PyTorch中实现它。

# 2. ```

# 第二章:自适应样本权重理论基础

自适应样本权重是机器学习中一项重要的技术,其能够显著提升模型性能,特别是在数据不平衡的情况下。本章节将深入探索样本权重的理论基础、动态权重调整策略以及其与损失函数的紧密联系。

## 2.1 样本权重在机器学习中的作用

### 2.1.1 样本权重定义和原理

样本权重是机器学习中对每个训练样本的重要性程度进行量化的一种方式。在监督学习中,每个样本都有一个对应的权重值,用来表示该样本在模型训练过程中的重要性。具有较高权重的样本对模型参数的更新影响更大,从而在一定程度上可以控制模型的预测性能。

样本权重的引入,主要是为了解决数据不平衡的问题。当数据集中某些类别的样本数量远多于其他类别时,未加权的模型可能会偏向于多数类,从而降低少数类的预测准确性。通过赋予少数类更高的权重,可以在一定程度上平衡不同类别对模型预测结果的影响,提升模型的泛化能力。

### 2.1.2 权重调整的理论模型

权重调整通常涉及到某种形式的代价函数的最小化。在有监督学习中,代价函数(或损失函数)是用来衡量模型预测值与实际值之间的差异。如果引入样本权重,则损失函数可以表示为:

```

L(θ) = ∑ wi * L(yi, f(xi; θ))

```

其中,L代表损失函数,θ是模型参数,y_i是第i个样本的真实标签,f(xi; θ)是模型对第i个样本的预测值,w_i是第i个样本的权重。通过调整每个样本的权重w_i,可以影响模型对不同样本的重视程度。

## 2.2 自适应权重调整策略

### 2.2.1 动态权重调整的基本思想

动态权重调整策略的核心思想是在模型训练的过程中,根据某种标准或规则动态地调整样本权重。这种调整可以基于模型的预测错误、样本的特性,或者样本在历史迭代中的表现。动态权重调整可以分为两类:一类是基于错误的调整,另一类是基于重要性的调整。

### 2.2.2 不同场景下的权重适应机制

权重适应机制的设计依赖于特定的应用场景和模型需求。例如,在图像分类任务中,图像中的异常像素点或噪声可能会导致模型做出错误预测。在这些情况下,可以设计一个机制来动态地增加这些异常点的权重,从而使得模型能够更加关注这些特定的区域,提高模型的鲁棒性。

在序列数据处理,如自然语言处理(NLP)中,权重适应通常与序列的某些属性相关,例如,关键词、句子的重要性或者用户反馈。通过动态地调整这些序列元素的权重,模型能够更准确地捕捉到用户的意图或文档的主题。

## 2.3 损失函数与样本权重的关系

### 2.3.1 损失函数概述

损失函数是机器学习训练过程中用来衡量模型预测值与真实值之间差异的函数。常见的损失函数包括均方误差(MSE)、交叉熵损失等。样本权重的引入,实际上是对损失函数的一个加权扩展。每个样本的权重影响着模型对这个样本的重视程度,进而影响到模型参数的更新。

### 2.3.2 权重在损失函数中的应用

权重在损失函数中的应用通常体现为对损失值的加权求和。当权重被引入到损失函数中时,模型参数的更新将受到样本权重的直接影响。在某些场景下,对于类别不平衡的数据集,可以将少数类的权重提升,以此来减少模型对多数类的偏好,增加对少数类的识别准确性。

权重与损失函数结合的策略,如Focal Loss,是为了解决在训练过程中类别不平衡问题而设计的损失函数。该损失函数通过降低容易分类样本的权重,相对提高难以分类样本的权重,从而使得模型更加关注那些难以正确分类的样本。

```

# 3. PyTorch自适应样本权重实践技巧

## 3.1 实现自适应样本权重的PyTorch模块

在深度学习中,PyTorch是一个广泛使用的开源机器学习库,它为实现自适应样本权重提供了一系列的模块。这些模块可以帮助我们设计出更加高效和准确的模型。接下来,我们将深入探讨如何在PyTorch框架下实现自适应样本权重的更新方法以及如何集成和自定义这些模块。

### 3.1.1 权重更新方法

权重更新是深度学习中非常重要的一个环节。在PyTorch中,我们通常通过定义一个损失函数并对其进行优化来更新权重。自适应样本权重的更新通常涉及对损失函数的动态调整,以反映每个样本的重要性。一个常见的方法是使用损失函数的梯度来调整权重,即损失的梯度越大,相应的样本权重也会越大。

```python

import torch

# 假设我们有一个损失函数loss和梯度gradient

loss = torch.nn.MSELoss()

gradient = torch.autograd.grad(loss, model.parameters())

# 权重更新方法示例

def update_weights(model, gradient, learning_rate):

for param, grad in zip(model.parameters(), gradient):

weight_update = grad * learning_rate

param.data.add_(weight_update)

# 使用梯度来更新模型的权重

update_weights(model, gradient, 0.01)

```

在上述代码块中,我们首先计算了损失函数的梯度,然后按照自定义的学习率进行权重更新。在实际应用中,我们可能会根据不同的条件(例如梯度的大小或样本的特征)来动态调整学习率。

### 3.1.2 模块集成与自定义

在PyTorch中,自适应样本权重模块的集成与自定义是灵活的。我们可以通过继承现有的模块类来创建一个带有自适应权重更新机制的新模块。这样的自定义模块可以直接被集成到我们现有的神经网络架构中,实现对权重的动态管理。

```python

class AdaptiveWeightModule(torch.nn.Module):

def __init__(self):

super(AdaptiveWeightModule, self).__init__()

def forward(self, x):

# 在这里定义前向传播时权重的调整逻辑

# 示例:根据输入特征动态调整权重

weights = self.get_adaptive_weights(x)

return x * weights

def get_adaptive_weights(self, x):

# 生成动态权重,这里使用简单的示例逻辑

return t

```

0

0