深入剖析Kafka消息队列:揭开分布式消息传递的奥秘

发布时间: 2024-07-08 21:38:06 阅读量: 74 订阅数: 29

深入剖析Kafka设计原理:如何构建高效的消息系统

# 1. Kafka消息队列概述**

Kafka是一个分布式流处理平台,用于处理大规模实时数据流。它提供高吞吐量、低延迟和容错性,使其成为各种应用程序的理想选择。

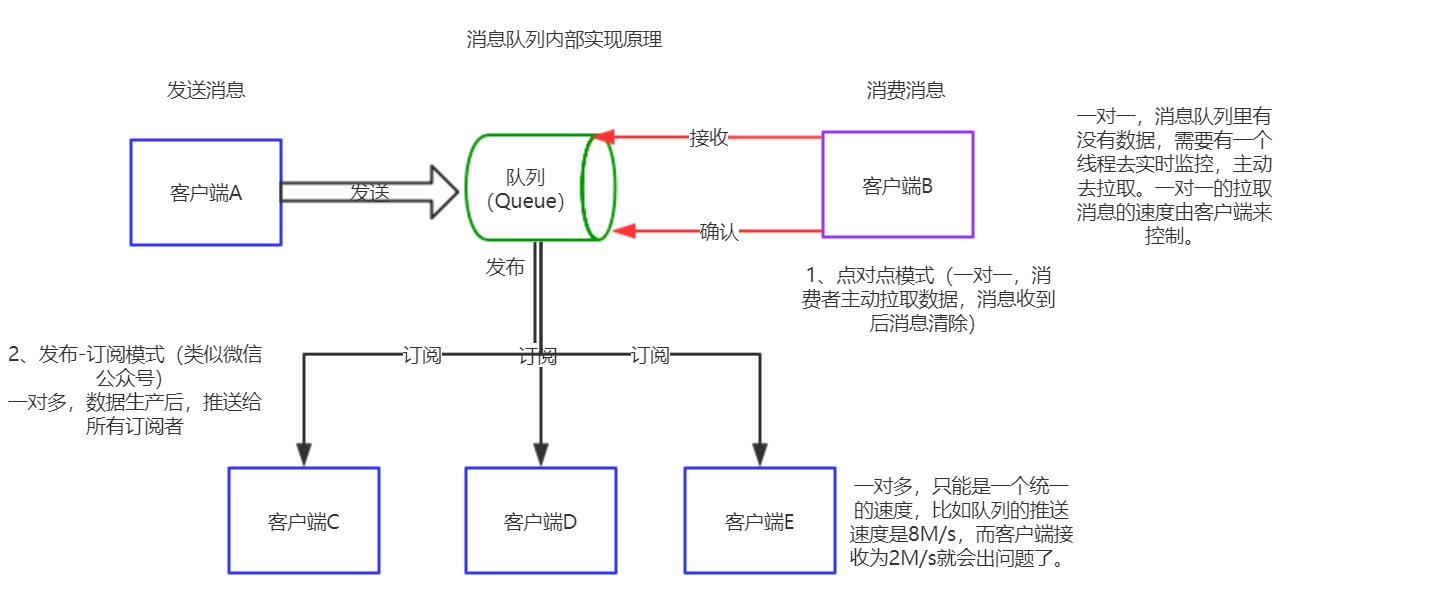

Kafka基于发布/订阅模型,其中生产者将消息发布到主题,而消费者订阅这些主题并接收消息。这种解耦的架构允许生产者和消费者独立扩展和处理。

Kafka还提供强大的数据持久化和可靠性保证,确保消息不会丢失或损坏。此外,其分布式架构和副本机制确保了集群的高可用性和容错性。

# 2. Kafka消息队列架构与原理

Kafka是一个分布式流处理平台,它允许您构建实时数据管道并处理大量数据。Kafka的架构和原理对于理解其功能和使用至关重要。

### 2.1 Kafka集群架构

#### 2.1.1 Broker、Topic和Partition

Kafka集群由称为Broker的服务器组成。Broker负责存储和管理数据。数据被组织成称为Topic的逻辑分组。Topic可以进一步细分为称为Partition的较小单元。

#### 2.1.2 数据存储和副本机制

Kafka使用一种称为副本机制的机制来确保数据的可靠性和可用性。每个Partition都有多个副本,存储在不同的Broker上。当一个Broker发生故障时,其他副本可以接管,确保数据不会丢失。

### 2.2 Kafka消息生产和消费机制

#### 2.2.1 Producer API

Producer API允许应用程序将消息发布到Kafka Topic。Producer可以配置为使用不同的压缩算法和批处理策略来优化性能。

#### 2.2.2 Consumer API

Consumer API允许应用程序从Kafka Topic消费消息。Consumer可以配置为使用不同的消费组和偏移量管理策略来控制消息的处理。

#### 2.2.3 消息的持久化和可靠性

Kafka使用一种称为提交偏移量的机制来跟踪Consumer已处理的消息。提交偏移量后,即使Broker发生故障,消息也不会被重新处理。

**代码示例:**

```java

// 创建一个Producer

Producer<String, String> producer = new KafkaProducer<>(properties);

// 创建一个Topic

Topic topic = new Topic("my-topic", 2, 1);

// 创建一个消息

ProducerRecord<String, String> record = new ProducerRecord<>(topic.getName(), "key", "value");

// 发送消息

producer.send(record);

```

**代码逻辑分析:**

* `Producer<String, String>`:指定Producer处理的数据类型为String。

* `properties`:配置Producer的属性,如连接信息和压缩算法。

* `Topic`:指定要发送消息的Topic名称、分区数和副本数。

* `ProducerRecord`:创建一条消息,指定Topic名称、键和值。

* `send`:将消息发送到Kafka。

**参数说明:**

* `properties`:可以配置以下属性:

* `bootstrap.servers`:Kafka集群的Broker地址。

* `key.serializer`:用于序列化消息键的序列化器。

* `value.serializer`:用于序列化消息值的序列化器。

* `Topic`:可以配置以下属性:

* `name`:Topic的名称。

* `partitions`:Topic的分区数。

* `replication.factor`:每个分区副本数。

# 3.1 Kafka在日志收集和分析中的应用

#### 3.1.1 Flume与Kafka的集成

Flume是一个分布式、可靠且高可用的日志收集、

0

0