PyTorch卷积神经网络:理论深度剖析与案例实战,加速学习曲线

发布时间: 2025-01-05 20:18:01 阅读量: 9 订阅数: 12

精选毕设项目-微笑话.zip

# 摘要

本文系统地探讨了使用PyTorch框架构建和训练卷积神经网络的基础理论与实践技巧。首先,介绍了卷积神经网络的基础知识,包括其结构、前向和反向传播算法,以及PyTorch中的自动梯度计算。接着,文章详细阐述了如何在PyTorch中构建和训练网络,包括模型构建、数据加载与预处理,以及实战技巧。在高级应用部分,探讨了迁移学习、网络正则化技术和序列数据处理等。文章还通过多个案例实战,如图像分类、目标检测和分割以及生成对抗网络(GAN),展示了如何将理论应用于实际问题。最后,探讨了模型优化和部署的策略,包括模型加速、压缩和跨平台部署,为深度学习实践者提供了全面的学习资源和指导。

# 关键字

PyTorch;卷积神经网络;自动梯度计算;迁移学习;模型优化;深度学习实战

参考资源链接:[用PyTorch实战深度学习:构建神经网络模型指南](https://wenku.csdn.net/doc/646f01aa543f844488dc9987?spm=1055.2635.3001.10343)

# 1. PyTorch卷积神经网络基础

## 1.1 PyTorch框架简介

PyTorch是一个开源的机器学习库,由Facebook的人工智能研究团队开发。它被广泛用于计算机视觉和自然语言处理等领域。PyTorch具有强大的动态计算图,能够直接和NumPy集成,易于调试,同时还支持并行计算。

## 1.2 卷积神经网络概述

卷积神经网络(CNNs)是一种深度学习架构,特别适用于处理具有网格拓扑结构的数据,例如时间序列和图像数据。CNNs通过使用可学习的滤波器/卷积核自动和有效地从图像中提取特征。

## 1.3 PyTorch中实现CNN的步骤

1. 导入必要的PyTorch模块。

2. 定义卷积神经网络结构。

3. 设置损失函数和优化器。

4. 加载数据集,并应用预处理和增强。

5. 训练网络并对结果进行评估。

## 1.4 代码示例

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 简单的卷积神经网络结构定义

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv = nn.Conv2d(in_channels=1, out_channels=32, kernel_size=3)

self.fc = nn.Linear(32*26*26, 10)

def forward(self, x):

x = torch.relu(self.conv(x))

x = x.view(x.size(0), -1) # Flatten the output for the fully connected layer

x = self.fc(x)

return x

# 实例化网络

model = SimpleCNN()

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

print(model)

```

此代码展示了如何在PyTorch中定义一个简单的CNN模型,包含了卷积层和全连接层。通过这个例子,我们可以开始理解PyTorch中实现CNN的基础。

在这个第一章中,我们介绍了PyTorch这个强大的深度学习框架,并对卷积神经网络做了基础概述。接着,我们通过一个具体的代码示例展示了如何在PyTorch中实现一个简单的CNN模型。这只是卷积神经网络学习之旅的起点,接下来的章节将深入探讨PyTorch深度学习理论框架,并一步步带领读者构建、训练并最终优化卷积神经网络。

# 2. PyTorch深度学习理论框架

### 2.1 神经网络的基本概念

神经网络是由大量的节点(或称为神经元)相互连接构成的网络,它受到人类大脑工作方式的启发而设计。每个连接代表着一个权重,神经元通过激活函数对输入进行非线性变换后产生输出。神经网络被广泛用于机器学习中,尤其是深度学习领域,以解决图像识别、语音识别、自然语言处理等复杂问题。

#### 2.1.1 神经网络的结构和组成部分

一个标准的神经网络包括输入层、隐藏层和输出层。每一层由多个神经元组成,这些神经元通过权值与相邻层的神经元相连。输入层接收原始数据,隐藏层用于提取数据特征,输出层产生最终的预测结果。

- **输入层**:作为网络接收数据的第一层,每个神经元对应输入数据的一个特征。

- **隐藏层**:可以有一个或多个,它们位于输入层和输出层之间,负责数据特征的抽象与转换。

- **输出层**:根据任务的类型,输出层可能是一层或者多层,分类任务通常使用全连接层。

```mermaid

graph LR

A[输入层] --> B[隐藏层1]

B --> C[隐藏层2]

C --> D[隐藏层3]

D --> E[输出层]

```

### 2.2 卷积神经网络的数学原理

卷积神经网络(CNN)是一种专门用于处理像素数据的深度学习模型,其具有空间层次结构的特点,能有效地捕捉输入数据中的空间特征。

#### 2.2.1 卷积操作的数学描述

卷积操作是CNN的核心,其数学定义为两个函数的卷积操作:

$$ s(t) = (x * w)(t) = \int_{-\infty}^{\infty} x(\tau)w(t-\tau)d\tau $$

其中,$x$ 是输入信号,$w$ 是卷积核或滤波器,$s$ 是卷积操作的结果。在离散形式下,卷积可以表示为:

$$ s(t) = \sum_{\tau}x(\tau)w(t-\tau) $$

#### 2.2.2 池化层的作用和数学解释

池化层用于降低数据的空间尺寸,它通过下采样(subsampling)减少特征图(feature maps)的维度,从而减少计算量并控制过拟合。最常用的池化操作是最大池化(max pooling),其数学定义为:

$$ s(i,j) = max(x_{k,l}) $$

其中,$(i,j)$ 表示池化窗口中的位置,$x_{k,l}$ 表示窗口内的元素。

#### 2.2.3 激活函数的选择和作用

激活函数给神经网络引入非线性因素,使得网络可以学习和模拟复杂的函数映射。常用的激活函数包括:

- **ReLU(Rectified Linear Unit)**:对于所有负输入值均返回0,对于正输入值返回输入值本身。其公式为 $f(x) = max(0, x)$。

- **Sigmoid**:将实数压缩到0和1之间,公式为 $f(x) = \frac{1}{1 + e^{-x}}$。

- **Tanh**:类似于Sigmoid函数,但输出值在-1到1之间,公式为 $f(x) = \frac{2}{1 + e^{-2x}} - 1$。

### 2.3 PyTorch中的自动梯度计算

PyTorch提供了强大的自动梯度计算功能,这是深度学习训练中的关键组成部分,它能够自动计算损失函数关于模型参数的梯度。

#### 2.3.1 计算图和梯度自动求解机制

在PyTorch中,所有的操作都是构建在计算图上的,计算图是一个有向无环图,节点表示变量,边表示操作。通过反向传播算法,PyTorch能够高效地计算出梯度,并更新网络参数。

```python

import torch

# 示例:定义一个自动计算梯度的计算图

x = torch.tensor(1.0, requires_grad=True)

y = torch.tensor(2.0, requires_grad=True)

# 定义输出变量z,z = x^2 + y^2

z = x**2 + y**2

# 反向传播,计算z关于x和y的梯度

z.backward()

print(x.grad) # 输出dz/dx

print(y.grad) # 输出dz/dy

```

#### 2.3.2 损失函数与优化器的交互机制

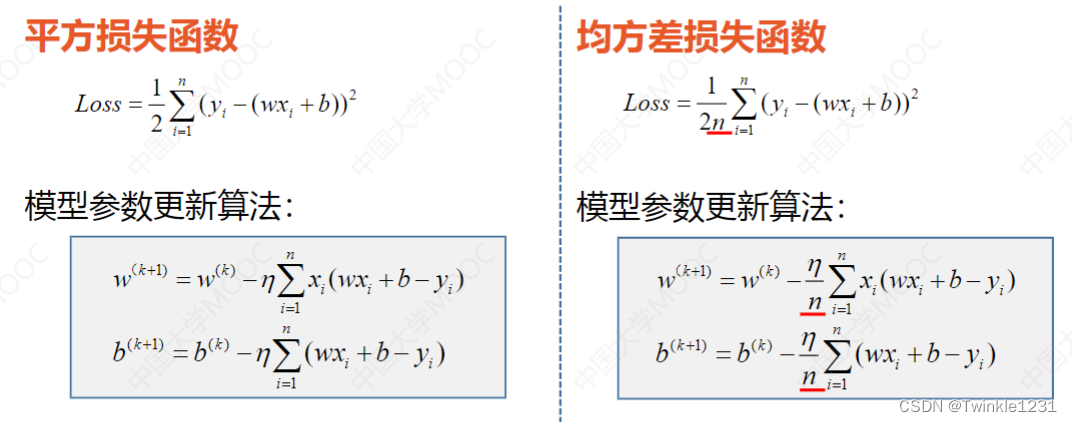

在深度学习中,损失函数用于衡量模型的预测值与真实值之间的差异。优化器则是用来更新模型的参数,以减少损失函数的值。PyTorch提供了一系列优化器如SGD(随机梯度下降)、Adam等,这些优化器通过调整模型参数来最小化损失函数。

```python

# 使用SGD优化器优化损失函数

# 定义一个随机初始化的权重张量

weights = torch.randn(4, 1, requires_grad=True)

# 定义一个简单的损失函数

def loss_fn(input, target):

return torch.mean((input - target)**2)

# 定义优化器

optimizer = torch.optim.SGD([weights], lr=0.01)

# 假设input_data和target_data是输入数据和目标数据

input_data = torch.randn(4, 1)

target_data = torch.randn(4, 1)

# 前向传播

output = weights * input_data

# 计算损失

loss = loss_fn(output, target_data)

# 反向传播

loss.backward()

# 更新权重

optimizer.step()

# 重置梯度

optimizer.zero_grad()

```

以上示例展示了在PyTorch中如何构建一个基本的自动梯度计算流程,涵盖了计算图的建立、损失函数的定义、优化器的选择和权重更新的步骤。通过这种方式,我们可以在训练深度学习模型时,自动完成梯度的计算和参数的更新。

# 3. 构建和训练卷积神经网络

## 3.1 PyTorch中的模型构建

### 3.1.1 使用nn.Module构建自定义层

在PyTorch中,所有的神经网络模型都是从`nn.Module`这个基类派生出来的。要构建自定义的网络层,我们需要定义一个继承自`nn.Module`的类,实现其构造函数`__init__`和前向传播函数`forward`。

```python

import torch.nn as nn

class CustomConvLayer(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size):

super(CustomConvLayer, self).__init__()

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size)

def forward(self, x):

x = self.conv(x)

return x

```

在上述代码中,`CustomConvLayer`类首先在构造函数中初始化了一个卷积层,其参数包括输入通道数、输出通道数和卷积核大小。然后,它在`forward`方法中定义了输入数据如何通过这个卷积层。当一个`CustomConvLayer`实例被创建并调用`forward`方法时,它会应用定义好的卷积操作。

### 3.1.2 预定义的卷积层和池化层

PyTorch提供了一系列预定义的层来简化网络构建过程,这些层包括卷积层(`Conv2d`)、池化层(`MaxPool2d`)等。

```python

# 定义一个卷积层

conv_layer = nn.Conv2d(in_channels=3, out_channels=32, kernel_size=3, padding=1)

# 定义一个最大池化层

pooling_layer = nn.MaxPool2d(kernel_size=2, stride=2)

```

在使用这些预定义的层时,开发者可以简单地指定层的参数,如输入输出通道数、卷积核大小、填充、步长等。这些层已经经过高度优化,能够快速在GPU上运行,极大地提高了模型构建和训练的效率。

## 3.2 数据加载与预处理

### 3.2.1 DataLoader的使用和自定义

`DataLoader`是PyTorch中用于封装数据集并提供迭代加载数据的类。它可以帮助我们以批次方式高效地加载数据,并可以进行多线程的数据预处理。

```python

from torch.utils.data import DataLoader

from torchvision import datasets,

```

0

0