基于Hadoop的网站日志分析实践报告详解

版权申诉

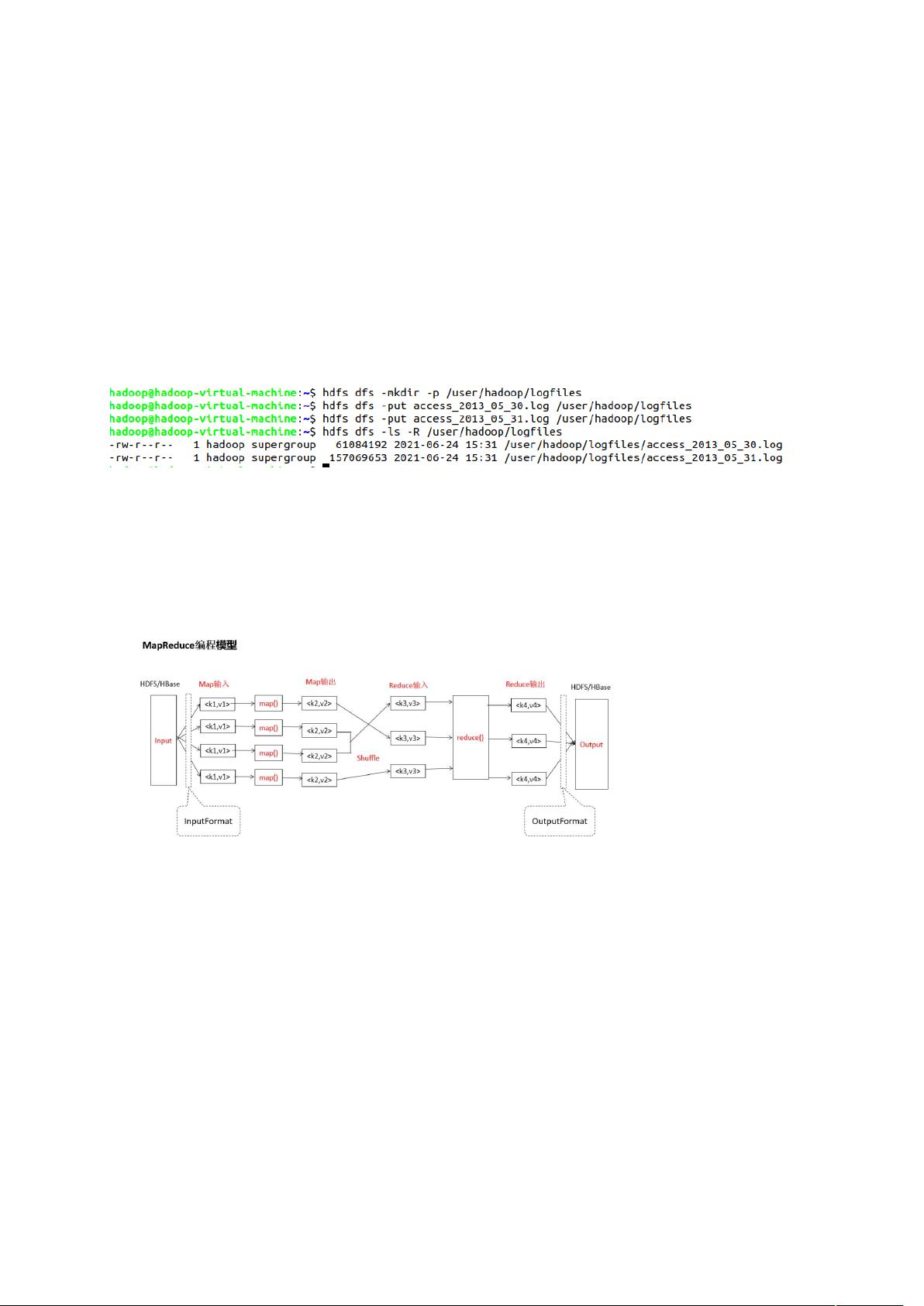

首先要准备Hadoop环境,需要安装VMware并开启Hadoop集群。在集群中,NameNode是Hadoop中的主服务器,负责管理文件系统名称空间和对集群中存储的文件的访问;Secondary NameNode是在Hadoop中用来备份NameNode的数据,以防止NameNode崩溃导致数据丢失;DataNode是存储实际数据的节点,负责处理文件系统的读写操作。此外,还需要确保Hadoop的各个进程都已经正确启动。

3.2 使用Python开发的mapper reducer进行数据处理

通过使用Python开发的mapper和reducer,对数据进行处理。mapper负责将原始数据进行映射,并根据指定的键值对进行分组;reducer则负责对mapper输出的中间结果进行归约,最终得到需要的结果。

3.3 创建Hive数据库,将处理的数据导入Hive数据库

在Hadoop环境中,创建Hive数据库,并将处理过的数据导入其中。Hive是一个数据仓库工具,可以将结构化的数据文件映射成一张数据库表,并提供类SQL查询功能。

3.4 将分析数据导入MySQL

最后,将经过处理和分析的数据导入MySQL数据库中,以便进一步的数据分析和处理操作。

4. 实践效果及总结

通过以上的部署及实践,我们成功地使用Hadoop对网站日志进行了分析。在此过程中,我们充分利用了Hadoop集群的并行计算和分布式存储的优势,加快了数据处理和分析的速度,提高了效率。同时,通过将数据导入Hive和MySQL数据库,也为我们未来的数据分析和挖掘工作打下了良好的基础。总的来说,本次实践取得了良好的实践效果,也为我们在大数据分析方面的学习和工作提供了宝贵的经验。

综上所述,通过基于Hadoop的部署实践对网站日志进行分析,我们成功地完成了一次数据处理和分析的实践。通过使用Hadoop集群和相关工具,我们加快了数据处理和分析的速度,提高了工作效率,并为未来的数据分析工作打下了良好的基础。希望通过本次实践,可以对大数据处理和分析方面的学习和工作有所帮助。

2020-04-30 上传

2024-09-15 上传

2019-06-11 上传

王小王-123

- 粉丝: 7w+

- 资源: 106

最新资源

- 探索数据转换实验平台在设备装置中的应用

- 使用git-log-to-tikz.py将Git日志转换为TIKZ图形

- 小栗子源码2.9.3版本发布

- 使用Tinder-Hack-Client实现Tinder API交互

- Android Studio新模板:个性化Material Design导航抽屉

- React API分页模块:数据获取与页面管理

- C语言实现顺序表的动态分配方法

- 光催化分解水产氢固溶体催化剂制备技术揭秘

- VS2013环境下tinyxml库的32位与64位编译指南

- 网易云歌词情感分析系统实现与架构

- React应用展示GitHub用户详细信息及项目分析

- LayUI2.1.6帮助文档API功能详解

- 全栈开发实现的chatgpt应用可打包小程序/H5/App

- C++实现顺序表的动态内存分配技术

- Java制作水果格斗游戏:策略与随机性的结合

- 基于若依框架的后台管理系统开发实例解析