SparkStreaming:大数据流处理的高效解决方案

42 浏览量

更新于2024-08-30

收藏 346KB PDF 举报

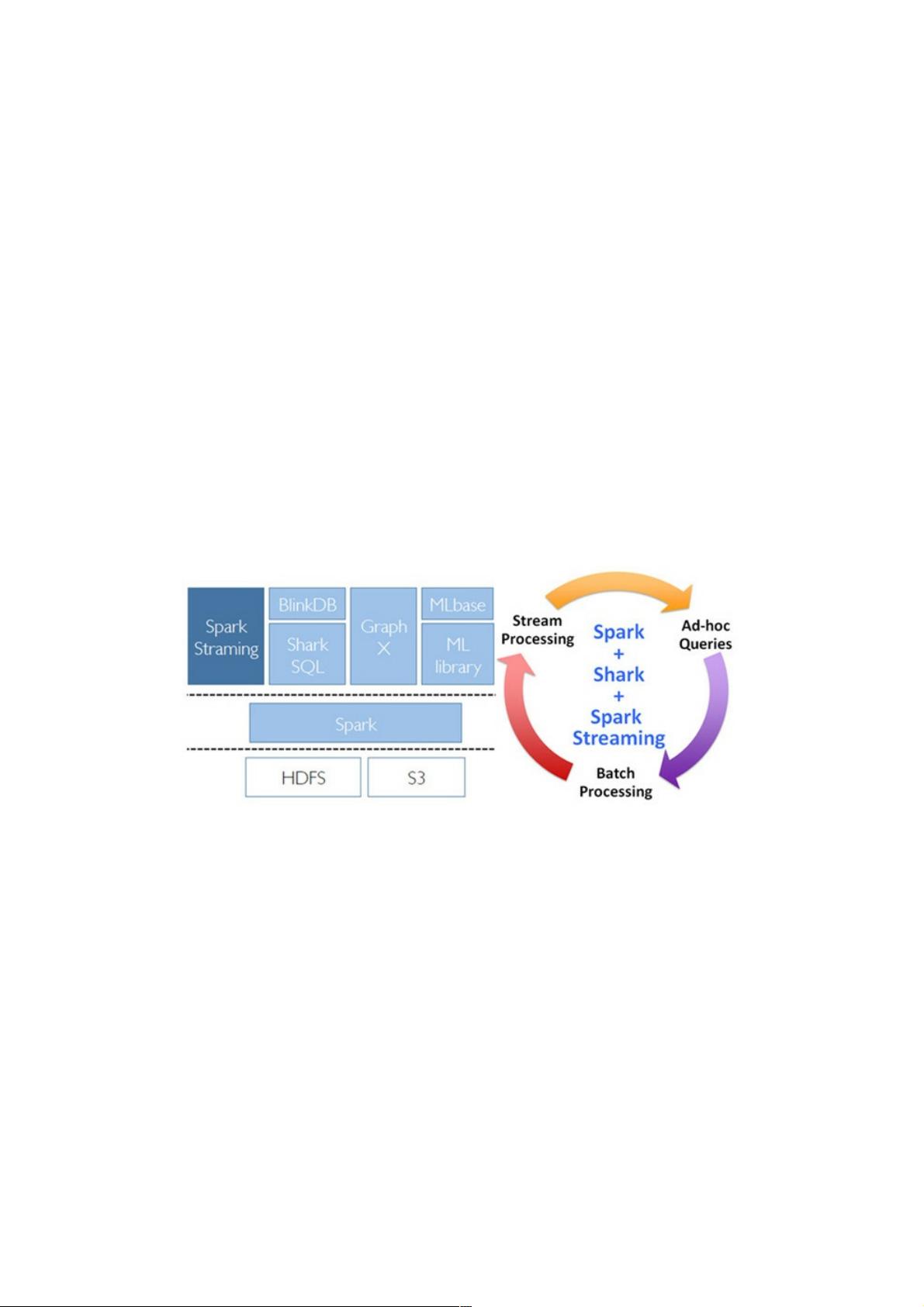

Spark Streaming是Apache Spark项目中的一个重要组件,专为大规模流式数据处理而设计,它将传统的实时流处理问题转化为一系列短小的批处理任务,实现了低延迟和高吞吐量。Spark Streaming的核心思想是将连续的事件流拆分成固定时间间隔的批次,每个批次内的数据再通过Spark的并行计算模型进行处理。

Spark Streaming的架构主要包含以下几个关键部分:

1. **Input DStream**:它是Spark Streaming的基本构建块,表示数据源产生的数据流,如Kafka、Flume、Twitter等。Input DStream会将数据划分成时间窗口,每个窗口内的数据用于一次批处理操作。

2. **Batch Processing Engine**:Spark Streaming使用Spark的批处理引擎,例如DAG(有向无环图)执行计划,将数据流转化为一系列短小的批次,这些批次在内存中进行高效处理,减少了IO操作。

3. **Windowing and Sliding Windows**:Spark Streaming提供了两种窗口模式——滑动窗口和固定窗口,它们定义了数据处理的时间范围,使得系统可以在特定时间段内聚合和分析数据。

4. **Transformation and Action**:用户可以通过各种Spark API(如map, filter, reduceByKey等)对DStreams进行转换,生成新的DStreams。Action操作则在每个时间窗口结束时触发,生成最终的结果,如统计、聚合或持久化。

5. **Memory-based Computation**:Spark Streaming利用内存计算的优势,减少磁盘I/O,提高了处理速度。这对于实时分析和迭代计算特别有效。

在实际应用中,Spark Streaming广泛应用于日志分析、实时监控、社交网络分析等领域。为了克服不同数据处理场景之间的数据共享、资源管理和团队协作问题,Spark Streaming与Berkeley Data Analytics Stack (BDAS)结合,形成一个统一的软件栈。BDAS以Spark为基础,提供了Batch(批处理)、Interactive(交互式查询)和Streaming(流处理)的全面解决方案,通过兼容HDFS和S3等分布式存储系统,以及YARN和Mesos等资源管理器,实现了高效和灵活的数据处理。

Spark Streaming是大数据时代处理实时流数据的强大工具,通过其独特的架构和编程模型,有效地解决了大规模流式数据处理中的挑战,使得实时分析成为可能。通过理解和掌握Spark Streaming,企业可以更有效地整合其大数据处理流程,降低运营成本,并提升业务决策的时效性。

2023-09-26 上传

457 浏览量

2023-07-09 上传

107 浏览量

128 浏览量

276 浏览量

157 浏览量

164 浏览量

weixin_38621104

- 粉丝: 1

- 资源: 957