Spark2中的累加器使用与自定义实现解析

需积分: 16 51 浏览量

更新于2024-09-06

收藏 72KB DOCX 举报

Spark2中的累加器是一种分布式变量机制,类似于MapReduce的并行操作,用于在计算过程中累积各个节点的局部变化,并最终在Driver端聚合。它在调试时非常有用,可以用来统计作业执行过程中的事件次数。

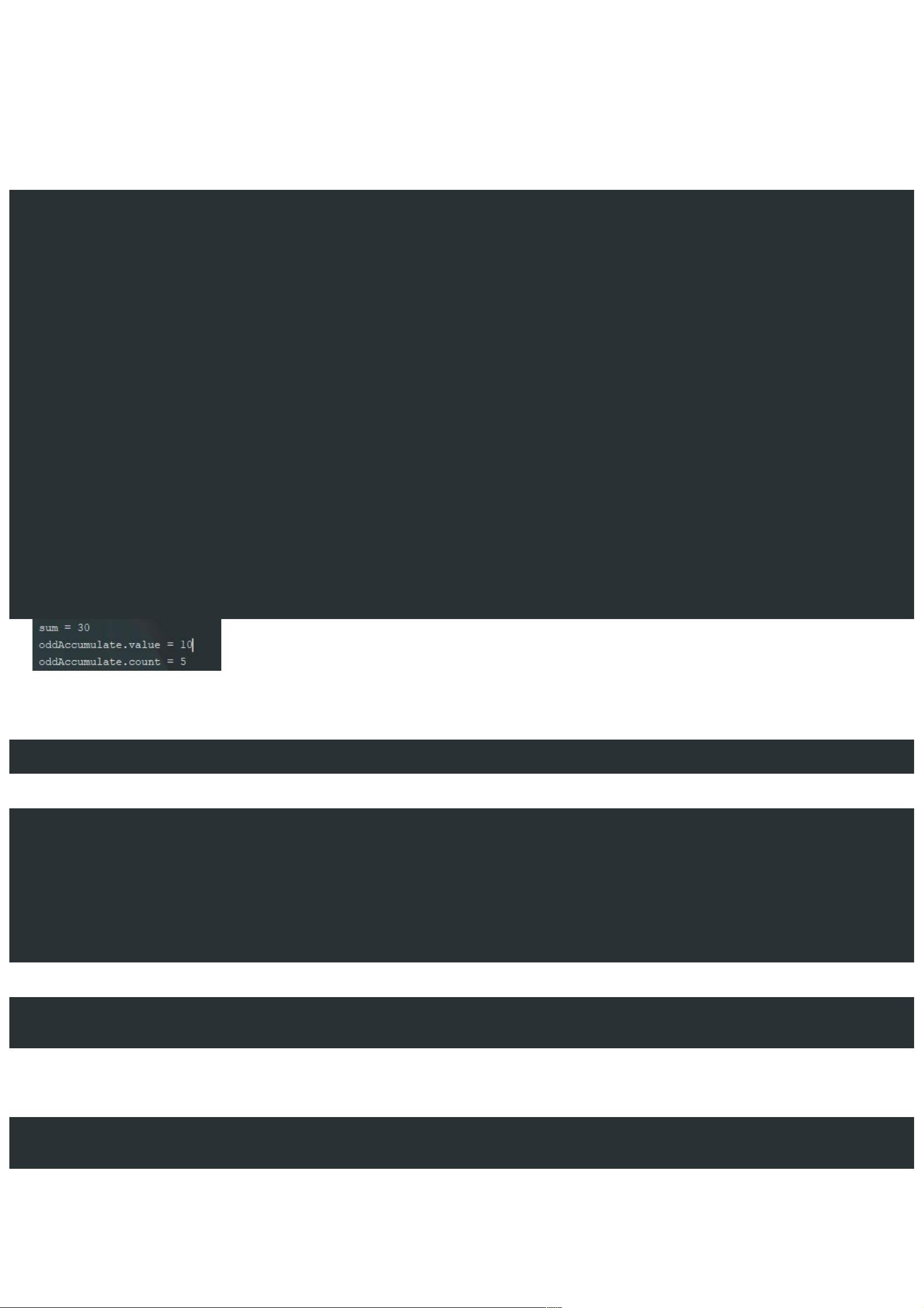

Spark内置了Long和Double类型的累加器,可以直接使用。例如,在以下代码示例中,我们创建了一个名为“testAccumulate”的LongAccumulator,用于在过滤出RDD中偶数的同时计数奇数。在RDD中,我们遍历元素,如果元素是奇数,则向累加器添加2L,并返回false,这样该元素不会被包含在reduce操作中;如果是偶数,则返回true,保留该元素。最后,我们打印出过滤后的元素总和,以及累加器中记录的奇数个数和累加值。

```scala

def main(args: Array[String]): Unit = {

val sparkSession = SparkSession

.builder()

.appName("MyAccumulate")

.master("local[2]")

.getOrCreate()

val sc = sparkSession.sparkContext

val oddAccumulate = sc.longAccumulator("testAccumulate")

val rdd = sc.parallelize(1 to 10)

val sum = rdd

.filter(x => {

if (x % 2 != 0) {

oddAccumulate.add(2L)

false

} else {

true

}

})

.reduce(_ + _)

println(s"sum=$sum")

println(s"oddAccumulate.count=${oddAccumulate.count}")

println(s"oddAccumulate.value=${oddAccumulate.value}")

sc.stop()

}

```

Spark2提供了三种累加器:CollectionAccumulator、LongAccumulator和DoubleAccumulator。其中,LongAccumulator和DoubleAccumulator都维护了 `_sum` 和 `_count` 两个内部变量,分别用于存储累加的总值和操作次数。`add` 方法会根据传入的值类型更新这两个变量。

需要注意的是,累加器只能在任务的执行阶段被任务内部修改,而不能在Driver端直接修改。这意味着在Driver端调用累加器的`add`方法不会有任何效果,只有Executor中的任务才能更新累加器的值。此外,累加器的值只能在作业完成时通过Driver端获取,而不能在任务执行过程中获取,这保证了数据的正确性。

在实际使用中,还需要注意以下几点:

1. **广播变量与累加器的区别**:广播变量允许你将一个只读变量广播到集群的所有Executor,而累加器则用于聚合操作。两者不能互相替代。

2. **累加器的线程安全**:Spark中的累加器是线程安全的,可以在同一个任务的多个线程间共享。

3. **容错性**:如果任务失败并重新调度,累加器的值不会丢失,因为每个任务都会重新执行所有累加操作。

4. **累加器的局限性**:累加器不适用于所有类型的数据聚合,例如,如果你想合并两个RDD,应该使用`reduceByKey`或`groupByKey`等操作,而不是累加器。

5. **跨应用生命周期**:累加器的值只在当前Spark应用的生命周期内有效。如果你重启应用,累加器的值会被重置。

Spark2中的累加器是优化分布式计算过程中的调试和统计工具,通过正确理解和使用累加器,可以有效地监控和优化Spark应用程序的性能。在实际项目中,根据需求选择合适的累加器类型,并注意其使用限制,可以更好地实现数据的分布式处理。

2017-03-06 上传

2020-03-29 上传

2023-02-24 上传

2023-09-04 上传

2023-06-10 上传

2024-11-04 上传

2023-05-30 上传

2023-05-31 上传

第一片心意

- 粉丝: 172

- 资源: 20

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程