ML Visuals:神经网络可视化工具

需积分: 0 117 浏览量

更新于2024-06-27

收藏 4.47MB PPTX 举报

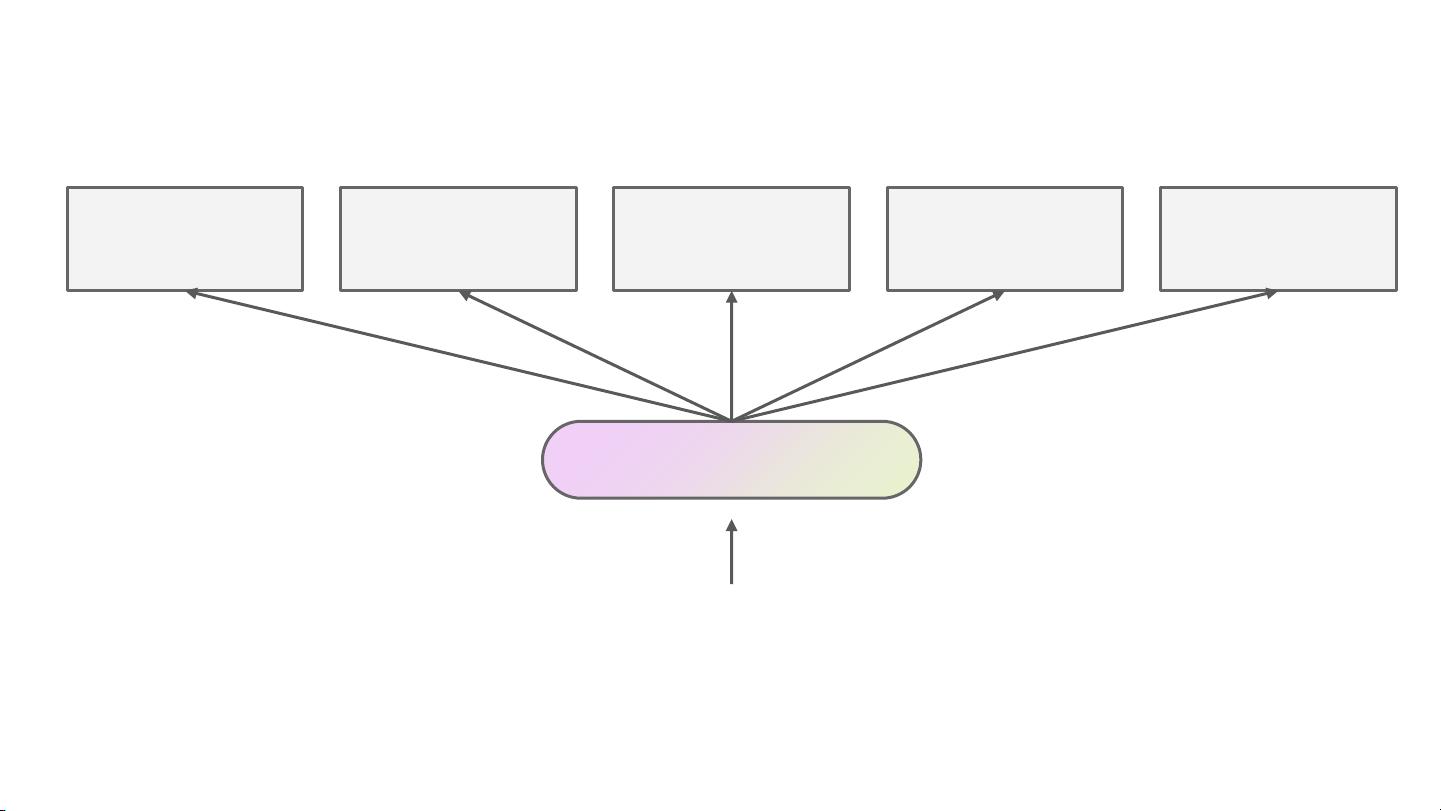

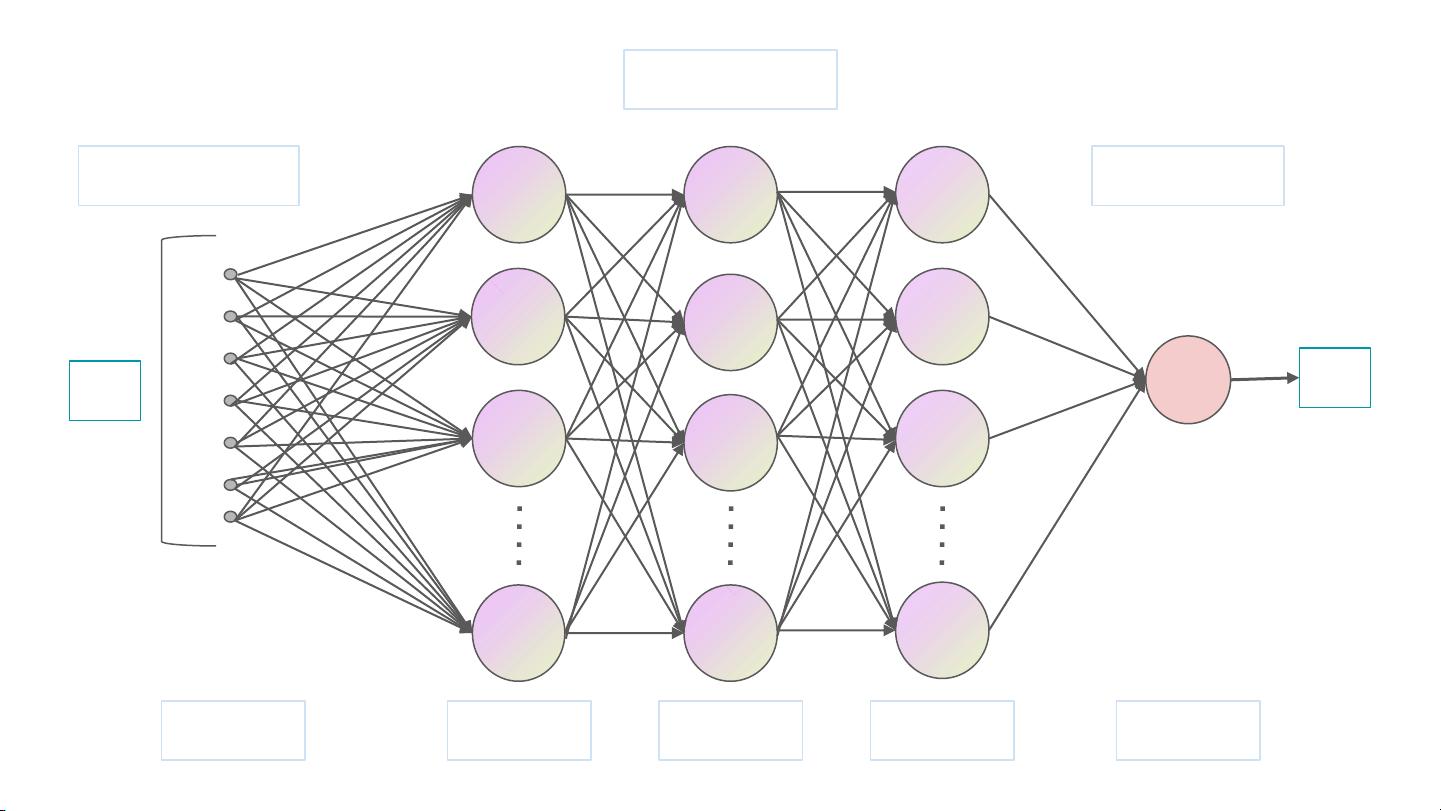

"MLVisuals 是一个由 Bydair.ai 创建的开源项目,它提供了一系列机器学习和深度学习模型的可视化模板,旨在帮助开发者和研究人员更直观地理解各种复杂的神经网络结构。该项目在 GitHub 上获得了 6.1K 的 Star,证明了其在社区中的受欢迎程度和实用性。MLVisuals 包含了多种常见的神经网络组件,如 Softmax、卷积层(Convolve)、锐化操作(Sharpen)、位置编码(Positional Encoding)、前向传播(Feed Forward)、归一化(Add&Norm)、线性层、多头注意力机制(Multi-Head Attention)以及掩码多头注意力等。通过这些模板,用户可以方便地绘制出自己模型的架构,从而更好地进行教学、演示或论文插图。"

以下是对相关知识点的详细说明:

1. **Softmax**:Softmax 函数是一种常用的激活函数,用于将多分类问题的输出转换为概率分布。在神经网络中,Softmax 可以将任意实数值向量转换为和为1的正向概率分布,每个元素表示对应类别的概率。

2. **卷积层(Convolution)**:卷积层是深度学习模型中处理图像数据的关键组件,特别是在卷积神经网络(CNN)中。它通过滤波器(或称卷积核)对输入图像进行扫描,提取特征并降低维度,有助于识别图像模式。

3. **锐化操作(Sharpen)**:锐化操作通常是在卷积层之后应用,以增强图像的边缘和细节,提高图像的清晰度。这在图像处理和计算机视觉任务中常用来提升特征的可辨识性。

4. **位置编码(Positional Encoding)**:在Transformer模型中,位置编码被用来引入顺序信息,因为纯自注意力机制无法区分序列中元素的位置。位置编码通常是向输入序列添加的信号,以帮助模型理解元素在序列中的相对位置。

5. **前向传播(Feed Forward)**:前向传播是神经网络计算过程的一部分,从输入层到输出层,依次经过每一层进行计算,不包括反向传播过程。在MLVisuals中,这表示模型从输入到输出的计算路径。

6. **归一化(Add&Norm)**:归一化通常指层间操作,如批量归一化(Batch Normalization),它标准化层的输出,加速训练,减少内部协变量位移,并可能改善模型性能。

7. **线性层(Linear)**:线性层是神经网络中最基本的层类型,它执行输入与权重矩阵的乘法加上偏置项的操作,通常作为全连接层出现。

8. **多头注意力机制(Multi-Head Attention)**:多头注意力是Transformer模型的核心组成部分,它允许模型同时关注输入序列的不同部分,增强了模型捕捉上下文信息的能力。

9. **掩码多头注意力(Masked Multi-Head Attention)**:在某些序列建模任务中,如语言模型,未来信息是未知的,因此需要掩码操作来阻止模型看到未来的输入,确保预测的序列性。

10. **输入和输出层(Input Layer, Hidden Layers, Output Layer)**:输入层接收原始数据,隐藏层负责学习和转换数据,而输出层则产生模型的最终预测结果。在MLVisuals中,这些层的可视化有助于理解模型的整体架构。

这些可视化工具能够极大地提升理解和解释复杂神经网络的能力,使非专业人员也能更容易地进入深度学习领域。通过MLVisuals,开发人员可以更有效地沟通他们的模型设计,并促进团队间的合作。

2021-02-04 上传

2023-05-16 上传

2023-05-16 上传

2023-05-31 上传

2023-07-08 上传

2023-06-25 上传

2023-04-21 上传

小樊努力努力再努力

- 粉丝: 66

- 资源: 4

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景