深度学习:GAN的谱归一化与Lipschitz约束解析

需积分: 0 190 浏览量

更新于2024-08-05

收藏 584KB PDF 举报

"本文主要探讨了GAN(生成对抗网络)中的谱归一化(Spectral Normalization)原理,包括Lipschitz约束在GAN中的重要性、多元线性函数的Lipschitz条件以及复合函数的Lipschitz约束性质。"

在深度学习领域,特别是在GANs中,Lipschitz约束是一个关键的概念。这一约束要求模型的函数输出变化不超过输入变化的固定比例,以确保模型的稳定性。在 Wasserstein GAN (WGAN) 中,Lipschitz约束是必需的,因为它确保了判别器近似的是Wasserstein距离,从而提高训练的稳定性。即使在非Wasserstein GANs中,这种约束也能帮助避免训练过程中的梯度爆炸问题。

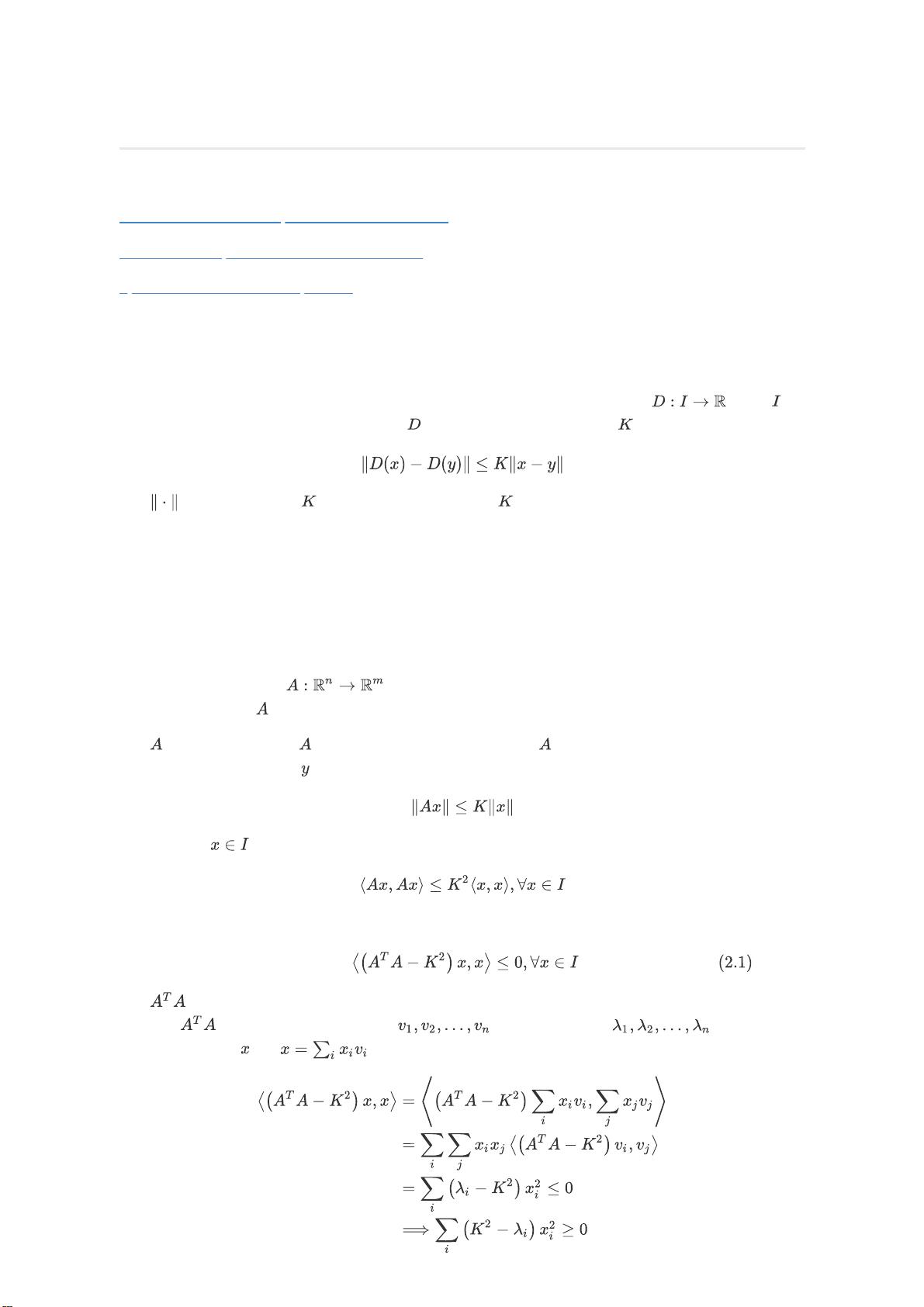

对于多元线性函数,其Lipschitz常数等于其梯度矩阵(在多层感知机中,即权重矩阵)的谱范数,也就是最大特征值的平方根。这是因为线性函数的Lipschitz约束可简化为矩阵的特征值分析。每个特征值代表了函数沿对应特征向量方向的放大倍数,最大特征值决定了函数的全局放大程度。因此,线性函数的Lipschitz常数就是最大特征值的开方,即矩阵的谱范数。

当涉及到复合函数,如多层神经网络,每一层的Lipschitz常数的乘积将决定整个网络的Lipschitz常数。这意味着,为了确保整个网络满足Lipschitz约束,我们需要控制每层的Lipschitz常数,而谱归一化就是一种实现这一目标的方法。

谱归一化是一种正则化技术,它通过限制网络层权重矩阵的最大特征值来保持网络的Lipschitz连续性。具体操作是,在每次前向传播时,对权重矩阵进行谱归一化,使其最大特征值不超过1,从而保证了该层的Lipschitz常数不超过1。这样,整个网络的Lipschitz常数就可以通过链式规则控制在预定范围内,有助于改善GAN的训练稳定性和生成质量。

幂迭代是谱归一化中用于计算权重矩阵特征值的一种算法。它通过不断将矩阵与其自身相乘并除以当前估计的最大特征值,逐步逼近矩阵的真实最大特征值,直到达到收敛。这种方法在计算效率上比直接计算特征值更为高效,特别适合在大型神经网络中应用。

谱归一化是深度学习,尤其是GANs中一种有效的正则化策略,它利用Lipschitz约束来稳定训练过程,提高生成结果的质量。通过限制权重矩阵的谱范数,它可以确保模型的输出变化与输入变化保持在一个合理的比例范围内,从而避免梯度爆炸和模式崩溃等问题。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2019-08-11 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

df595420469

- 粉丝: 32

- 资源: 310

最新资源

- 深入了解Django框架:Python中的网站开发利器

- Spring Boot集成框架示例:深入理解与实践

- 52pojie.cn捷速OCR文字识别工具实用评测

- Unity实现动态水体涟漪效果教程

- Vue.js项目实践:饭否每日精选日历Web版开发记

- Bootbox:用Bootstrap实现JavaScript对话框新体验

- AlarStudios:Swift开发教程及资源分享

- 《火影忍者》主题新标签页壁纸:每日更新与自定义天气

- 海康视频H5player简易演示教程

- -roll20脚本开发指南:探索roll20-master包-

- Xfce ClassicLooks复古主题更新,统一Linux/FreeBSD外观

- 自建物理引擎学习刚体动力学模拟

- Python小波变换工具包pywt的使用与实例

- 批发网导航程序:自定义模板与分类标签

- 创建交互式钢琴键效果的JavaScript库

- AndroidSunat应用开发技术栈及推介会议