决策树与Adaboost:归纳学习与信息增益应用

需积分: 45 97 浏览量

更新于2024-07-18

收藏 736KB PDF 举报

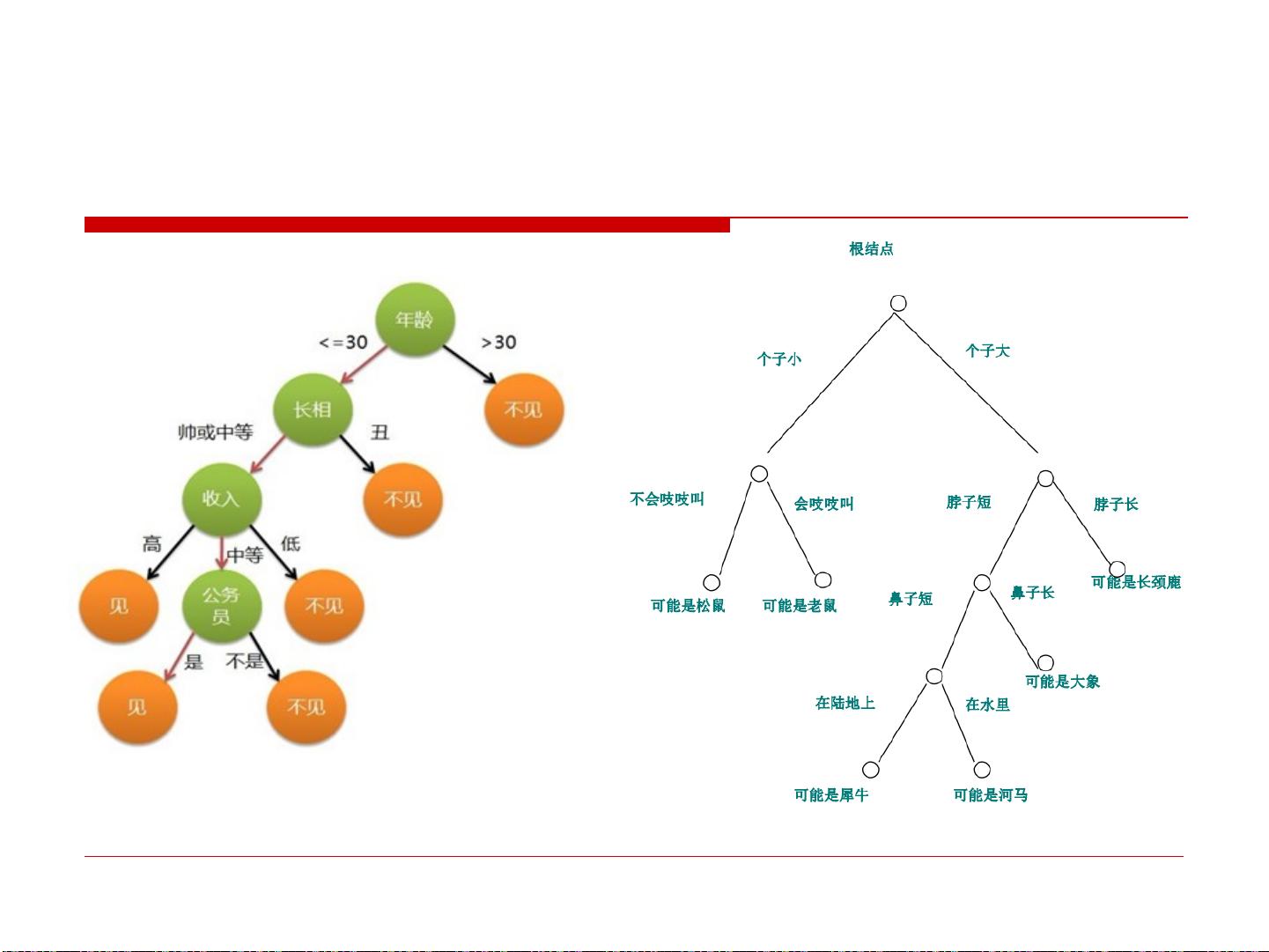

决策树是一种基于归纳推理的有效工具,它通过构建树状结构来表达概念空间,常用于分类和预测任务。决策树的学习方法特别适合处理不相关的多个概念,因其易于理解和实现,在众多领域如金融、医疗、电子商务等有着广泛的应用。

决策树的核心是其结构,每个内部节点代表一个属性测试,分支表示测试结果,而叶节点则代表最终的类别。例如,对于一个二元分类问题,决策树可能会询问一系列问题,如“年龄小于30岁吗?”、“性别为女性吗?”等,直到找到一个确定分类的属性。这种自顶向下的递归方法在构建过程中,目标是选择能够最大程度地降低节点划分后子集的熵或信息增益的属性,从而逐步细化决策规则。

信息增益是评估特征对分类重要性的关键指标,它是通过比较数据集在使用特征前后的不确定性变化来计算的。具体来说,信息增益(g(D,A))等于原始数据集D的经验熵H(D)减去特征A条件下数据集的经验条件熵H(D|A)。选择信息增益最大的特征作为当前分裂点,可以确保在划分过程中获得最大的分类纯度提升。

常见的决策树学习算法有ID3、C4.5(C5.0)和CART(Classification and Regression Trees)。ID3最初使用的是信息增益作为分裂标准,而C4.5引入了处理缺失值和连续属性的能力。CART则适用于回归和分类问题,它使用的是基尼不纯度或Gini指数作为分裂标准。

决策树学习算法的一大优点是它的可解释性,生成的树状结构直观易懂,用户可以轻松理解分类规则。然而,决策树容易过拟合,特别是在数据不平衡或特征之间存在复杂交互时。为解决这个问题,Adaboost是一种集成学习方法,它通过组合多个弱分类器(如决策树)形成一个强分类器,每个弱分类器针对先前错误分类的样本进行加权训练,从而提高整体性能。

总结来说,决策树是机器学习中一种重要的基础模型,其构建过程强调信息选择和分类纯度优化。而Adaboost作为一种增强技术,通过调整样本权重和训练顺序,进一步提升了决策树在实际应用中的稳定性和准确性。

2024-01-29 上传

2024-03-02 上传

2023-07-25 上传

2023-12-05 上传

2023-06-13 上传

2023-06-02 上传

GoodbyeSH

- 粉丝: 0

- 资源: 1

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性