信息论基础:熵与互信息的概念解析

需积分: 11 157 浏览量

更新于2024-07-09

收藏 1.74MB PPT 举报

"熵(Entropy)是信息论中的核心概念,用于量化随机事件的不确定性。在通信系统中,由于信息的传递通常涉及到不确定性的事件,因此熵成为了衡量信息量的关键指标。例如,第一次出门遇到的乌鸦颜色可能是白色或黑色,这种不确定性就反映了该事件的信息含量。同样,遇见的人是否是左撇子、性别是男性还是女性,这些事件的不确定性也含有不同的信息。

1.1 不确定性与自信息

自信息(Self-information)是衡量一个特定事件发生时信息量的大小,通常用比特(bit)来表示。自信息的计算公式为I(x) = -log2(P(x)),其中P(x)是事件x发生的概率。如果事件非常不可能发生,那么它的自信息值就很高,因为它携带了大量信息。

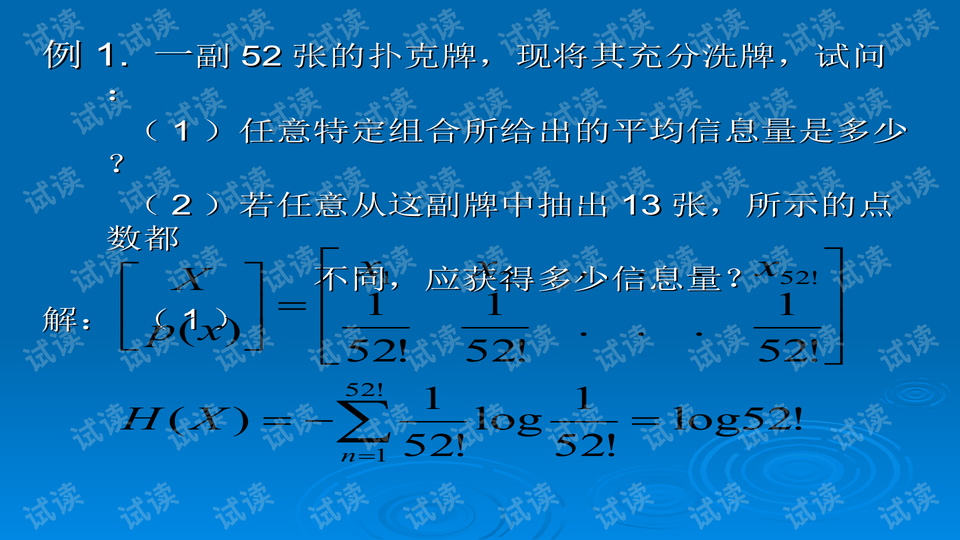

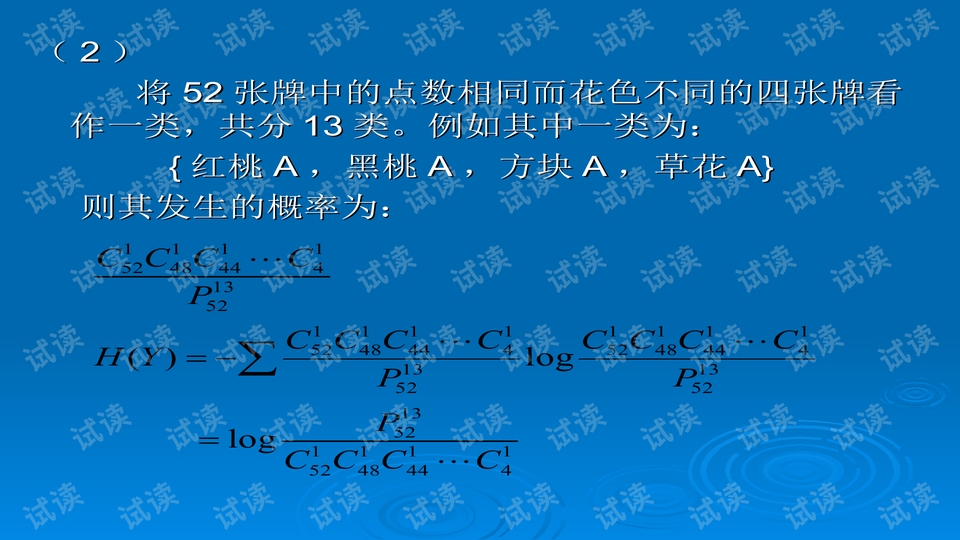

1.2 Shannon离散熵

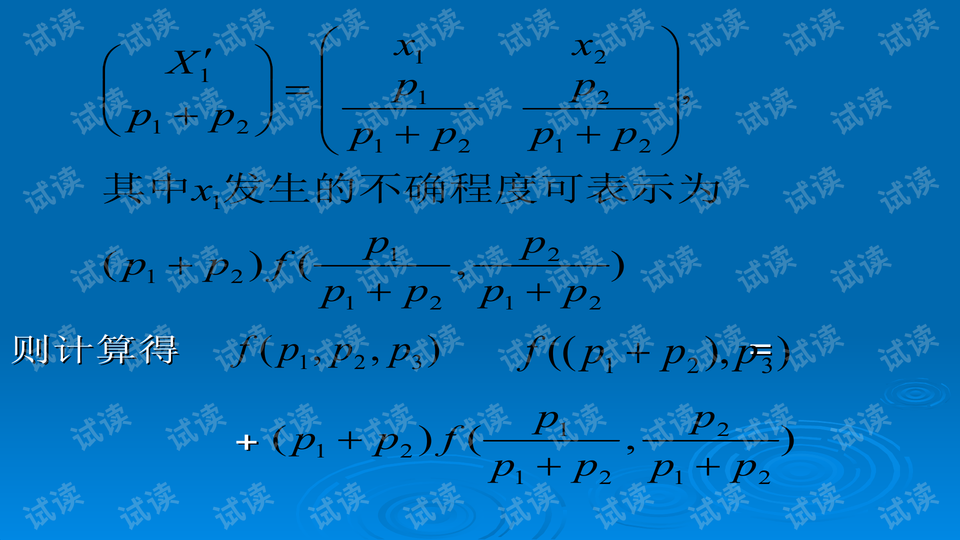

Shannon离散熵是描述随机变量平均自信息的期望值,它是所有可能事件自信息的加权平均。离散熵的公式为H(X) = Σ P(x_i) * I(x_i) = -Σ P(x_i) * log2(P(x_i))。离散熵的最大值发生在所有事件等概率时,此时熵达到最大,表示系统的不确定性最高。

1.2.1 单变量熵函数

单变量熵函数描述了一个随机变量的信息不确定性,它是一个非负的对数函数,反映了随机变量所有可能取值的信息含量。

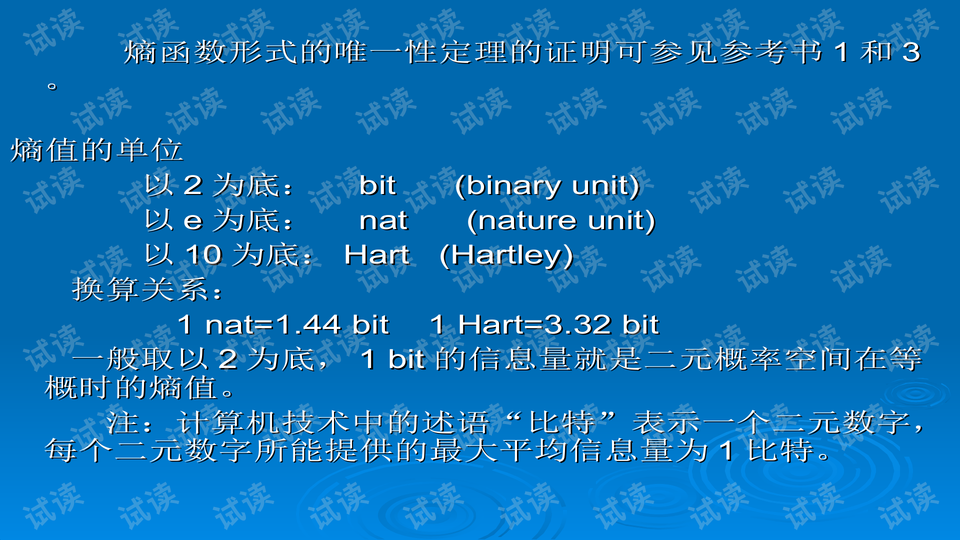

1.2.2 形式的唯一性

离散熵的这种形式是唯一的,因为它满足熵的一些基本性质,如非负性、无序性以及对于独立事件的加法性。

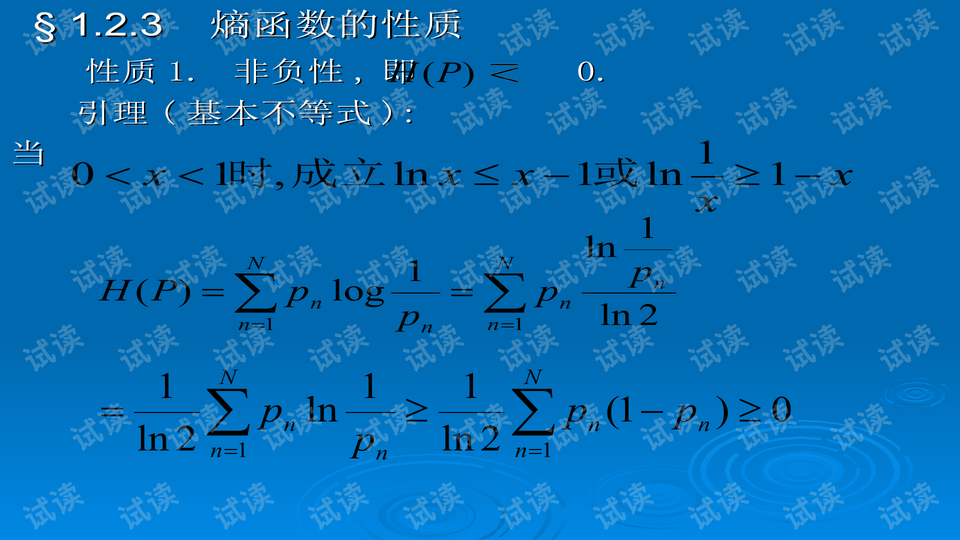

1.2.3 离散熵的性质

离散熵具有以下性质:当事件的概率分布均匀时,熵最大;当事件必然发生时,熵为0,因为没有不确定性。

1.2.4 最大离散熵定理

表明在一定的约束条件下,离散熵的最大值出现在所有事件概率相等的情况。

1.3 离散互信息

离散互信息是衡量两个随机变量之间相互依赖程度的量,公式为I(X;Y) = H(X) - H(X|Y),表示在知道Y的情况下,X的信息减少了多少。互信息非负,并且只有在两个变量完全独立时才为0。

1.3.1 概念

互信息表示了通过观察一个变量可以减少对另一个变量不确定性的影响。

1.3.2 多变量情况下的互信息

在多变量情况下,可以定义联合互信息和条件互信息,来分析多个变量之间的相互依赖关系。

1.3.3 互信息函数的性质

互信息函数具有可加性、非负性以及信息增益的概念,这些性质有助于理解和应用互信息。

1.4 连续随机变量的熵和互信息

对于连续随机变量,熵被定义为随机变量的微分熵,它是概率密度函数的积分形式。而连续随机变量的互信息则涉及到概率密度函数的联合分布和条件分布。

1.4.1 随机变量微分熵

微分熵H(f(x)) = -∫ f(x) * log2(f(x)) dx,这里的f(x)是随机变量X的概率密度函数。

1.4.2 随机变量函数的微分熵

对于随机变量X的函数Y=g(X),其微分熵H(Y)可以通过X的微分熵和g(X)的性质来计算。

1.4.3 互信息

连续随机变量的互信息I(X;Y)同样表示它们之间的关联度,但计算方式与离散情况不同,涉及到联合概率密度函数和条件概率密度函数。

1.4.4 微分熵的变换不变性

微分熵在某些变换下保持不变,这体现了熵的相对不变性,使得我们可以在不同的坐标系或变量表示下讨论信息量。

总结来说,熵和互信息是信息论中两个关键的概念,它们不仅用于描述随机事件的不确定性,还揭示了变量间的相互依赖关系,对理解和设计通信系统、数据压缩、编码理论等领域至关重要。"

1169 浏览量

129 浏览量

723 浏览量

2021-07-06 上传

2022-09-24 上传

210 浏览量

158 浏览量

206 浏览量

761 浏览量

顾阑

- 粉丝: 23

最新资源

- Outlook最小化技巧:点击关闭按钮程序不退出

- 深入浅出Java搜索引擎的开发与源码解析

- 佳能IP系列机型清零工具的使用方法

- R-Studio:全格式数据恢复专家及网络功能拓展

- JFreeChart制作折线图实例教程

- 使用C++ MFC实现TWAIN接口图像采集技巧

- Android反编译三剑客:探索应用布局与源码

- vclskin 5.4版发布:安装无忧,性能升级

- SAP-I-Proteas电路模拟基础与操作指南

- 初学者指南:用Dreamweaver打造个性留言簿

- 移动通信缴费与业务系统开发教程

- Java快速解析Excel数据的封装方法

- 单片机实现的2路红外遥控器设计与应用

- 高效表排序与索引应用,优化plist文件数据管理

- 空心骑士作弊指南:快速提升游戏体验

- 阎石教授《数字电子技术基础》第五版课件