Hadoop YARN中MapReduce内存与CPU调度优化策略详解

需积分: 0 15 浏览量

更新于2024-08-04

1

收藏 604KB PDF 举报

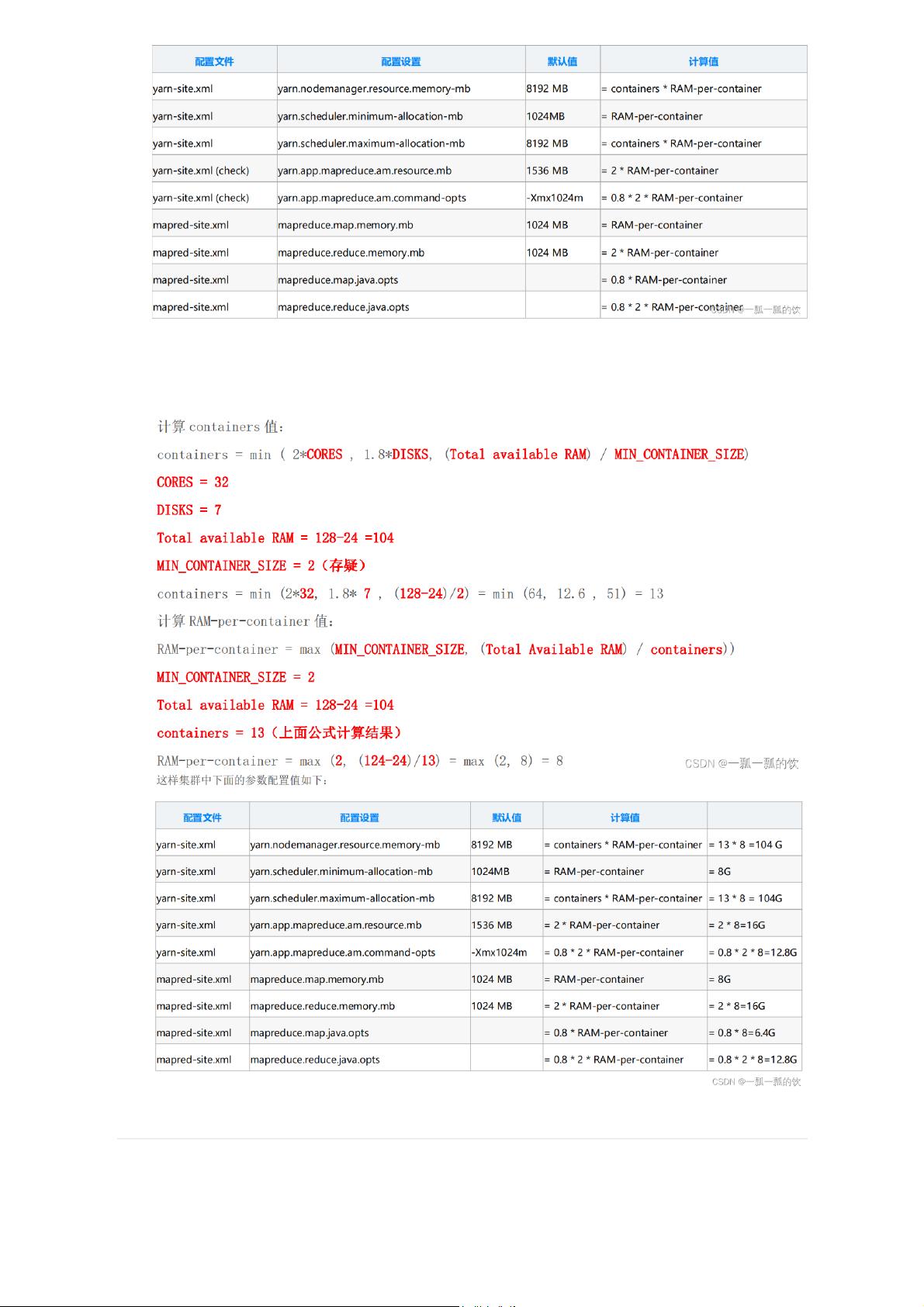

在Hadoop集群中,YARN作为资源调度器,负责管理和分配集群内的CPU和内存资源给MapReduce任务。本文详细讨论了在不使用默认参数的情况下,如何对YARN的CPU和内存进行配置,以优化MapReduce任务的性能和资源利用率。

首先,YARN通过Container作为资源分配的基本单位,每个Container包含固定数量的内存和CPU。为了保持集群资源平衡,推荐每两个Container共享一块磁盘和一个CPU核心。关键的配置参数包括:

1. `yarn.nodemanager.resource.memory-mb`:节点管理器的总内存大小。

2. `yarn.scheduler.minimum-allocation-mb`:最小的单个Container分配内存。

3. `yarn.scheduler.maximum-allocation-mb`:最大的单个Container分配内存。

4. `yarn.app.mapreduce.am.resource.mb`:MapReduce应用程序的Application Master(AM)所需的内存。

5. `yarn.app.mapreduce.am.command-opts`:AM命令选项,可能影响内存分配。

6. `mapreduce.map.memory.mb`:Mapper任务的内存限制。

7. `mapreduce.reduce.memory.mb`:Reducer任务的内存限制。

8. `mapreduce.map.java.opts` 和 `mapreduce.reduce.java.opts`:Java选项,影响内存使用。

文章提到两种内存配置方法:一是基于硬件资源的计算,这需要考虑机器的CPU核心数、磁盘数量和总内存,以合理地分配Container数量和单个Container内的内存。二是利用辅助工具,如Hortonworks提供的文档来指导内存设置,确保操作系统和Hadoop其他组件所需的内存都被扣除,剩余内存用于应用分配。

计算时需要确保不会造成资源浪费或因配置不当导致系统不稳定。即使采用这两种方法,最终结果可能会有所不同,因为它们关注的是资源分配的合理性而不是绝对值。因此,根据实际情况和需求调整这些参数至关重要,以达到最优的性能和资源利用效率。

2022-08-03 上传

2015-10-26 上传

2021-01-20 上传

2017-04-01 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

一瓢一瓢的饮alanchanchn

- 粉丝: 8232

- 资源: 69

最新资源

- boutique_ado_v1

- vb酒店管理信息系统设计(论文+源代码).rar

- archive:工作正在进行中

- Angular-Authorization:角度授权

- Scratch少儿编程项目音效音乐素材-【电】相关音效.zip

- CommissionCalc3:Java1周4

- react-navbar-example:示例navbar

- photosheet:相片纸生成器

- scoreboardapp

- release,大富翁c语言源码,c语言项目

- 计算器

- FE-Hot-Diggety-Dog

- 蒙特卡洛法求椭圆面积的MATLAB源程序代码.rar

- Scratch少儿编程项目音效音乐素材-【按钮开关类】音效.zip

- thextedit-开源

- CactiPhone:一个用于智能手机的简单仙人掌查看器-开源

已收录资源合集

已收录资源合集