深入浅出:支持向量机(SVM)解析

需积分: 9 103 浏览量

更新于2024-07-23

1

收藏 1.22MB PDF 举报

"这篇超详细的支持向量机入门文章提供了SVM的基本概念和理论背景,适合初学者了解和支持向量机的应用。"

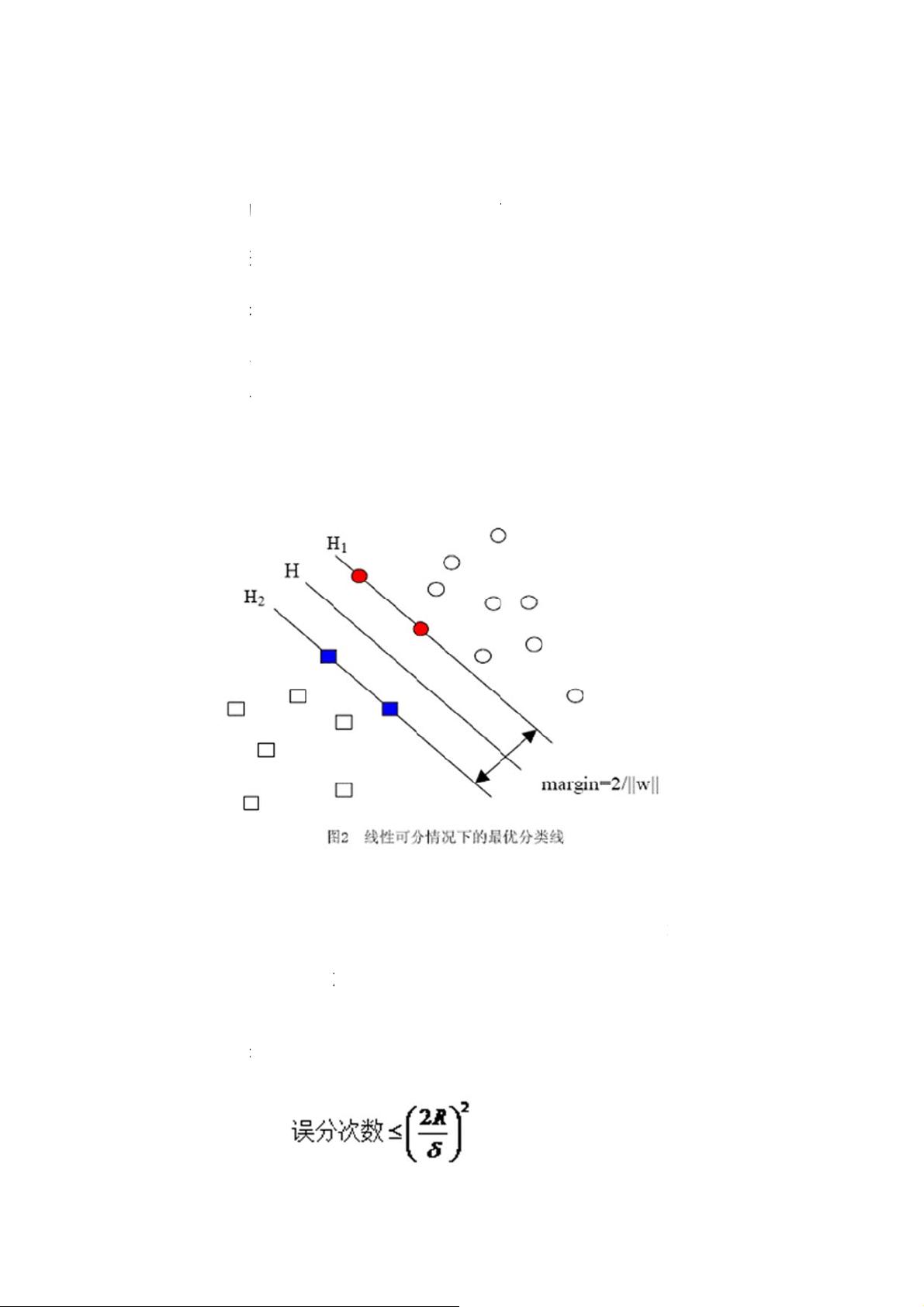

支持向量机(Support Vector Machine,简称SVM)是一种强大的监督学习算法,由Cortes和Vapnik在1995年提出。它在小样本、非线性及高维数据的分类和回归任务中展现出优秀的性能。SVM的核心思想是通过找到最优的决策边界,最大化类别间的间隔,从而提高模型的泛化能力。

SVM的理论基础源于统计学习理论,特别是Vapnik-Chervonenkis(VC)维理论和结构风险最小化原理。VC维是衡量一个函数类复杂性的指标,高VC维意味着模型可能过于复杂,容易过拟合;而低VC维则可能导致模型过于简单,欠拟合。SVM的目标是在复杂性和学习能力之间找到平衡,以获得最佳的推广能力。

结构风险最小化是指在训练过程中,不仅考虑在现有样本上的学习精度,还要考虑模型对未知样本的预测能力。它强调在有限样本下,选择使期望错误率最小的模型,而不是仅仅追求训练集上的准确率。这样可以防止模型过于拟合训练数据,从而提高对新数据的预测性能。

在实际应用中,SVM的一个显著特点是可以处理高维数据,即使数据维度非常高,也能有效地找到合适的决策边界。这得益于引入了核函数的概念。核函数能够将原始数据映射到高维空间,在高维空间中寻找线性可分的超平面,而在原始空间中可能是非线性的。常用的核函数有线性核、多项式核、RBF(高斯核)等,它们能够帮助SVM处理非线性问题。

SVM在文本分类、图像识别、生物信息学等领域有广泛应用。例如,在文本分类中,每个文档可以被表示为词频向量,维度可能非常高,但SVM仍然能有效地处理这种高维数据,找出最佳分类边界。

SVM通过寻找最大间隔的决策边界,结合核函数和统计学习理论,提供了一种有效且具有强大泛化能力的分类和回归工具。对于初学者来说,理解和掌握SVM的基本原理和实现方法,是深入学习机器学习领域的重要一步。

2010-01-05 上传

575 浏览量

2023-09-09 上传

2023-05-14 上传

2023-06-09 上传

2023-10-24 上传

2023-12-29 上传

2023-11-16 上传

2024-10-13 上传

妖孽横生

- 粉丝: 33

- 资源: 133

最新资源

- 天池大数据比赛:伪造人脸图像检测技术

- ADS1118数据手册中英文版合集

- Laravel 4/5包增强Eloquent模型本地化功能

- UCOSII 2.91版成功移植至STM8L平台

- 蓝色细线风格的PPT鱼骨图设计

- 基于Python的抖音舆情数据可视化分析系统

- C语言双人版游戏设计:别踩白块儿

- 创新色彩搭配的PPT鱼骨图设计展示

- SPICE公共代码库:综合资源管理

- 大气蓝灰配色PPT鱼骨图设计技巧

- 绿色风格四原因分析PPT鱼骨图设计

- 恺撒密码:古老而经典的替换加密技术解析

- C语言超市管理系统课程设计详细解析

- 深入分析:黑色因素的PPT鱼骨图应用

- 创新彩色圆点PPT鱼骨图制作与分析

- C语言课程设计:吃逗游戏源码分享