Spark基础:窄依赖、宽依赖与DAG解析

150 浏览量

更新于2024-08-29

收藏 363KB PDF 举报

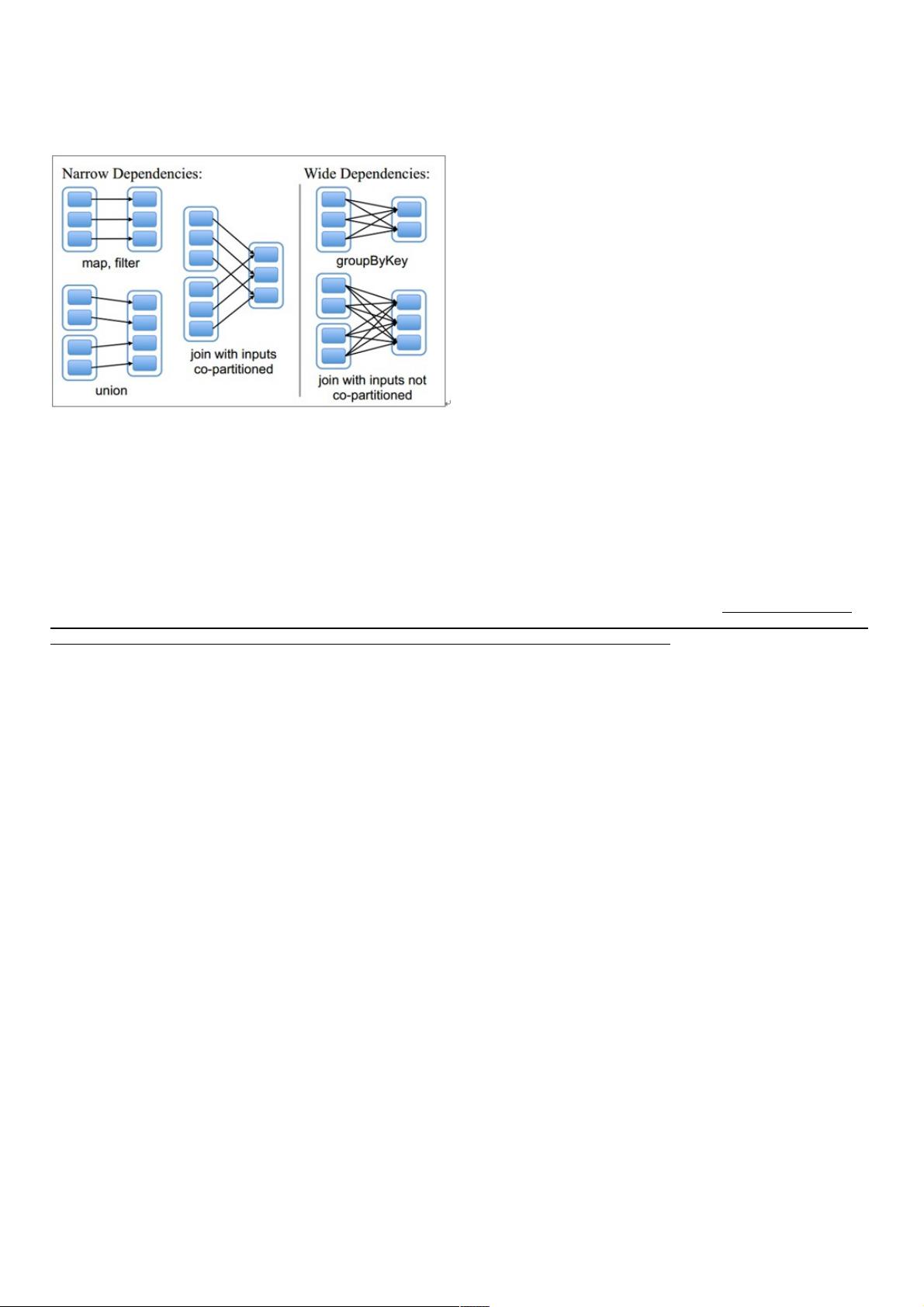

Spark是大数据处理领域的一款高效计算框架,其核心概念之一是弹性分布式数据集(RDD),而RDD之间的依赖关系是Spark优化任务执行的关键。本篇将详细阐述Spark中的窄依赖、宽依赖以及DAG(有向无环图)的概念,并探讨它们在优化计算过程中的作用。

窄依赖是Spark中的一种优化策略,它确保每个父RDD的分区最多只被一个子RDD的分区所用。这种依赖关系允许Spark并行处理数据,因为各个分区之间没有相互依赖,可以独立计算。例如,map算子就创建了窄依赖,因为它不会改变数据分区的分布。窄依赖可以有效地利用计算资源,提高执行效率,因为它允许Spark在单个Stage内完成所有操作,从而减少数据传输和磁盘I/O。

宽依赖则与窄依赖相反,一个父RDD的分区可能被多个子RDD的分区所依赖。这种情况通常发生在需要重新分区或混洗数据的操作中,如reduceByKey、groupByKey等。由于数据需要在不同分区间重新分布,这会导致数据shuffle,增加网络传输和磁盘I/O负担。宽依赖是划分Stage的界限,因为它强制Spark在处理完所有父Stage后才能开始新的Stage。

DAG(有向无环图)是Spark作业的抽象表示,由RDD及其依赖关系构成。RDD之间的依赖关系决定了DAG的结构,进而影响到任务的执行顺序。在DAG中,窄依赖可以被优化为在一个Stage内完成,而宽依赖会强制划分Stage,每个Stage代表一次计算的逻辑单元。Stage划分的目标是最大限度地减少shuffle操作,因为shuffle会带来额外的性能开销。

在DAG的构建过程中,Spark会分析RDD的依赖关系,尝试将窄依赖尽可能地合并到一个Stage,以减少Stage的数量和shuffle次数。宽依赖是划分Stage的主要依据,因为它们涉及的数据交换通常需要跨机器进行,所以必须等待前一个Stage的所有任务完成才能继续。

在Spark中,缓存机制也是提高性能的重要手段。RDD可以通过cache()或persist()方法进行持久化,将中间结果存储在内存或磁盘上,避免重复计算,提升整体处理速度。缓存策略的选择应考虑数据大小、内存可用性及任务执行模式等因素。

理解Spark中的窄依赖、宽依赖和DAG对于优化Spark应用至关重要。掌握这些概念有助于开发者设计高效的计算流程,减少数据shuffle,提高数据处理的并行性和效率。同时,合理利用缓存机制也能显著提升Spark应用的性能。在开发Spark应用时,应该尽可能地设计出包含更多窄依赖的计算图,以优化DAG的执行流程。

3777 浏览量

2020-03-30 上传

158 浏览量

点击了解资源详情

C2000,28335Matlab Simulink代码生成技术,处理器在环,里面有电力电子常用的GPIO,PWM,ADC,DMA,定时器中断等各种电力电子工程师常用的模块儿,只需要有想法剩下的全部自

1640 浏览量

2025-01-04 上传

2025-01-04 上传

weixin_38639089

- 粉丝: 3

- 资源: 884