CNN中的Pooling层:反向传播与作用解析

需积分: 0 146 浏览量

更新于2024-08-05

收藏 1.26MB PDF 举报

"08_Pooling层的作用以及如何进行反向传播1"

在卷积神经网络(CNN)中,Pooling层扮演着至关重要的角色。它主要用于处理图像特征,提高模型的性能和效率。本篇文章主要探讨了Pooling层的两种常见类型——Average Pooling和Max Pooling,以及它们在反向传播过程中的实现方式。

1. **Pooling层的反向传播**

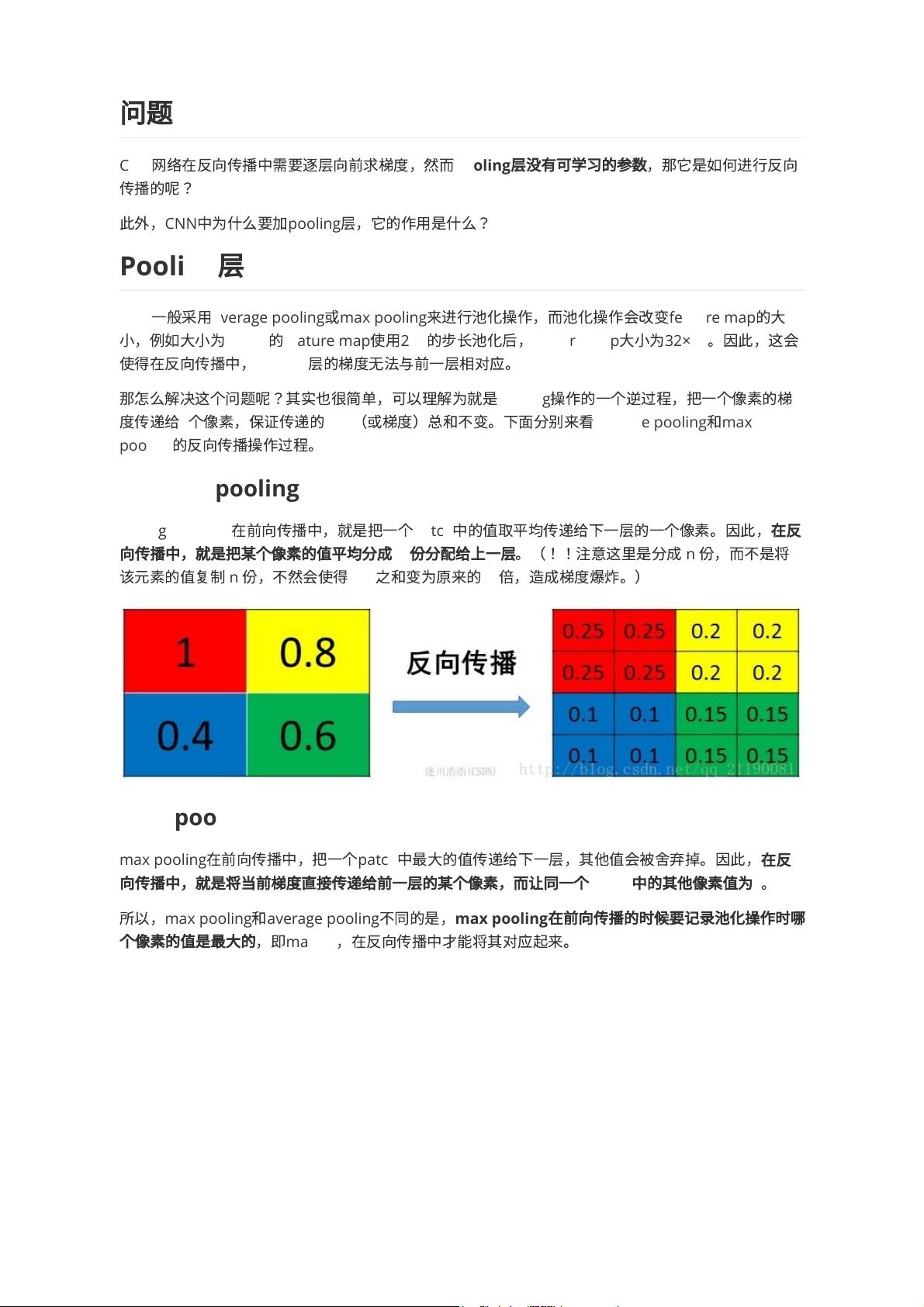

在反向传播过程中,由于Pooling层没有可学习的参数,因此其梯度传播的方式与传统全连接层或卷积层不同。对于Average Pooling,前向传播时对一个patch内的所有像素取平均值,反向传播时则将当前像素的梯度平均分配给上一层对应的n个像素,以保持损失函数的总和不变。而Max Pooling则是在前向传播时保留最大值,反向传播时仅将梯度传回给最大值所在的像素,其他像素梯度设为0。Max Pooling还需要在前向传播时记录最大值的位置(max_id),以便反向传播时正确对应。

2. **Pooling层的作用**

- **增加非线性**:Pooling层引入了一种局部非线性变换,增强了网络的学习能力,有助于提取更复杂的特征。

- **降低维度和减少计算量**:通过缩小feature map的尺寸,Pooling层减少了参数数量,降低了模型复杂度,同时减小了计算量,提升了训练速度。

- **防止过拟合,提高泛化能力**:通过减少特征的数目,Pooling层有助于减轻模型对训练数据的过度依赖,提高模型对新样本的泛化能力。

- **不变性**:Pooling层提供了平移(translation)、旋转(rotation)和尺度(scale)等不变性。例如,通过Max Pooling,即使输入图像发生微小移动,关键特征仍能被捕捉,从而增强了模型的鲁棒性。

3. **Translation Invariance**

Translation invariance是Pooling层的一个关键特性,意味着模型对输入图像的小范围平移不敏感。这对于图像识别任务特别有用,因为实际图像可能会有轻微的位移。

Pooling层是CNN中不可或缺的一部分,它通过简化特征并提供一定的不变性,提高了模型的性能和泛化能力。在反向传播时,它通过特定的规则将误差传递回上一层,确保了整个网络的正常训练。了解和正确应用Pooling层对于理解和构建高效CNN模型至关重要。

2022-07-25 上传

2020-02-07 上传

2019-08-11 上传

2023-05-15 上传

2021-03-13 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

南小鹏

- 粉丝: 38

- 资源: 289

最新资源

- 单片机串口通信仿真与代码实现详解

- LVGL GUI-Guider工具:设计并仿真LVGL界面

- Unity3D魔幻风格游戏UI界面与按钮图标素材详解

- MFC VC++实现串口温度数据显示源代码分析

- JEE培训项目:jee-todolist深度解析

- 74LS138译码器在单片机应用中的实现方法

- Android平台的动物象棋游戏应用开发

- C++系统测试项目:毕业设计与课程实践指南

- WZYAVPlayer:一个适用于iOS的视频播放控件

- ASP实现校园学生信息在线管理系统设计与实践

- 使用node-webkit和AngularJS打造跨平台桌面应用

- C#实现递归绘制圆形的探索

- C++语言项目开发:烟花效果动画实现

- 高效子网掩码计算器:网络工具中的必备应用

- 用Django构建个人博客网站的学习之旅

- SpringBoot微服务搭建与Spring Cloud实践