Hadoop入门与核心组件解析

需积分: 10 95 浏览量

更新于2024-07-09

收藏 5.09MB DOCX 举报

"这是关于Hadoop的基础知识文档,涵盖了Hadoop的历史、功能、优势、相关工具、版本、安装、HDFS的基本概念和策略以及MapReduce原理和实例。"

Hadoop是因谷歌提出的三大数据技术(包括GFS、MapReduce和BigTable)而诞生的开源实现,由Apache基金会作为顶级项目进行维护。Hadoop的核心组件包括分布式文件系统HDFS(Hadoop Distributed File System)和分布式计算框架MapReduce,它为企业提供了处理和存储海量数据的能力。

Hadoop的优势在于其高可扩展性,可以通过添加更多节点来扩展存储和计算能力;低成本,因为它主要依赖于廉价的硬件;以及成熟的生态圈,如Hive和HBase等工具,使得大数据处理更加便利。Hadoop不仅创造了大量的开发和运维职位,还催生了各种围绕Hadoop的开源工具。

Hive是基于Hadoop的数据仓库工具,允许用户使用SQL-like语言查询和管理大数据,将复杂的MapReduce作业转换为更简单的SQL语句。HBase则是一个分布式、列式存储的NoSQL数据库,与传统关系型数据库不同,它放弃了事务支持,但提供了更高的扩展性和实时访问性能。

Zookeeper是Hadoop集群中的协调服务,用于监控节点状态,确保数据一致性,是整个Hadoop生态系统中的关键组件。

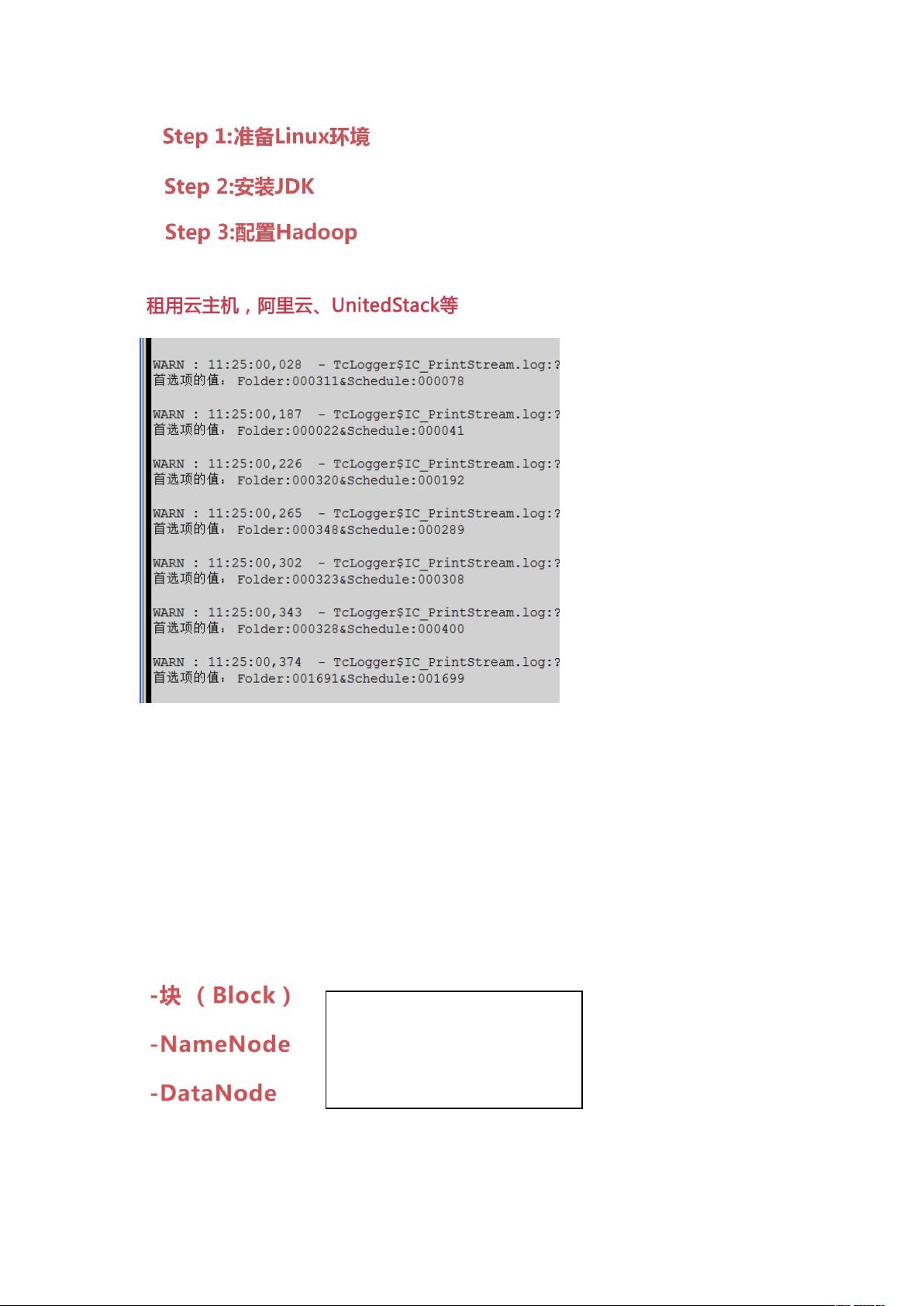

Hadoop的版本更新不断,提供了更多的优化和新功能。安装Hadoop通常需要Linux环境,云主机提供了一种便捷的方式。HDFS作为Hadoop的主要存储系统,有三个基本概念:名称节点(NameNode)、数据节点(DataNode)和客户端。它的数据管理策略包括数据块的备份、心跳检测和二级NameNode,确保数据的可靠性和高可用性。

HDFS的读写流程包括客户端向NameNode请求文件位置,然后从DataNodes读取或写入数据块。HDFS的特点包括数据的冗余备份、容错能力和适合大规模数据处理的特性。

MapReduce是Hadoop的并行计算模型,一个Job被分解为多个Map任务和Reduce任务,由JobTracker调度,TaskTracker执行。Map阶段对数据进行局部处理,Reduce阶段聚合结果。MapReduce通过排序确保数据处理的正确性。

例如,经典的WordCount程序展示了MapReduce的基本用法,用于统计文本中单词出现的次数。在Map阶段,单词被提取并分组;在Reduce阶段,每个单词的计数值被汇总。这种排序和分组的过程是MapReduce的核心操作。

Hadoop提供了从数据存储到数据分析的全面解决方案,是大数据处理领域的重要工具,其生态系统不断发展,支持着各种大数据应用场景。

2021-06-23 上传

2020-10-10 上传

2021-11-26 上传

2024-06-21 上传

2021-05-24 上传

不小竞

- 粉丝: 48

- 资源: 9