支持向量机(SVM)原理与应用解析

需积分: 5 78 浏览量

更新于2024-06-30

收藏 2.92MB PPTX 举报

支持向量机(SVM)是一种强大的监督学习算法,主要用于分类和回归任务,尤其是处理小样本数据时表现优秀。它的核心思想是找到一个最优的超平面,将不同类别的样本分开,同时最大化分类边界(间隔)。

在硬间隔支持向量机中,目标是寻找一个能完全分离两类样本的超平面,确保所有样本都正确分类。超平面由法向量w和位移b定义,而距离超平面最近的样本点被称为支持向量。对于一个线性可分的训练集,SVM通过最大化这两个最接近超平面的样本点到超平面的距离来确定超平面。这个距离是通过计算样本点与超平面的几何距离得到的,即|w·x - b| / ||w||。在优化过程中,目标是最小化w的范数,以最大化间隔,同时保持所有样本都在正确的一侧。

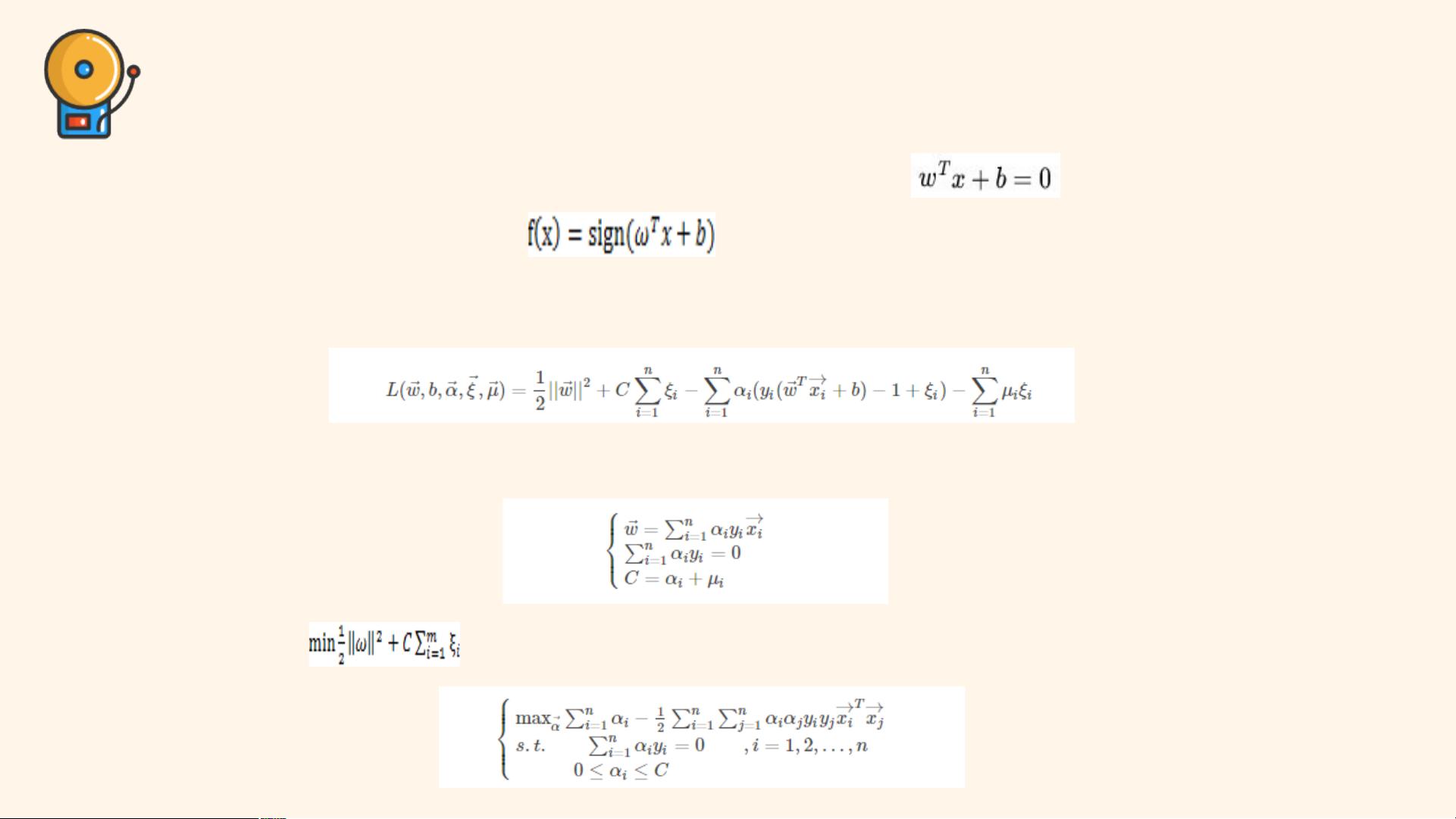

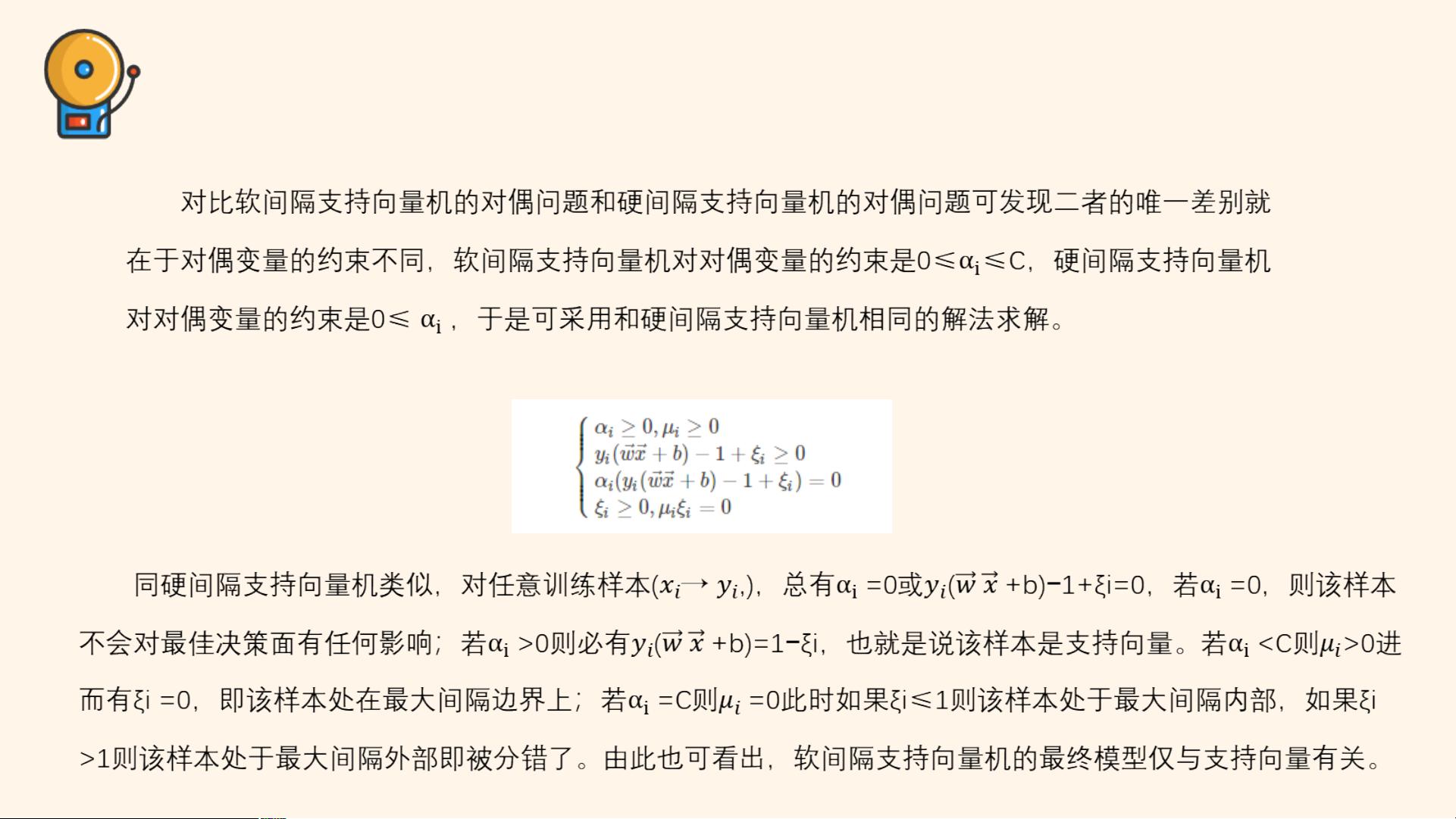

然而,真实世界的数据往往不是线性可分的,这就引出了软间隔支持向量机。在软间隔中,允许一部分样本点(尤其是噪声或异常值)被错误分类,通过引入惩罚参数C,控制对误分类的容忍程度。C越大,对误分类的惩罚越大,模型更倾向于找到一个能正确分类大多数样本的超平面;C越小,模型可能选择一个更宽容的超平面,允许更多样本被误分类。软间隔的支持向量机通过在原始优化问题中加入松弛变量ξ,以量化每个样本的误分类程度,从而解决了非线性可分问题。

当面对非线性问题时,SVM采用核函数(如高斯核、多项式核、sigmoid核等)进行非线性映射,将低维的非线性可分数据映射到高维空间,使得在高维空间中数据变得线性可分。核函数的选择直接影响模型的性能,高斯核(RBF)是最常用的一种,因为它能处理大多数非线性问题,且通常表现出良好的泛化能力。

在求解SVM模型时,通常使用拉格朗日乘子法和Karush-Kuhn-Tucker (KKT) 条件。通过构建拉格朗日函数,将原始优化问题转化为无约束优化问题,然后求解出拉格朗日乘子α,进而求得权重向量w和位移b。对于软间隔,KKT条件要求拉格朗日乘子α_i与松弛变量ξ_i的关系满足特定条件,以及α_i对应的支持向量必须满足某些特定性质。

SVM是一种通过优化间隔并利用核函数处理非线性问题的机器学习算法。其灵活性和泛化能力使其在许多实际应用中表现出色,包括文本分类、生物信息学、图像识别等领域。通过调整参数C和选择合适的核函数,可以有效地适应不同的数据集和任务需求。

2022-10-19 上传

2023-05-12 上传

2023-10-20 上传

2023-06-06 上传

2023-09-25 上传

2023-12-24 上传

2023-09-05 上传

李逍遥敲代码

- 粉丝: 2997

- 资源: 277

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升