音乐转录模型深度解析:LSTM与char-rnn/folk-rnn实践

需积分: 0 85 浏览量

更新于2024-08-04

收藏 550KB DOCX 举报

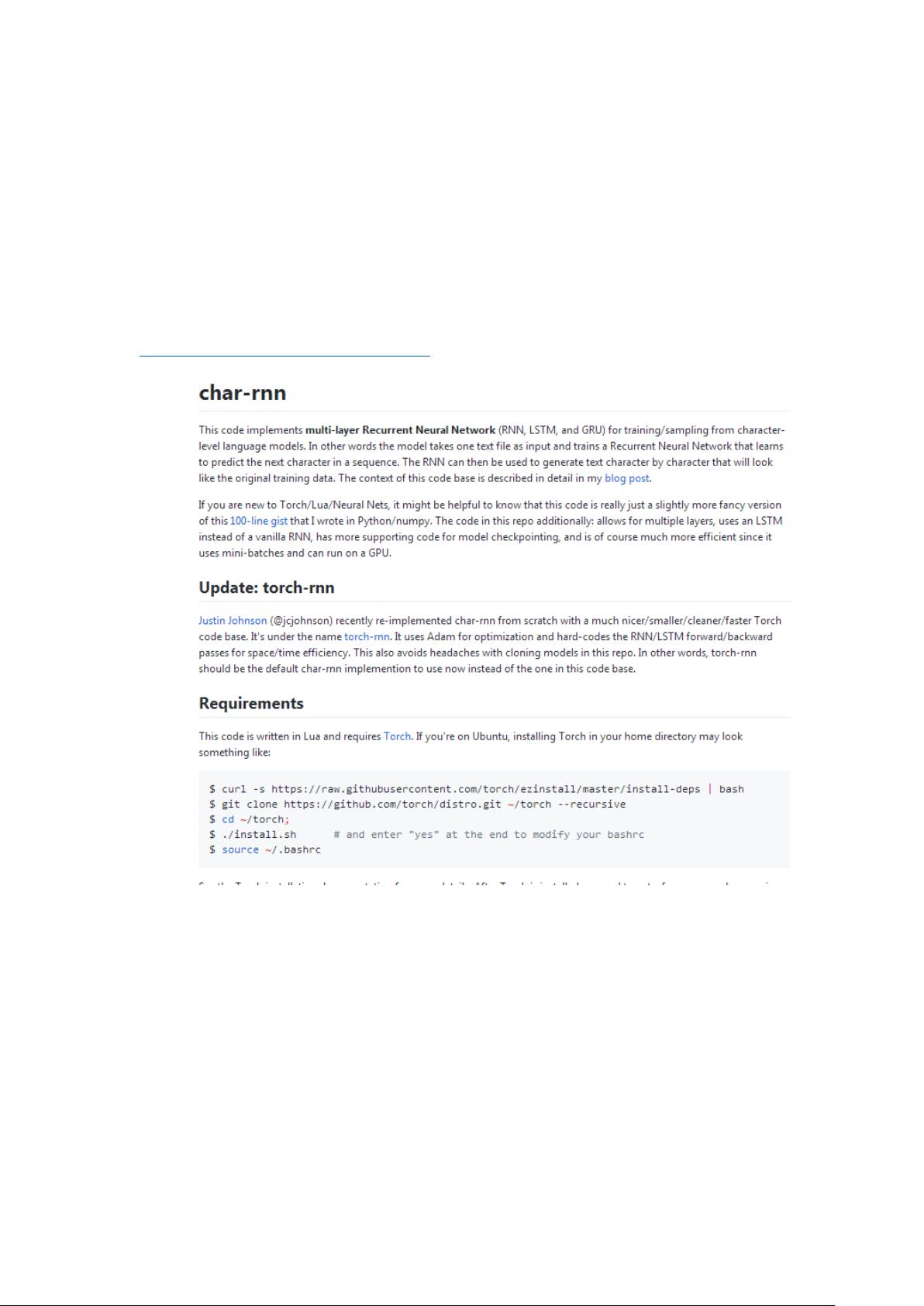

本周的IT周报主要围绕一篇关于使用LSTM进行音乐转录建模和合成的论文进行深入解析。该论文的重点在于如何利用长短期记忆(LSTM)网络构建音乐转录模型,以适应音乐组合的特定语境。作者构建了两种类型的模型:char-rnn和folk-rnn。

char-rnn模型基于单个字符的词汇表,训练在连续的文本文件上,采用了ABC记谱法,共处理大约23000个文本词汇。模型的网络结构包含3个隐藏层,每层有512个LSTM模块,其输入数据经过筛选,仅保留了标题、表、键、单元注释长度和抄写等5个字段,以减少噪声。这个模型的输入文本长度达到了13515723个字符,共135种独特的字符。

相比之下,folk-rnn模型则在完整的转录上运行,数据处理更为精细。作者从原始数据中删除冗余,清洗后得到4056459个记号,包括音高、持续时间和度量等,总共有137种不同的记号类型。folk-rnn模型的训练数据更加聚焦于音乐本身的结构。

在模型构建过程中,作者借助了char-rnn项目的Python代码作为参考,学习了TensorFlow的基础知识,其中包括神经网络过程的可视化方法以及Optimizer优化器的应用。通过这些学习,作者得以更深入地理解模型的构建和训练流程。

这份周报不仅涵盖了论文的核心内容,还结合实际编程实践,展示了如何将理论知识转化为实际操作,以及如何通过TensorFlow这样的工具进行模型的训练和优化。这对于理解和应用深度学习在音乐领域具有重要的价值。

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2023-05-11 上传

2023-05-12 上传

2023-03-28 上传

2023-03-29 上传

2023-05-10 上传

2022-08-08 上传

懂得越多越要学

- 粉丝: 23

- 资源: 307

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景