手把手教你搭建Hadoop集群:Intel Hadoop 2.5在CentOS上的实战

需积分: 9 131 浏览量

更新于2024-07-21

收藏 2.53MB DOC 举报

"本文介绍了在Intel Hadoop 2.5发行版下,在CentOS 6.3 64位系统上搭建Hadoop服务器集群的详细步骤,适用于新手学习Hadoop大数据环境的搭建。"

搭建Hadoop服务器集群是学习大数据处理技术的基础,这个过程包括配置硬件环境、设置网络连接、配置本地YUM源以及安装和配置Hadoop组件。以下是详细的步骤:

1. **集群硬件环境**:

- 需要至少3台计算机或虚拟机,确保它们运行64位的CentOS 6.3或64位的CentOS 6.4系统。

- 建议每台机器至少拥有2GB内存和20GB硬盘空间。

- 示例配置:1台主节点(如virtualpc-01)具有8GB内存,30GB硬盘和I5 CPU;另外2台数据节点(如virtualpc-02和virtualpc-03)各4GB内存,30GB硬盘,I5 CPU。

2. **网络配置**:

- 所有机器需在同一局域网内,使用`vi /etc/sysconfig/network-scripts/ifcfg-eth0`编辑网卡配置文件,根据实际情况设置IPADDR,例如设置为"192.168.0.101"。

- 启动网卡服务:`# service network start` 或者重启单个网卡:`# ifconfig eth0 up` 和 `# ifconfig eth0 down`。

- 使用`# ifconfig`命令检查网络配置,并通过`# ping`命令测试与网关的连通性。

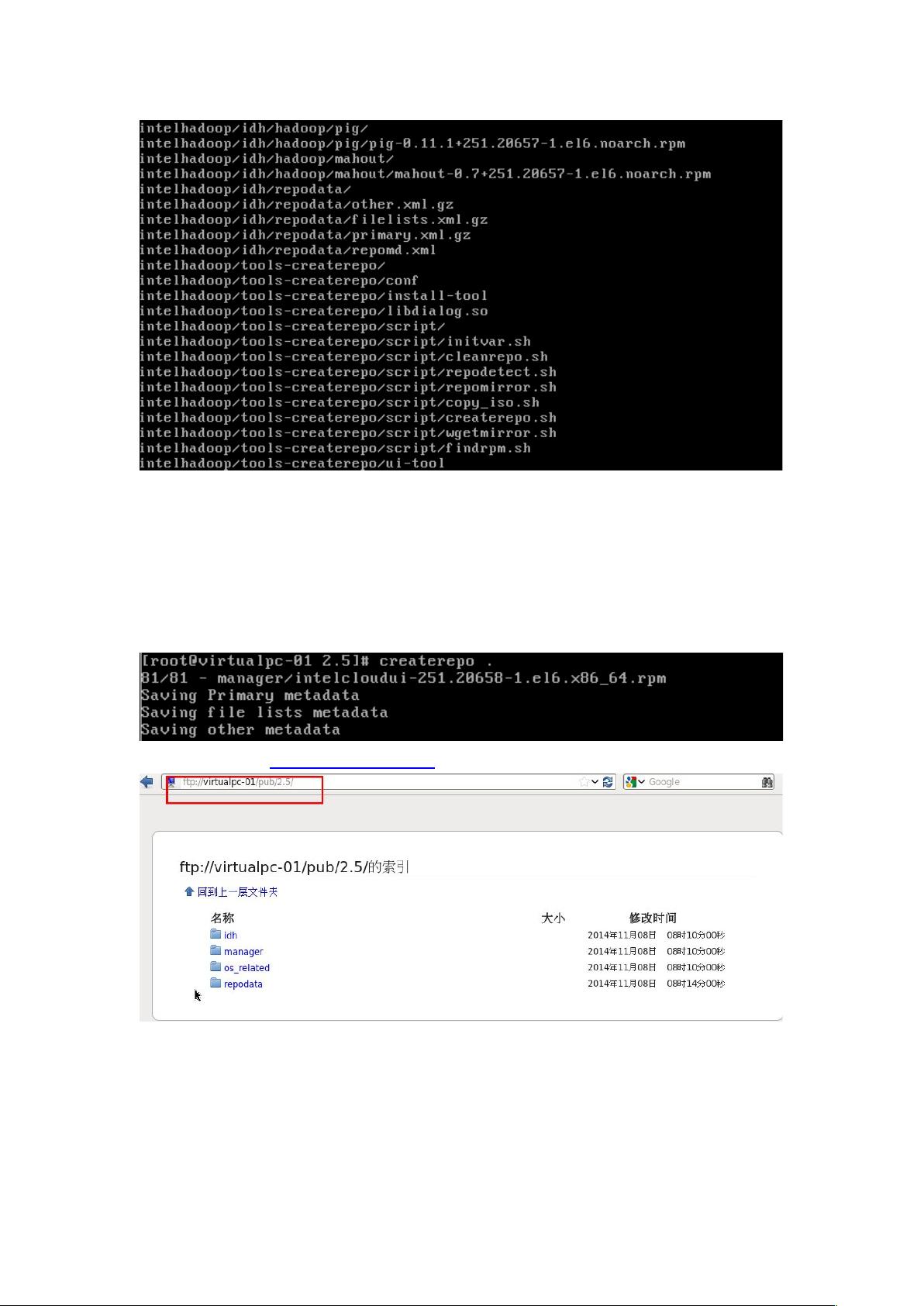

3. **配置本地YUM源**:

- 在任意一台机器(如virtualpc-01)上安装FTP服务器,以便在没有网络连接时安装必要的软件。

- 使用CentOS 6.3 64位系统镜像中的yum源文件,将其挂载到FTP服务器,并将所有内容复制出来。

4. **安装和配置Hadoop**:

- 首先,通过配置好的YUM源安装Java开发工具包(JDK),因为Hadoop依赖Java运行环境。

- 下载Intel Hadoop 2.5发行版,并解压到合适的位置。

- 配置Hadoop环境变量,包括`JAVA_HOME`、`HADOOP_HOME`、`PATH`等,在`~/.bashrc`或`/etc/profile`文件中添加相关路径。

- 修改Hadoop配置文件,如`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`和`mapred-site.xml`,配置HDFS和MapReduce的相关参数,如NameNode和DataNode的地址、内存分配等。

- 初始化HDFS文件系统:`hadoop namenode -format`。

- 启动Hadoop服务,包括NameNode、DataNode、SecondaryNameNode、ResourceManager和NodeManager等。

- 测试Hadoop集群的健康状态,如`jps`命令查看各进程是否正常运行,`hadoop fs -ls`检查HDFS是否可用。

5. **集群验证**:

- 使用`hadoop dfs -put`命令上传文件到HDFS,然后使用`hadoop dfs -get`下载验证。

- 运行一个简单的MapReduce示例,如WordCount,观察集群是否正确处理任务。

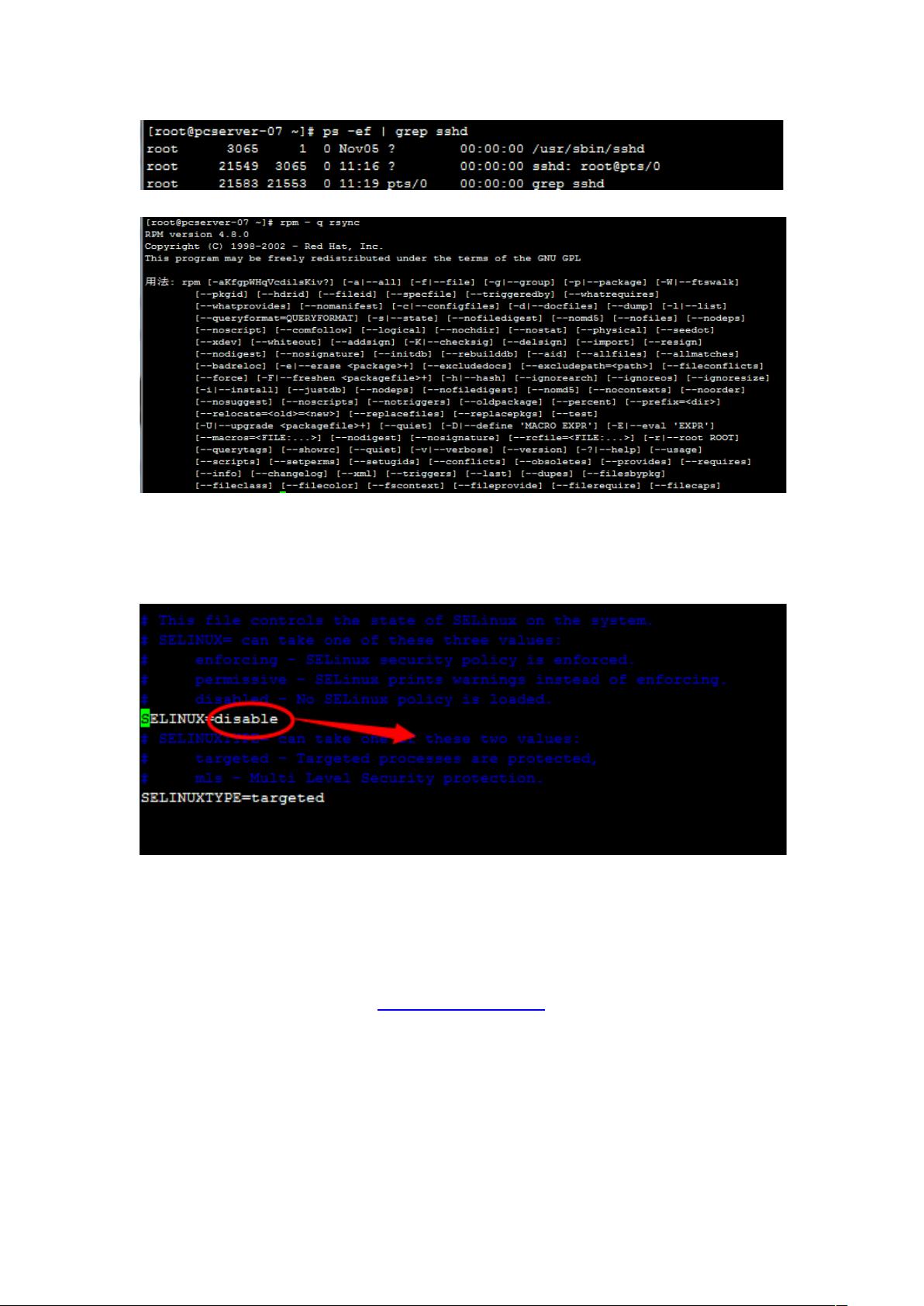

6. **安全性和优化**:

- 考虑实施Hadoop的安全模式,如Kerberos认证,以增加集群安全性。

- 根据实际硬件资源和工作负载调整Hadoop配置,如Block大小、副本数量、内存分配等,以优化性能。

通过以上步骤,新手可以逐步构建一个基本的Hadoop集群,为后续的大数据学习和实践提供实验环境。记得在操作过程中遇到问题时,查阅官方文档、社区论坛和教程,寻求解决方案。

2015-12-20 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

许你有bug

- 粉丝: 0

- 资源: 1

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析