二分类模型评价指标详解:准确率、查准率与ROC曲线

需积分: 9 48 浏览量

更新于2024-09-09

收藏 168KB DOCX 举报

"二分类学习评价指标"

二分类学习是机器学习中常见的一类问题,其目标是将数据分为两类。对于二分类模型的评估,有许多关键的指标用于衡量模型的性能。这些指标有助于我们理解模型在真实世界情境中的表现,并帮助我们在训练过程中做出优化决策。

1. 准确度和精度的指标:

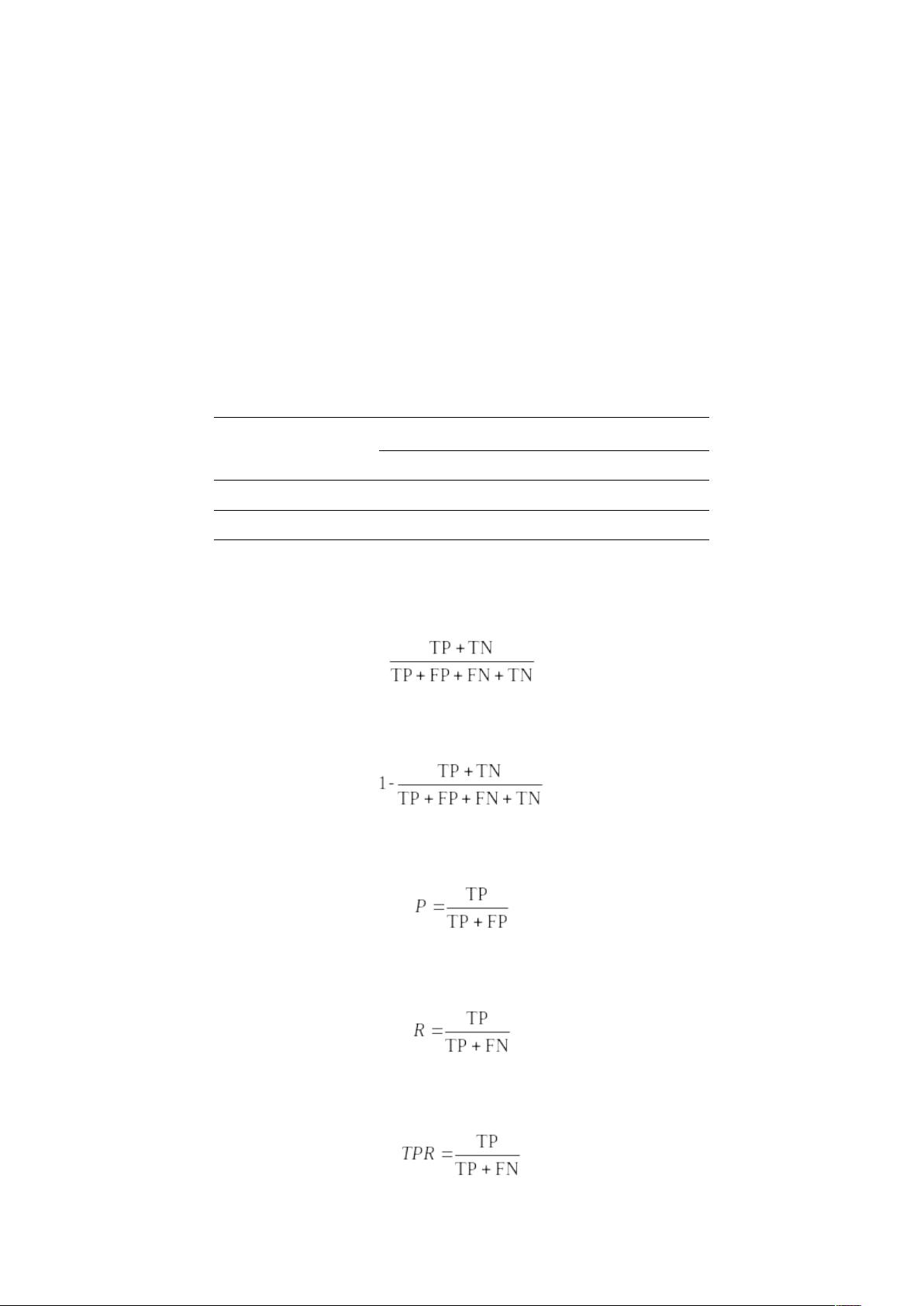

- **准确率**(Accuracy):模型正确预测的比例,计算公式为 `(TP + TN) / (TP + TN + FP + FN)`。

- **错误率**(Error Rate):模型错误预测的比例,即1减去准确率。

- **查准率**(Precision):精确度,计算公式为 `TP / (TP + FP)`,表示预测为正例中实际为正例的比例。

- **查全率**(Recall):召回率,计算公式为 `TP / (TP + FN)`,表示所有实际正例中被预测出来的比例。

- **真正率**(True Positive Rate, TPR):同召回率,计算公式为 `TP / (TP + FN)`。

- **假正率**(False Positive Rate, FPR):计算公式为 `FP / (FP + TN)`,表示预测为正例但实际为负例的比例。

2. **F1分数**(F1 Score):

F1分数是查准率和查全率的调和平均数,当两者权重相等时,公式为 `2 * Precision * Recall / (Precision + Recall)`。它综合考虑了查准率和查全率,尤其适用于两类样本数量不均衡的情况。

3. **ROC曲线**(Receiver Operating Characteristic Curve):

ROC曲线描绘了改变分类阈值时真正率与假正率的关系。每个点对应一个阈值,展示了模型在该阈值下的真正率和假正率。

- **AUC**(Area Under the ROC Curve):ROC曲线下的面积,是衡量模型性能的一个重要指标。AUC越大,模型性能越好,AUC=1表示完美模型,AUC=0.5表示随机猜测。

- **EER**(Equal Error Rate):当FPR等于TPR时的点,表示模型对正负样本的误分类率相同。

这些指标在不同的应用场景下有不同的侧重。例如,在医疗诊断中,可能更重视高召回率(减少漏诊),而在垃圾邮件过滤中,可能更关注高查准率(减少误报)。根据具体需求,可以通过调整`β`值的`F-beta`分数来平衡查准率和查全率。

了解并正确使用这些评价指标对于优化和选择合适的二分类模型至关重要。它们可以帮助我们识别模型的优势和弱点,从而指导特征工程、模型选择或超参数调优。同时,对于多分类问题,可以采用类似的扩展指标,如宏平均(宏F1)、微平均(微F1)等来评估模型的整体性能。

2022-03-14 上传

2018-05-26 上传

2022-08-04 上传

2024-06-22 上传

点击了解资源详情

2023-05-17 上传

2024-06-23 上传

2023-05-31 上传

2忽悠

- 粉丝: 7

- 资源: 6

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能