线性代数解析:矩阵变换与特征值特征向量

需积分: 50 2 浏览量

更新于2024-07-18

1

收藏 78.25MB DOCX 举报

"这篇线性代数笔记详细探讨了矩阵变换的几何解释,以及矩阵分解的几何意义。它强调了对角矩阵、三角矩阵和正交矩阵在几何变换中的作用,同时也介绍了矩阵特征值和特征向量的概念。"

在机器学习和数据科学中,线性代数是不可或缺的基础。这篇笔记首先解释了为何要将矩阵分解为因子矩阵,特别是对角矩阵、三角矩阵和正交矩阵。对角矩阵的乘法相当于对坐标轴进行独立缩放,其中正数表示伸长,负数表示反向缩放,而零则表示空间压缩。三角矩阵,包括上三角和下三角,引入了切变效果,分别表现为右上角的斜拉和左下角的斜推。正交矩阵则保持物体形状不变,仅进行旋转。

接着,笔记阐述了矩阵分解的几何意义,如LU、LDU、LL、LDL分解及QR、SVD分解,这些分解方法将矩阵作用分解为一系列简单的几何变换。例如,LU和LL分解主要处理三角矩阵,而QR和SVD分解涉及正交矩阵和对角矩阵。这种分解有助于理解和简化复杂的矩阵运算。

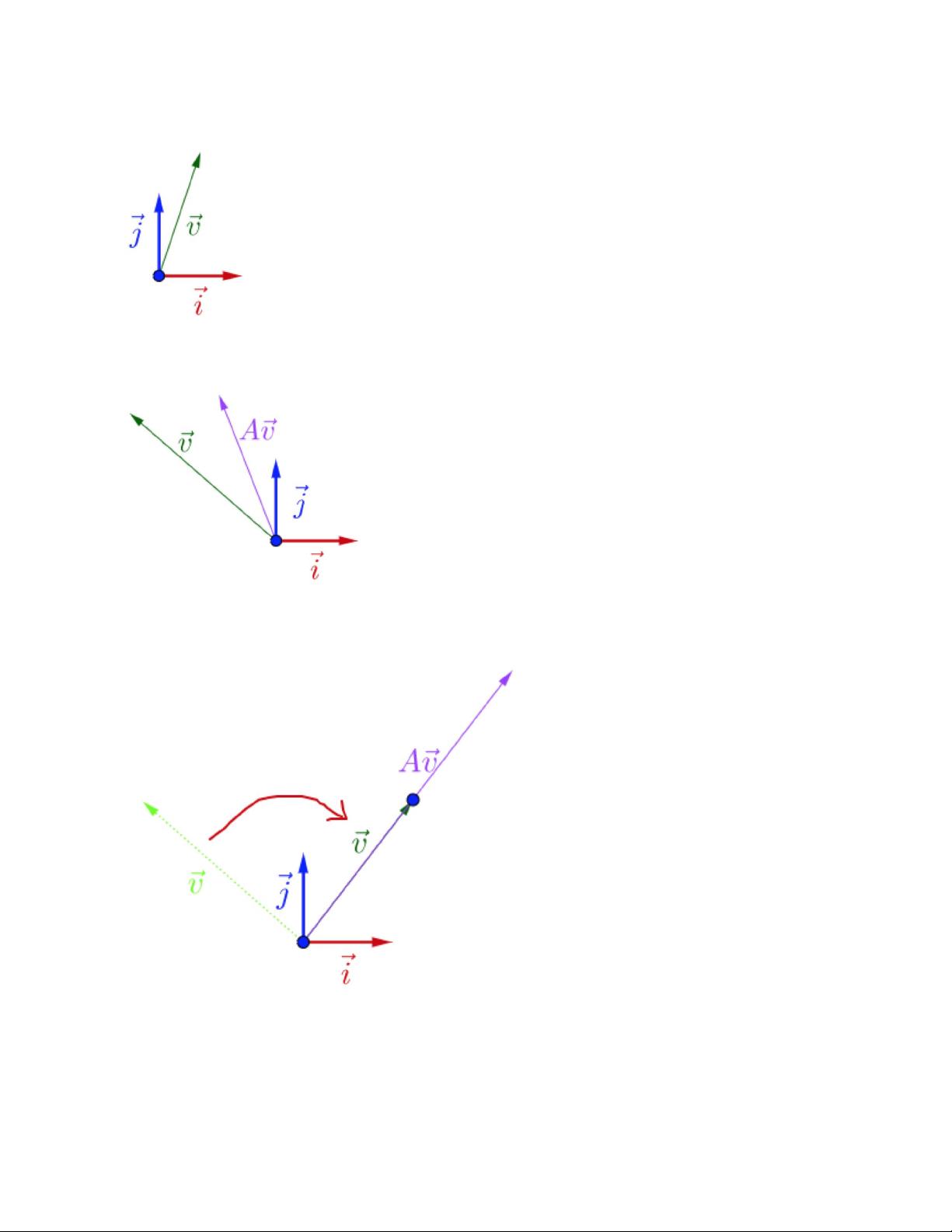

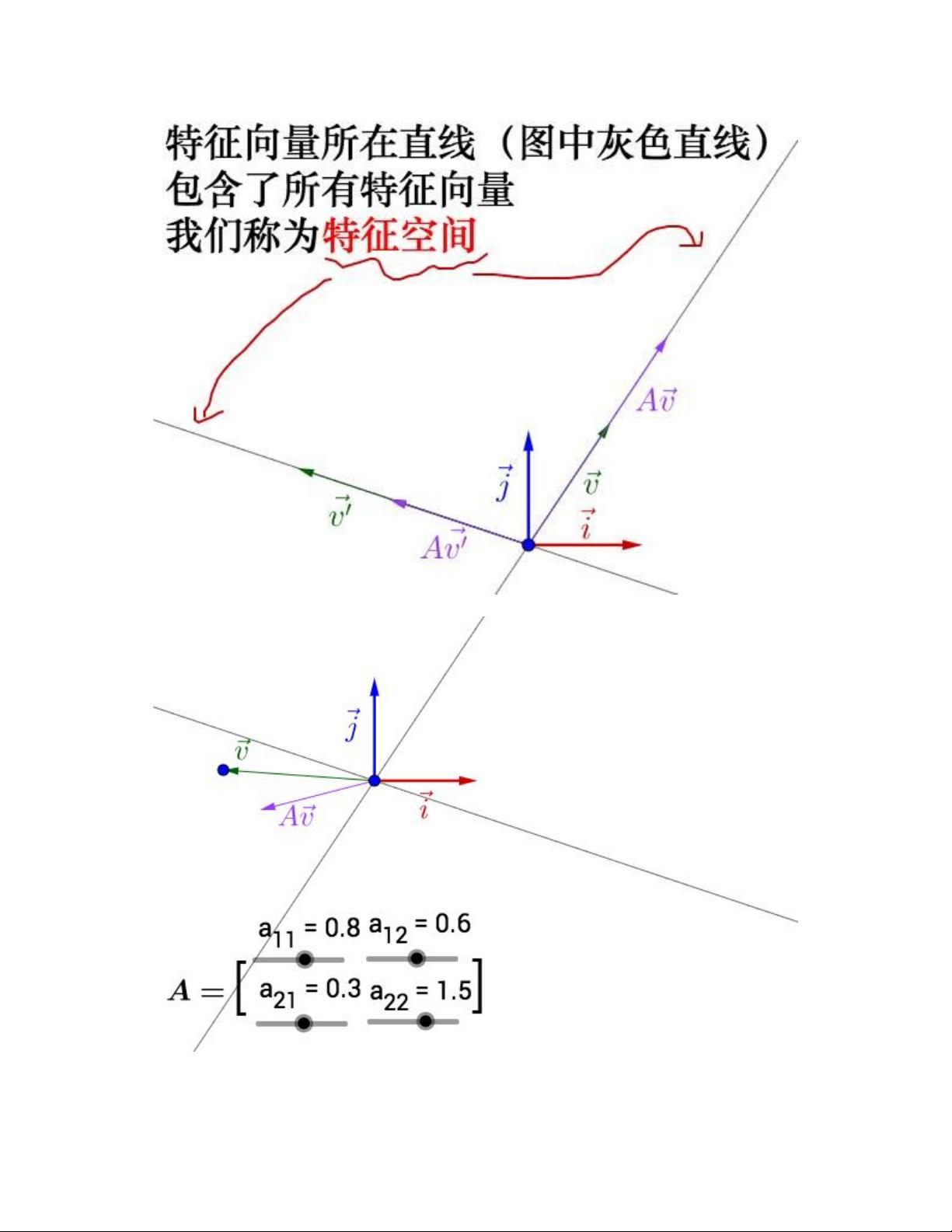

特征值和特征向量是矩阵理论的核心概念。在实数范围内,特征值可以被理解为矩阵动作的速度,而特征向量则代表了这个“速度”沿的方向。特征值和特征向量提供了矩阵动力学的直观描述,揭示了矩阵作用下的动态行为。在实际应用中,例如在数据分析和机器学习模型中,特征值和特征向量经常用于主成分分析(PCA)、奇异值分解(SVD)等技术,以便提取数据的主要特征或降低数据的维度。

这篇线性代数笔记通过几何解释深入浅出地解析了矩阵变换的本质,为学习者提供了一个理解和应用线性代数基础知识的有力工具。无论是初学者还是经验丰富的专业人士,都能从中受益,更好地掌握线性代数在机器学习领域的应用。

2021-10-04 上传

2022-08-03 上传

2023-09-11 上传

2021-05-29 上传

261 浏览量

2018-07-04 上传

fan807017570

- 粉丝: 3

- 资源: 11

最新资源

- SVR:简单向量回归-Udemy

- AquariumHoodLEDController

- Code,java论坛源码,java消息队列订单

- TRIDIEGS:求对称三对角矩阵的特征向量的特征值。-matlab开发

- get_html_source_gui:获取网页源代码GUI代码与重组程序

- json-builder:json-parser的序列化副本

- 参考资料-附件1-9-补充协议-新增.zip

- 共享计时器:一种Web应用程序,您可以在其中创建并与其他人共享计时器。 建立在React Hooks和Firebase之上

- spotify_battle

- maistra-test-tool:在OpenShift上运行maistra任务的测试工具

- mobi_silicon

- CrawlArticle:基于文字密度的新闻正文提取模块,兼容python2和python3,替换新闻网址或网页开源即可返回标题,发布时间和正文内容

- uu,java源码学习,springboot的源码是java

- regexp_parser:Ruby的正则表达式解析器库

- Get15

- Mary Poppins Search-crx插件