Transformer模型在时间序列预测的应用探索

需积分: 0 155 浏览量

更新于2024-06-18

收藏 3.96MB PDF 举报

本文主要探讨如何利用Transformer模型进行时间序列预测,内容来自圆圆的算法笔记,作者Fareise分享了Transformer在时间序列预测领域的应用和优化策略。

Transformer模型最初在自然语言处理(NLP)中取得巨大成功,其自注意力机制使其能够处理序列数据。在时间序列预测任务中,Transformer的序列建模能力同样适用,但由于时间序列数据的自相关性和周期性等特点,需要针对性的改进。

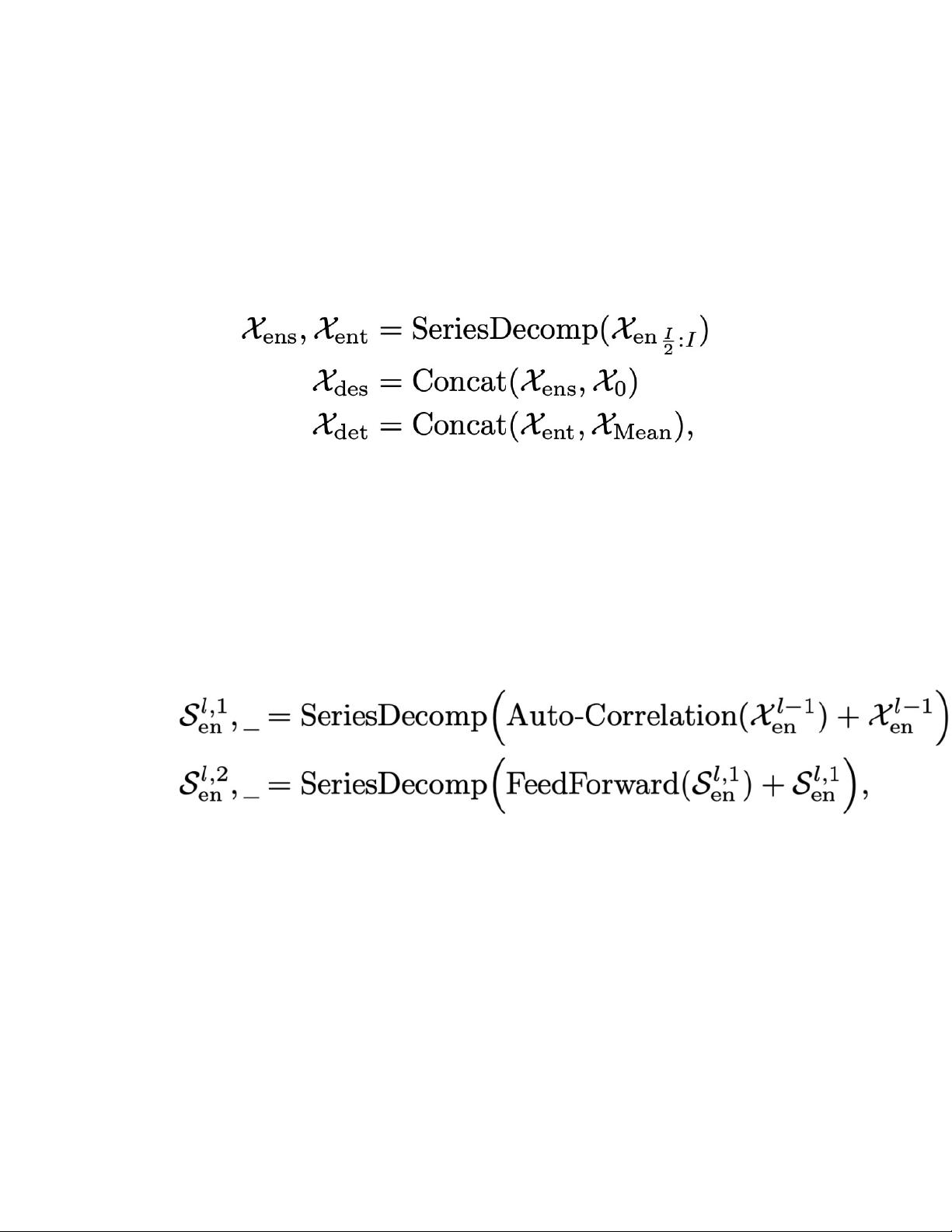

1. Autoformer

Autoformer是Transformer的一个改进版本,专为长时间序列预测设计。它通过Series Decomposition Block模块将时间序列分解为趋势项和季节项,借鉴了传统时间序列分析的思路。此外,Autoformer还引入了Auto-Correlation Mechanism,更新了多头注意力机制,以更好地捕捉时间序列的长期依赖性和周期性。这一模型在NIPS 2021上发表,详细解析可参考相关文章。

2. 时间序列预测的挑战

时间序列预测不仅需要处理序列的自相关性,还要应对长期依赖和周期性的预测问题。这些挑战使得直接应用Transformer时可能遇到困难,因此需要对模型进行特定的适应和优化。

3. 应用与改造

除了Autoformer,还有其他针对时间序列任务的Transformer变体,这些模型通常会针对时间序列的特点进行改进,比如增强模型对序列结构的理解,提高对长期依赖的建模能力,以及处理不同频率的周期性信息。

总结来说,Transformer模型在时间序列预测领域的应用需要考虑时间序列的特性,并进行相应的结构和机制调整。通过分解序列、引入自相关机制等方式,这些优化后的模型能更好地适应时间序列预测任务,提升预测精度。对于想要深入研究这个领域的读者,理解并掌握这些改造方法至关重要。

2021-08-18 上传

2024-07-18 上传

2023-07-27 上传

2023-12-02 上传

2024-05-22 上传

2023-03-12 上传

2024-03-13 上传

2023-08-31 上传

2023-07-27 上传

毕业小助手

- 粉丝: 2743

- 资源: 5583

最新资源

- 天池大数据比赛:伪造人脸图像检测技术

- ADS1118数据手册中英文版合集

- Laravel 4/5包增强Eloquent模型本地化功能

- UCOSII 2.91版成功移植至STM8L平台

- 蓝色细线风格的PPT鱼骨图设计

- 基于Python的抖音舆情数据可视化分析系统

- C语言双人版游戏设计:别踩白块儿

- 创新色彩搭配的PPT鱼骨图设计展示

- SPICE公共代码库:综合资源管理

- 大气蓝灰配色PPT鱼骨图设计技巧

- 绿色风格四原因分析PPT鱼骨图设计

- 恺撒密码:古老而经典的替换加密技术解析

- C语言超市管理系统课程设计详细解析

- 深入分析:黑色因素的PPT鱼骨图应用

- 创新彩色圆点PPT鱼骨图制作与分析

- C语言课程设计:吃逗游戏源码分享