SkipNet: 动态学习跳过卷积网络,提升效率与精度

66 浏览量

更新于2024-06-20

收藏 868KB PDF 举报

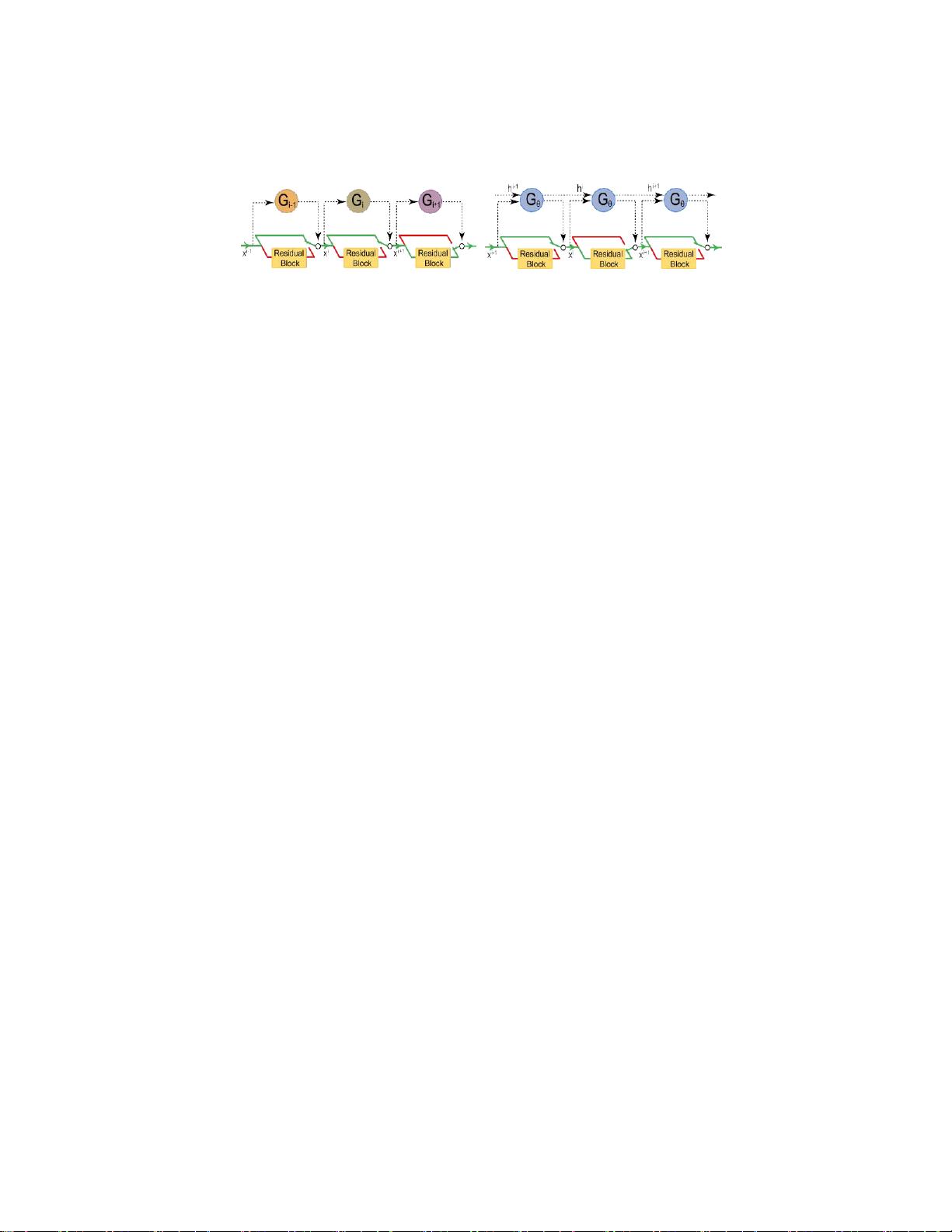

SkipNet是一种创新的深度学习架构,由王欣、余飞等学者提出,他们来自加州大学伯克利分校和南京大学。核心思想是针对视觉感知任务中的深度需求,提出了一种动态跳过卷积层的方法。传统的观点认为深度网络能够提升准确性,但实际研究表明并非所有输入都需要深度网络的全面处理。SkipNet通过引入门控单元和修改后的残差网络结构,学习每个输入的特定策略,智能地决定在推理阶段哪些卷积层可以跳过。

该工作将动态跳过问题视为一个顺序决策问题,其中模型依赖于前几层的输出来判断是否继续执行后续层。这种方法旨在在保持预测精度的前提下,显著减少计算量,因为不是所有的层都对所有输入有同等的重要性。通过这种方式,SkipNet能够降低模型的平均计算成本,同时深入理解各个卷积层对于不同输入的贡献。

学习有效的跳过策略是一个难题,因为这涉及到非连续的决策过程,无法直接应用梯度下降等基于连续优化的方法。为此,SkipNet采用了一种混合学习策略,结合了监督学习和强化学习。强化学习被用来解决不可微跳跃决策的问题,通过训练神经网络来学习最优的跳过策略。

实验结果显示,SkipNet在四个基准数据集上的性能优于先进的动态网络和静态压缩技术,尽管计算量减少了30%到90%,但保持了原始模型的准确性。此外,研究者还进行了定性评估,探究了门控政策如何随着图像复杂度(如尺度和显著性)变化以及与跳过层数的关系。

SkipNet不仅提供了深度学习网络的高效使用方式,还为理解和优化深度网络的结构提供了新的视角,有助于在实际应用中平衡性能和计算资源的需求。

2023-12-16 上传

2024-08-02 上传

2023-06-19 上传

2023-05-20 上传

2023-04-02 上传

2023-03-29 上传

2023-05-04 上传

2023-03-28 上传

2023-10-09 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- 解决Eclipse配置与导入Java工程常见问题

- 真空发生器:工作原理与抽吸性能分析

- 爱立信RBS6201开站流程详解

- 电脑开机声音解析:故障诊断指南

- JAVA实现贪吃蛇游戏

- 模糊神经网络实现与自学习能力探索

- PID型模糊神经网络控制器设计与学习算法

- 模糊神经网络在自适应PID控制器中的应用

- C++实现的学生成绩管理系统设计

- 802.1D STP 实现与优化:二层交换机中的生成树协议

- 解决Windows无法完成SD卡格式化的九种方法

- 软件测试方法:Beta与Alpha测试详解

- 软件测试周期详解:从需求分析到维护测试

- CMMI模型详解:软件企业能力提升的关键

- 移动Web开发框架选择:jQueryMobile、jQTouch、SenchaTouch对比

- Java程序设计试题与复习指南