人工智能安全:聚焦数据与模型风险及差分隐私

需积分: 50 56 浏览量

更新于2024-07-09

收藏 2.83MB PPTX 举报

"人工智能的安全问题与差分隐私"

在当前的高级人工智能课程中,安全问题已经成为了一个不容忽视的重要议题。人工智能(AI)的发展虽然带来了巨大的潜力和便利,但同时也伴随着一系列的安全挑战,尤其是数据安全和模型安全问题。差分隐私作为一种有效的隐私保护技术,正在逐渐成为解决这些问题的关键。

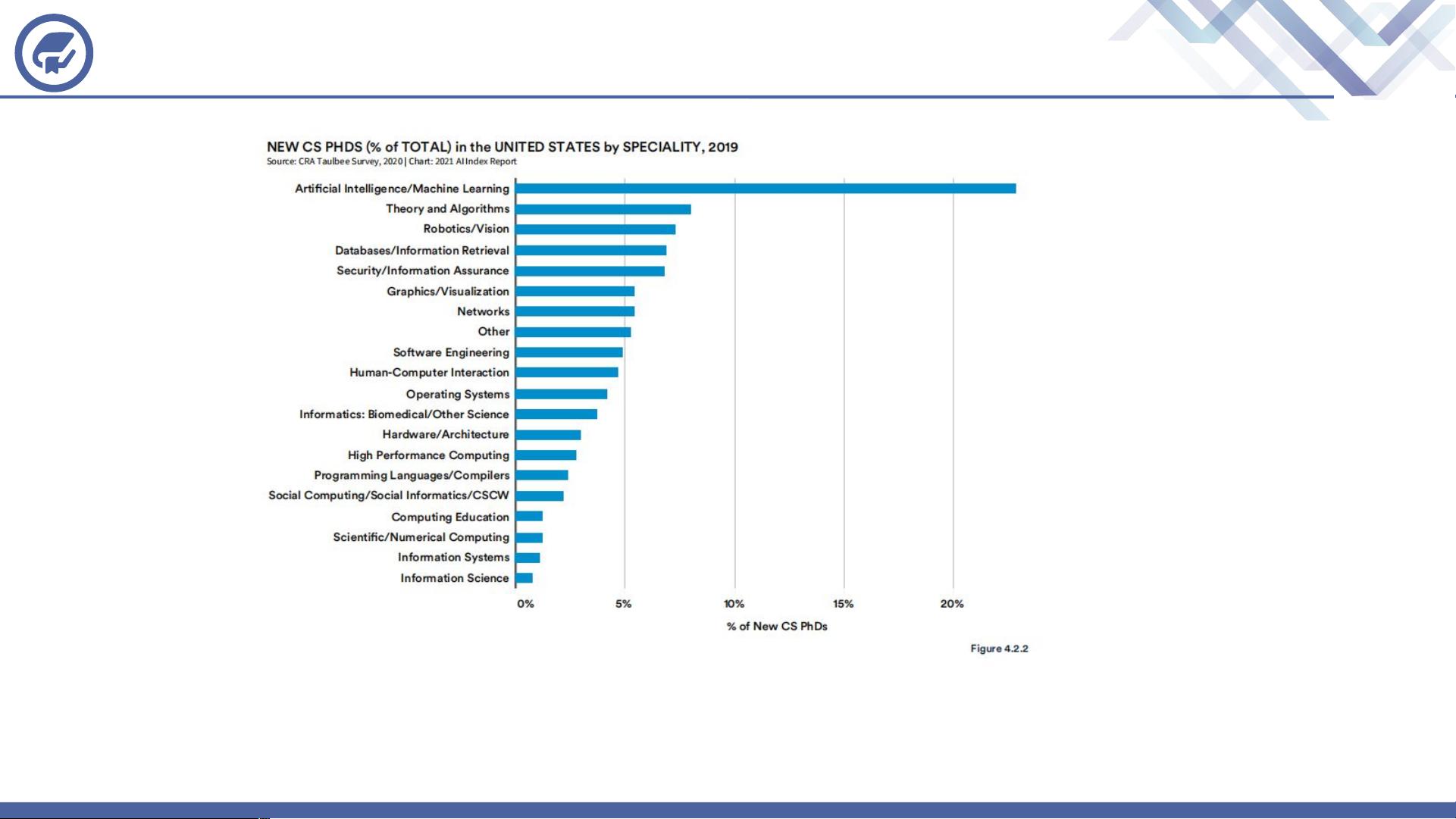

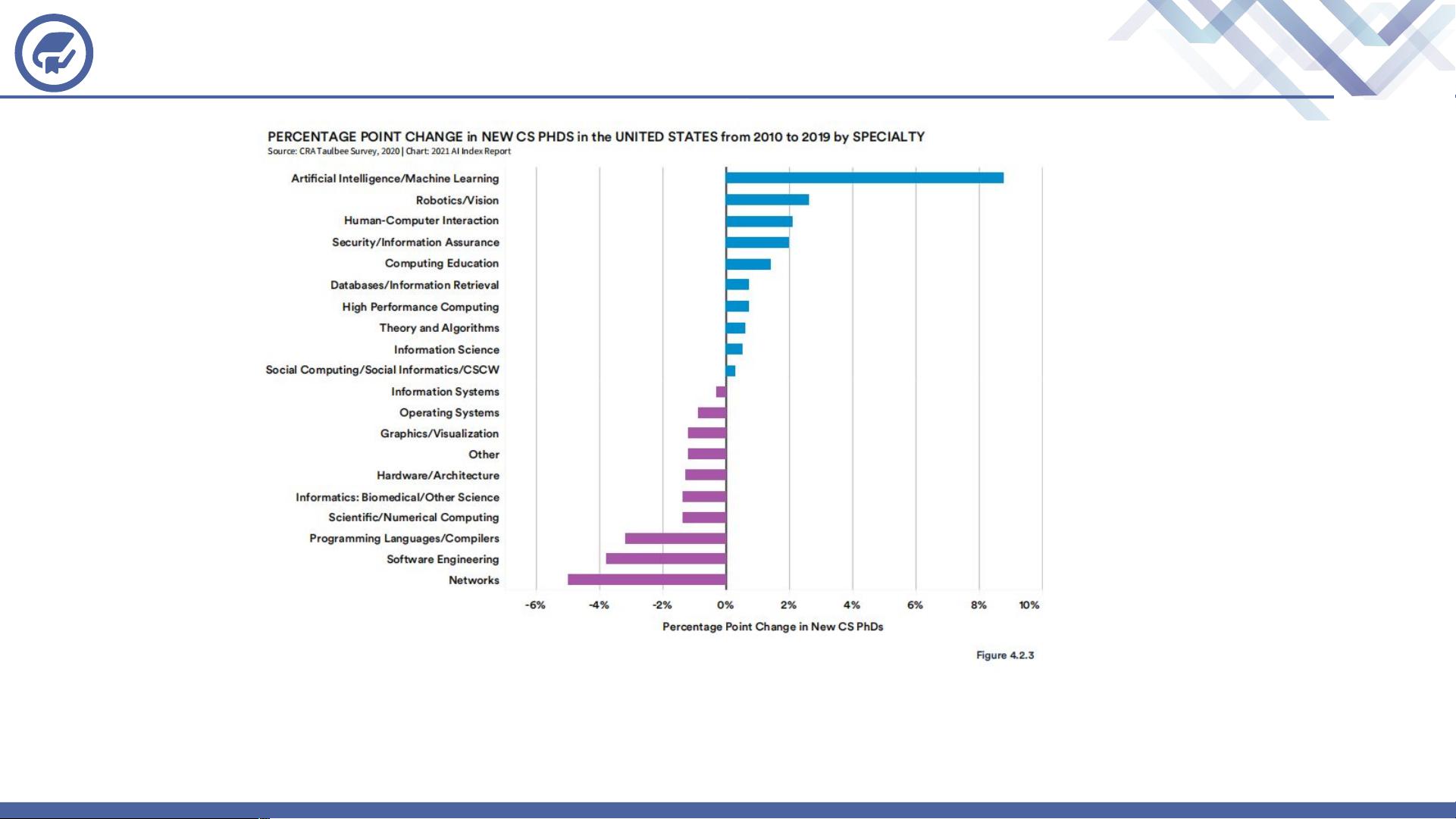

首先,我们探讨研究背景。根据2020年的报告,组织在采用AI时面临的主要风险是网络/信息安全问题,但大部分研究仍然集中在提升AI的性能上。这种现象反映了一个现实:尽管AI的安全隐患突出,但相关研究并未得到充分的关注。从学术领域来看,美国新CS博士生的研究方向中,专注于安全和隐私问题的比例并不高,这表明在人才配置上存在失衡,可能加剧了安全问题的严重性。

人工智能的安全问题主要分为两方面:数据安全和模型安全。数据安全涉及的是如何防止敏感信息如训练集、模型参数等的泄露。这不仅包括对原始数据的保护,还涵盖了防止模型被逆向工程以获取训练数据的隐私信息。模型安全则关注模型本身是否能够抵御攻击,确保其在面对恶意行为时仍能正常运作。

针对数据安全问题,有研究将攻击分为基于模型输出和基于梯度更新两种类型。前者涉及模型窃取和隐私泄露,后者主要出现在分布式学习环境中,其中攻击者可能通过获取梯度更新来推断出敏感信息。为了对抗这些攻击,研究人员开始探索各种防御策略,这些策略在理念上与差分隐私有着密切的联系。

差分隐私是一种统计学方法,它允许数据分析的同时保护个体隐私,通过引入随机噪声来模糊个体的具体贡献,使得攻击者无法确定某个人的具体信息。这种方法在保护模型训练数据和模型输出时都显示出了潜力,可以有效防止数据泄露,同时保持模型的准确性。

人工智能的安全问题不仅限于数据泄露,还包括模型的脆弱性。随着差分隐私技术的发展,它有望成为解决这些问题的重要工具,促进AI在保障安全和隐私的前提下更广泛地应用。未来的研究应更加重视这一领域,以构建更为安全、可靠的AI系统。

2021-09-03 上传

2023-06-09 上传

2023-04-02 上传

2023-10-31 上传

2023-06-09 上传

2023-07-09 上传

2024-03-17 上传

2023-06-09 上传

粥粥粥少女的拧发条鸟

- 粉丝: 1w+

- 资源: 7

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性