Hadoop数据压缩优化:原理与策略

需积分: 0 158 浏览量

更新于2024-08-05

收藏 573KB PDF 举报

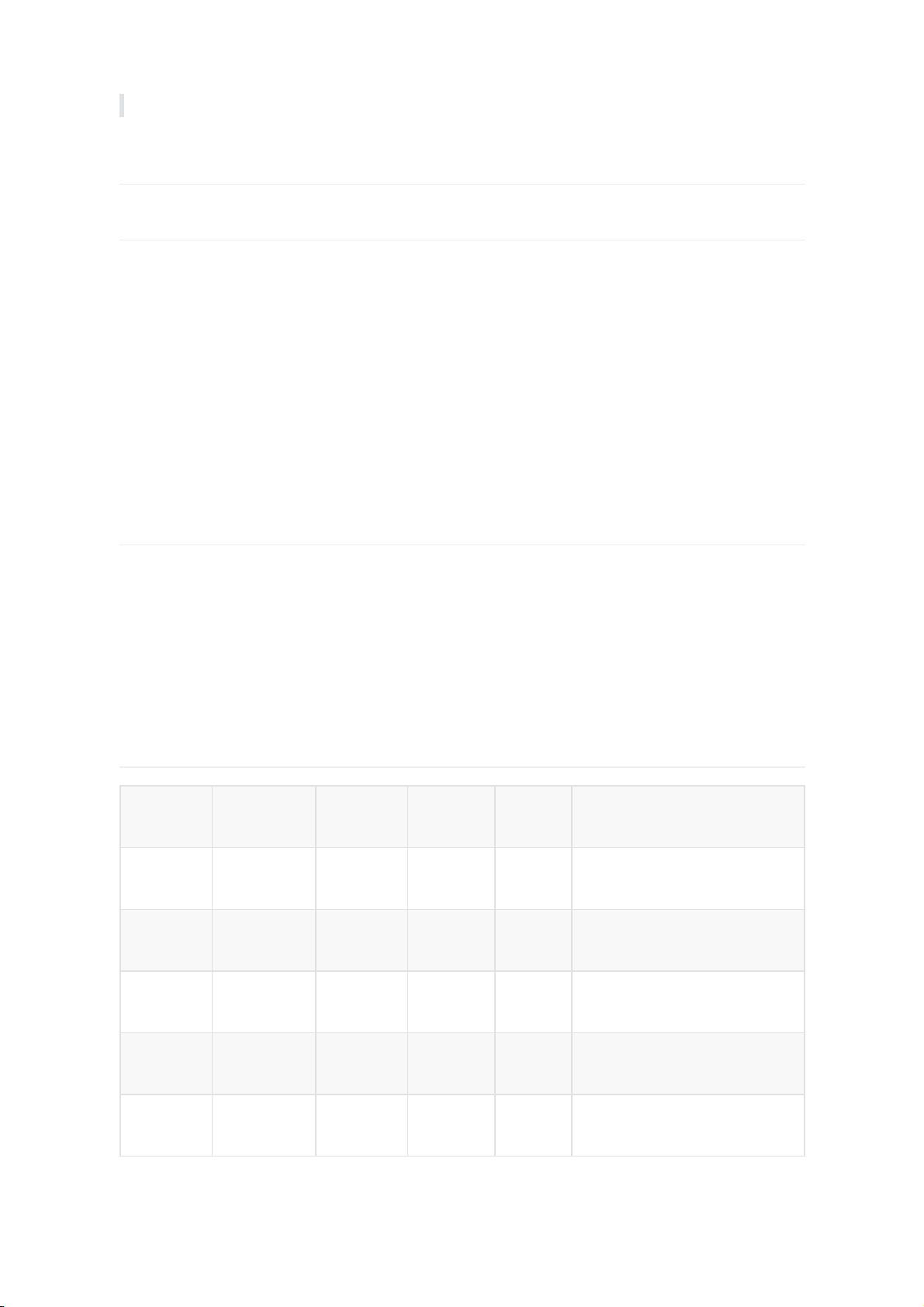

在Hadoop数据处理中,数据压缩是一种关键的优化手段,特别是在处理大规模数据和高负载任务时。Hadoop本身提供了一定程度的支持,包括内置的压缩算法和相应的编码/解码器。常见的压缩格式有:

1. **DEFLATE**:Hadoop直接支持DEFLATE格式,其扩展名为`.deflate`。使用这种格式时,原有的程序无需修改,可以直接利用Hadoop的DefaultCodec进行处理。

2. **Gzip**:同样,Gzip也是Hadoop支持的,扩展名为`.gz`,同样不需要对程序做任何改动,可以直接通过GzipCodec来实现压缩和解压。

3. **bzip2**:虽然原生Hadoop不直接支持,但可以通过BZip2Codec来处理.bzip2文件,程序无需修改,但需要预先安装支持bzip2的库。

4. **LZO**:LZO是一种压缩格式,需要额外安装LZO库才能在Hadoop中使用,扩展名为`.lzo`。压缩后需要建立索引,并指定输入格式,因此程序需要进行相应调整。

5. **Snappy**:Snappy虽然不在Hadoop的默认支持列表中,但同样可以使用,它不需要安装额外的库,也不影响程序代码,但同样需要指定输入格式。

压缩技术的优势在于减小存储需求,提高网络带宽效率和磁盘I/O性能,尤其是在大数据处理中,这有助于减少MapReduce作业的IO压力和整体处理时间。然而,压缩操作会增加CPU负担,因此在选择压缩策略时,需要考虑作业的性质:

- 对于运算密集型的工作负载,由于CPU已经饱和,过多的压缩可能反而降低性能,应谨慎使用或仅在必要时启用。

- 对于IO密集型的任务,特别是那些受磁盘I/O和网络限制的情况,压缩能显著提高性能。

Hadoop通过编码/解码器机制支持这些压缩格式,允许开发者根据实际需求灵活选择合适的压缩方案。在实际应用中,合理评估压缩对性能的影响,结合业务场景,选择合适的压缩策略,是优化Hadoop性能的关键。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2012-09-14 上传

2021-04-30 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

芊暖

- 粉丝: 28

- 资源: 339

最新资源

- iBATIS-SqlMaps-2_cn.pdf

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- IShort.pdf

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- C___Builder_5_开发人员指南

- 五子棋 课程设计 c语言

- unix基础教程(很好,很基础)