Hadoop大数据MapReduce:优化数据压缩策略与适用场景

需积分: 0 123 浏览量

更新于2024-08-05

收藏 224KB PDF 举报

本篇文章主要探讨Hadoop中的数据压缩技术在MapReduce框架下的应用,以及如何有效地利用这一特性来优化大数据处理性能。章节4.1首先阐述了数据压缩在Hadoop环境中的重要性,尤其是在大规模数据集和高负载场景下,压缩能够显著减少磁盘I/O和网络带宽的需求,从而提升整体性能和资源利用率。然而,压缩操作虽然可以节省CPU开销,但也会增加CPU的运算负担,因此在设计时需要权衡。

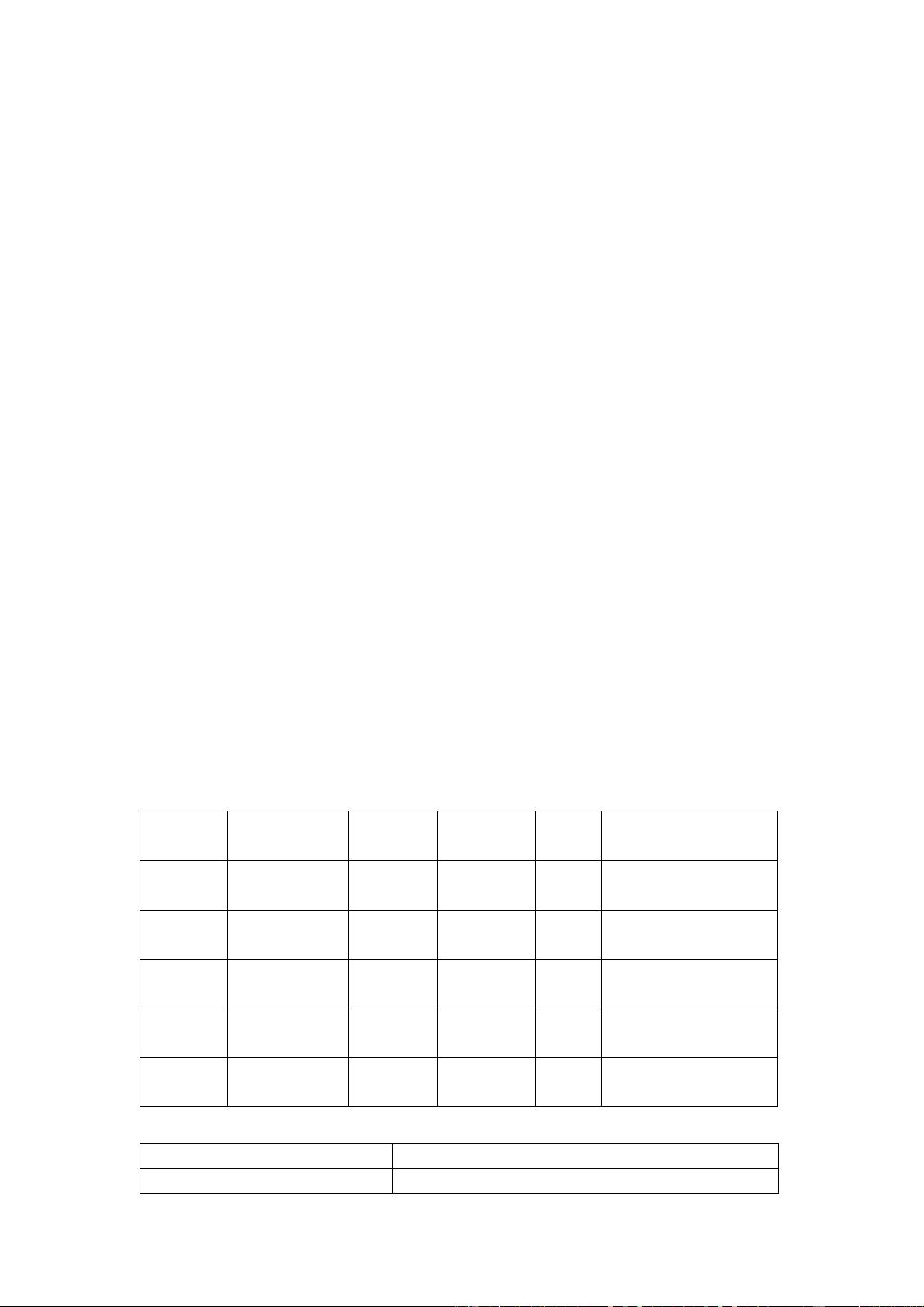

章节4.2介绍了MapReduce支持的几种常见的压缩编码格式,包括:

1. DEFAULT.deflate:这是Hadoop默认的压缩算法,无需额外安装,但可能需要修改程序以支持其解码。程序通常会自动处理,除非特殊设置。

2. Gzip:Hadoop内置,可以直接使用,无需修改代码,与文本处理兼容。

3. bzip2:同样内置,直接使用,无需修改,需要bz2扩展名。

4. LZO:虽然Hadoop支持,但需要单独安装,并且可能需要指定输入格式和建立索引。

5. Snappy:非内置,需要安装,不需要修改程序,但同样需要额外处理。

Hadoop通过编码/解码器机制支持这些不同的压缩算法,如DEFLATE对应DefaultCodec,gzip对应GzipCodec,bzip2对应BZip2Codec,LZO对应com.hadoop.compression.lzo.LzoCodec。选择哪种压缩格式取决于具体的工作负载类型:运算密集型任务应少用压缩以避免CPU消耗,而I/O密集型任务则可以考虑使用以减少磁盘I/O。

在实际操作中,章节4.6提供了压缩实操案例,涉及数据流的压缩和解压。这包括在Mapper或Reducer输出阶段启用压缩,以减少磁盘I/O,但同时也需要考虑到压缩参数的配置,以找到最佳的性能平衡点。

总结来说,Hadoop的数据压缩技术是一种强大的工具,但必须根据具体任务的特性和需求进行适配,以实现性能提升的同时避免性能下降。理解并合理运用这些压缩算法和配置选项是优化MapReduce性能的关键。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-03 上传

2022-08-03 上传

2022-08-04 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

丛乐

- 粉丝: 38

- 资源: 312