决策树学习详解:信息增益与剪枝策略

需积分: 0 163 浏览量

更新于2024-08-05

收藏 7.7MB PDF 举报

"这篇资料主要介绍了决策树的学习与构建过程,包括信息增益、信息增益比的概念,以及ID3算法和剪枝方法。"

在机器学习领域,决策树是一种广泛应用的监督学习算法,尤其适合分类任务。它通过构建一棵树形结构来模拟决策过程,其中每个内部节点代表一个特征,每个分支代表一个特征值,而每个叶节点则代表一个类别决策。

决策树的构建通常涉及到以下几个关键知识点:

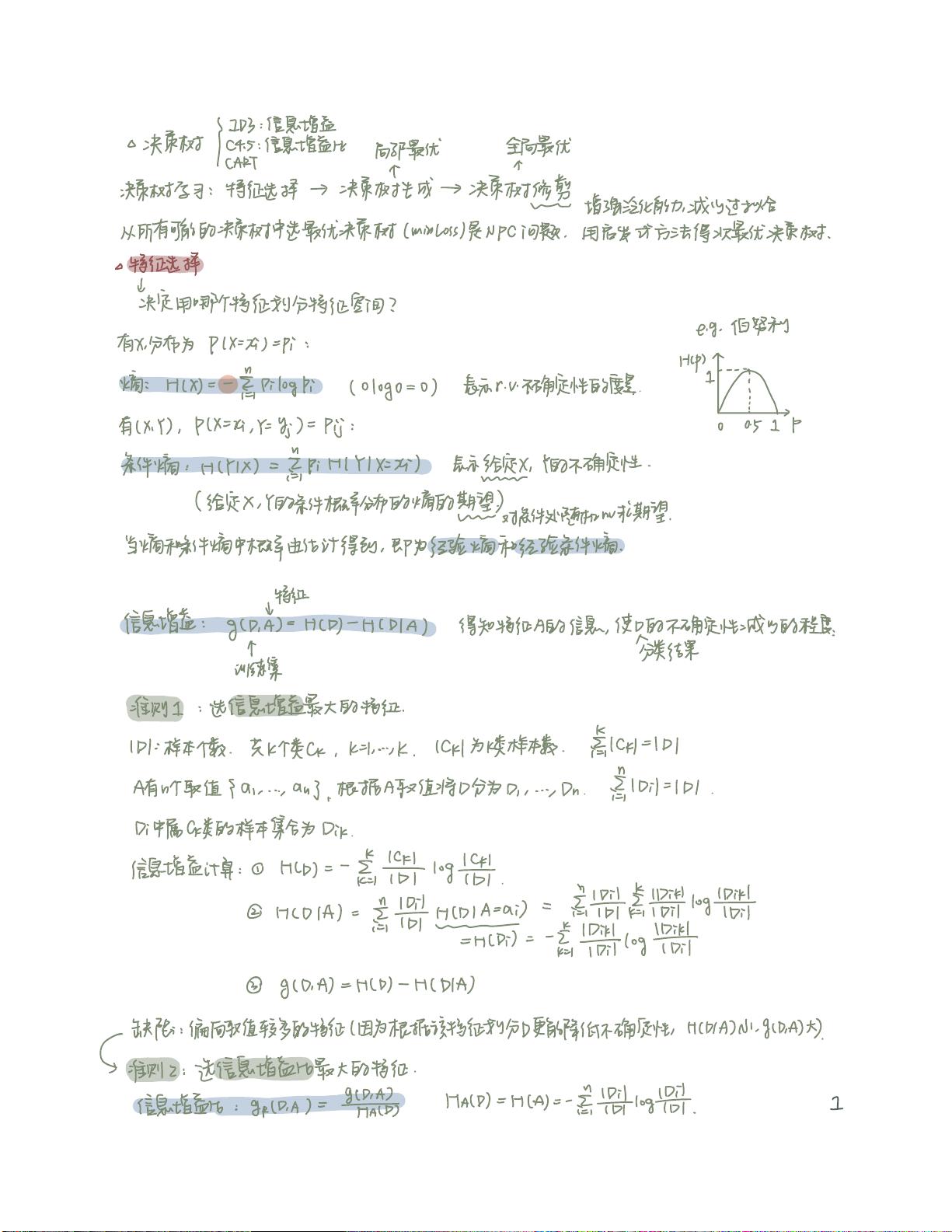

1. **信息熵**:熵是衡量数据纯度或不确定性的度量。对于具有类别C的样本集合D,熵H(D)定义为各个类别概率的负对数,即\( H(D) = -\sum_{i=1}^{k} P(C_i) \log_2 P(C_i) \),其中\( P(C_i) \)是类别C_i在D中的概率。

2. **信息增益**:信息增益是通过选择某个特征进行划分后,数据集的熵减少的程度。它是决策树选择划分特征的标准之一,计算公式为\( g(D, A) = H(D) - H(D|A) \),其中A是特征,H(D|A)是给定特征A后的条件熵。

3. **信息增益比**:为了避免信息增益倾向于选择具有大量取值的特征,引入了信息增益比,它是信息增益除以特征A的熵,即\( Gini\_index(A) = \frac{g(D, A)}{H(A)} \)。选择信息增益比最大的特征可以平衡数据划分的均匀性和特征的复杂性。

4. **ID3算法**:ID3(Iterative Dichotomiser 3)是一种基于信息增益构建决策树的算法。它从根节点开始,每次选择信息增益最大的特征作为划分依据,直到所有特征都用尽或满足停止条件。

5. **剪枝**:决策树容易过拟合,即在训练集上表现良好,但在未知数据上性能下降。为了提高泛化能力,通常会采用剪枝策略,如Reduced Error Pruning(错误率剪枝)。这种方法会删除那些不会显著增加预测误差的子树,以达到简化模型并防止过拟合的目的。

6. **叶节点的经验熵**:在剪枝过程中,计算叶节点的经验熵是评估其纯度和是否需要进一步剪枝的重要指标。如果叶节点的样本属于同一类别,其熵为0,表明纯度最高。

7. **最优特征选择**:决策树算法在选择最佳划分特征时,会考虑信息增益、信息增益比等多种准则,以找到能够最大程度减少数据不确定性或增加数据纯度的特征。

通过以上这些概念和方法,我们可以构建出一个既能有效学习又能避免过拟合的决策树模型,从而在各种实际问题中实现高效且准确的分类。

2009-07-19 上传

185 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情