个性化内容推荐:决策树在推荐系统中的应用分析

发布时间: 2024-09-05 00:16:35 阅读量: 117 订阅数: 40

商务智能-决策树在选课系统中的应用.ppt

# 1. 决策树与推荐系统的概述

在当今的IT领域,决策树与推荐系统作为机器学习和人工智能技术的重要组成部分,越来越受到行业的关注。本章将为读者提供这两个概念的概述,奠定后续章节深入讨论的基础。

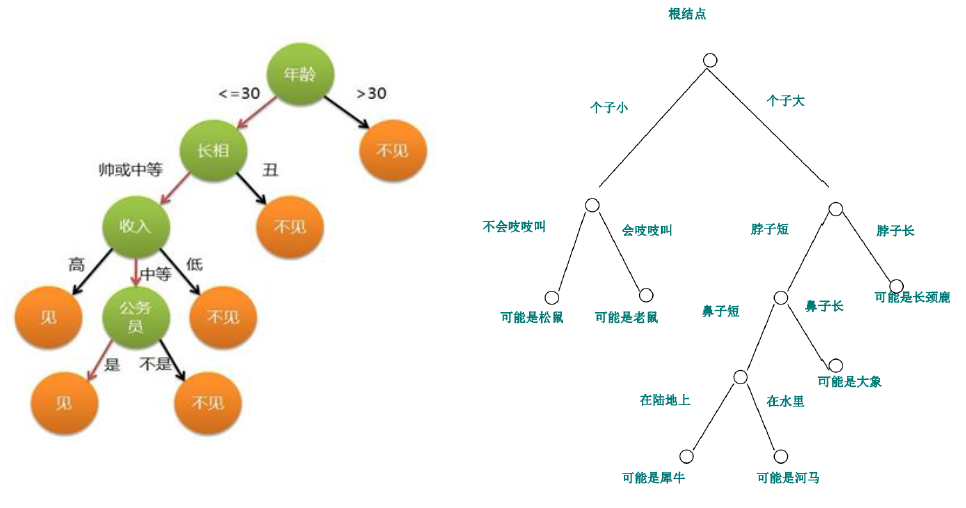

## 1.1 决策树的定义

决策树是一种监督学习算法,通过学习一系列的规则对数据进行分类。它通过树状结构将决策过程可视化,以易于理解的方式呈现决策逻辑。

## 1.2 推荐系统的概念

推荐系统旨在根据用户的历史行为和偏好,预测用户对物品的评价并提供推荐。它广泛应用于电商平台、视频流媒体服务等多个领域。

## 1.3 决策树与推荐系统的关联

决策树因其简洁性和解释性,在推荐系统中扮演重要角色。它可以帮助理解用户的偏好,并构建出高效且可解释的推荐模型。

在接下来的章节中,我们将详细探讨决策树的理论基础,以及它如何应用于推荐系统,并剖析在实际开发过程中所面临的挑战和解决方案。

# 2. 决策树的理论基础

### 2.1 决策树的定义与发展

#### 2.1.1 决策树的起源与概念

决策树是一种流行的监督学习算法,它通过创建一个模型来预测目标变量的值。在IT和数据科学领域,决策树常用于分类问题,同时也能够应用于回归问题。它通过一系列的问题对数据进行分割,这些问题是决策节点,最终通过分支达到叶节点,代表了预测结果的类别或者数值。最初,决策树的概念起源于计算机科学和统计学的交叉领域,它模拟了人类决策过程中的逻辑思维。

在决策树中,每一个内部节点都代表一个属性上的测试,每个分支代表测试输出,每个叶节点代表一种分类结果或者回归值。随着数据的增长和模型复杂度的提高,决策树在大型数据集上的应用变得更加广泛,特别是在需要解释性和决策过程透明度的场景。

##### 2.1.2 决策树的主要算法与比较

主要的决策树算法包括ID3、C4.5、CART等。ID3算法采用信息增益来选择属性,构建多路树;C4.5是ID3的改进版,用信息增益率解决了偏向多值属性的问题;CART算法则采用基尼不纯度作为分裂标准,构建二叉树。每种算法在不同的应用领域和数据集上表现各异,选择合适的算法需要根据具体问题和数据特性进行。

这些算法各有优劣,C4.5在处理连续值属性时较为复杂,而CART在处理大规模数据集时更加高效。因此,在实际应用中,根据数据集的性质和所需结果的类型,选择适当的决策树算法至关重要。

### 2.2 决策树的构建过程

#### 2.2.1 信息增益与熵的概念

信息增益是衡量一个属性所带来的信息量的指标,它基于信息论中的熵概念。熵是度量数据集纯度的指标,熵越低表示数据集越纯,即其内部样本类别越一致。信息增益是将数据集按照某一属性分裂后熵的减少量。一般而言,信息增益越大,说明该属性对分类的贡献越大。

信息增益的计算公式为:

```

信息增益 = Entropy(父节点) - [ (子节点1的概率) * Entropy(子节点1) + (子节点2的概率) * Entropy(子节点2) + ... ]

```

熵的计算公式为:

```

Entropy(S) = - ∑ [ p(x) * log2(p(x)) ]

```

其中,`p(x)` 表示事件x发生的概率,`log2` 是以2为底的对数。通过计算,我们可以得出哪个属性作为节点分割数据,从而使得结果的纯度最大。

#### 2.2.2 分裂标准的选择方法

分裂标准是指在构建决策树时,如何选择一个最优的属性作为分裂点。最常用的分裂标准包括信息增益、增益率和基尼不纯度。信息增益倾向于选择具有更多值的属性,可能会导致过拟合;增益率是对信息增益的改进,它通过考虑属性的固有信息来缓解这一问题;基尼不纯度则是基于概率统计的概念,反映了从数据集中随机抽取两个样本类别标签不一致的概率。

选择分裂标准时,需要权衡模型的复杂度和预测的准确性。例如,C4.5算法使用增益率,而CART使用基尼不纯度。

#### 2.2.3 决策树的剪枝技术

剪枝技术用于防止决策树过拟合。过拟合发生时,模型学习到了训练数据中的噪声和异常值,导致其泛化能力下降。剪枝技术有两种,分别是预剪枝和后剪枝。预剪枝在树构建过程中提前停止分裂,而后剪枝则在树构建完成后移除掉一些分支。

在实际操作中,预剪枝通过限制树的深度、最小分割样本数、分割后的最小样本数等参数来提前停止树的生长。后剪枝更为复杂,需要评估去掉某个分支后对模型性能的影响,如果去掉后模型的泛化能力有所提升,则将该分支剪掉。

### 2.3 决策树算法的优缺点分析

#### 2.3.1 决策树模型的准确性评估

准确性是评估决策树模型性能的主要指标之一。它可以使用准确率(Accuracy)度量,也可以使用其他指标,如精确率(Precision)、召回率(Recall)和F1分数(F1 Score)。这些指标从不同角度评估了模型在分类任务上的表现。

- 准确率:正确分类的样本数除以总样本数。

- 精确率:正确预测为某一类的样本数除以被预测为该类的样本总数。

- 召回率:正确预测为某一类的样本数除以实际为该类的样本总数。

- F1分数:精确率和召回率的调和平均值。

通过混淆矩阵(Confusion Matrix),我们可以计算出这些指标并评估模型性能。

#### 2.3.2 决策树常见的问题与局限性

尽管决策树在某些方面具有优势,但它们也面临着一些问题和局限性。首先,决策树非常容易受到数据集中的噪声和异常值的影响,导致过拟合。其次,当数据集中的分类标签极度不平衡时,决策树可能无法有效地对少数类进行预测。此外,决策树倾向于创建复杂的树模型,这可能使得模型解释性变差。

为了解决这些问题,研究人员和工程师们开发了各种技术,如剪枝、集成学习等。通过这些方法可以提高模型的泛化能力,提升决策树在现实世界问题中的应用效果。

# 3. 决策树在推荐系统中的应用实践

## 3.1 推荐系统的类型与决策树结合

### 3.1.1 基于内容的推荐系统

基于内容的推荐系统(Content-based Recommendation Systems)主要关注于分析项目的属性特征,并基于用户对特定属性的偏好来提出建议。其核心思想是用户偏好可以由他们所喜欢的项目的内容特征来表示。在这种推荐系统中,决策树可

0

0