医疗数据分析:决策树如何助力精准诊断预测

发布时间: 2024-09-04 23:54:36 阅读量: 251 订阅数: 40

数学建模精准医疗预测模型.docx

# 1. 决策树算法概述

## 简介

决策树算法是机器学习领域一种广泛应用的分类和回归方法,它通过模拟人类的决策过程来解决实际问题。决策树在处理分类问题时,能够将复杂的决策过程分解为一系列易于理解的规则,使得最终模型既直观又具有解释性。

## 重要性

在数据挖掘和模式识别任务中,决策树的重要性体现在其简洁的模型表示和高效的学习过程。它能够处理数值型和类别型特征,易于实现和理解,非常适合于非技术背景的业务人员使用。

## 应用场景

决策树广泛应用于各个行业,尤其是在金融风险管理、信用评分、医疗诊断等领域。它不仅可以用于预测,还可以用于数据探索和特征重要性评估,从而帮助决策者更好地理解数据和采取相应的策略。

# 2. 决策树的理论基础

## 2.1 决策树算法的数学原理

决策树算法的数学基础涉及到选择最合适的属性来进行数据集的分割,以期达到最佳的分类效果。在这一过程中,信息熵与信息增益、基尼不纯度与分裂标准是两个核心概念。

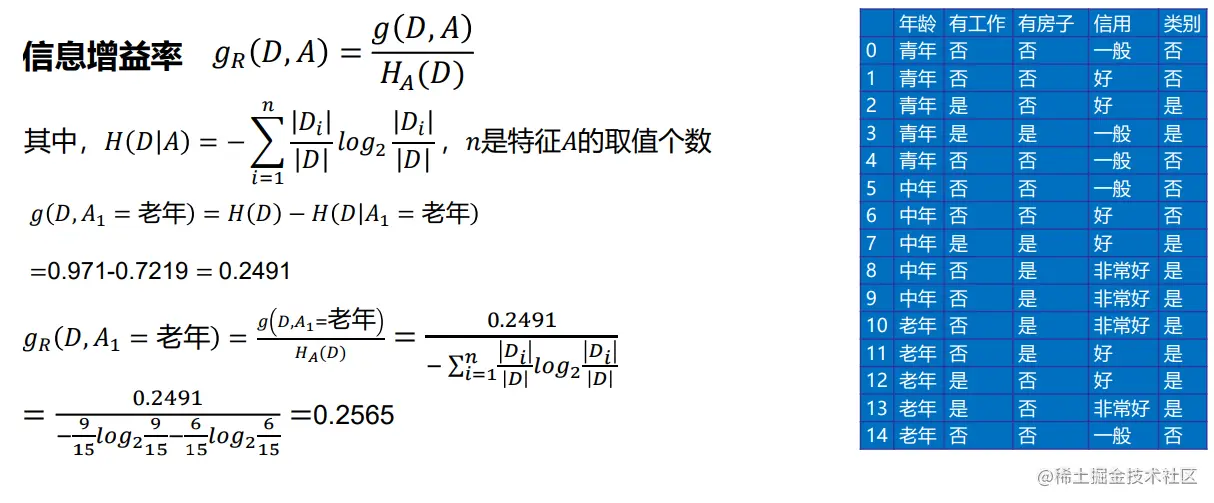

### 2.1.1 信息熵与信息增益

信息熵是衡量数据集中信息混乱程度的度量,其概念来源于信息论。熵越高,代表数据集的不确定性越大。在决策树中,信息熵被用来评估特征对数据集分类的重要性。

用数学语言表示,对于一个有N个数据点的集合D,每个数据点属于类别C_i(i=1,...,M),集合D中属于C_i的概率是p_i,则D的信息熵定义为:

\[ Ent(D) = -\sum_{i=1}^{M} p_i \log_2(p_i) \]

信息增益则是划分数据前后信息熵的减少量。设特征A有V个可能的取值,根据特征A的取值将数据集划分为V个子集{D_1, D_2, ..., D_V},则信息增益计算公式为:

\[ IG(D,A) = Ent(D) - \sum_{v=1}^{V} \frac{|D_v|}{|D|} Ent(D_v) \]

代码解释:

```python

import numpy as np

def entropy(y):

# 计算向量y的熵值

unique_classes, counts = np.unique(y, return_counts=True)

probabilities = counts / counts.sum()

entropy = -np.sum([p * np.log2(p) for p in probabilities])

return entropy

def information_gain(D, feature_index, target_index, labels):

# 计算划分数据集D前后信息熵的减少量(信息增益)

# D是一个二维数据集

parent_entropy = entropy(D[:, target_index])

values, counts = np.unique(D[:, feature_index], return_counts=True)

# 计算加权平均的子集熵

weighted_entropy = sum([(counts[i] / D.shape[0]) * entropy(D[D[:, feature_index] == values[i], target_index]) for i in range(len(values))])

# 计算信息增益

information_gain = parent_entropy - weighted_entropy

return information_gain

# 示例数据

D = np.array([...]) # 这里是数据集

target_index = ... # 目标变量的索引

feature_index = ... # 要评估的特征索引

labels = np.unique(D[:, target_index]) # 类别标签

# 计算信息增益

gain = information_gain(D, feature_index, target_index, labels)

```

上述代码计算了一个数据集在给定特征上的信息增益。通过信息增益,决策树算法能够选择出在数据集划分上最有价值的特征。

### 2.1.2 基尼不纯度与分裂标准

基尼不纯度是另一个衡量数据集不纯度的度量方式,它表示从数据集中随机抽取两个样本,其类别标签不一致的概率。基尼不纯度越低,数据集的纯度越高。

基尼不纯度的公式为:

\[ Gini(D) = 1 - \sum_{i=1}^{M} p_i^2 \]

决策树在每个节点分裂时会计算不同特征划分的加权平均基尼不纯度,选择具有最小加权平均基尼不纯度的特征作为分裂标准。

代码解释:

```python

def gini_impurity(y):

# 计算向量y的基尼不纯度

unique_classes, counts = np.unique(y, return_counts=True)

probabilities = counts / counts.sum()

gini = 1 - sum([p ** 2 for p in probabilities])

return gini

def gini_gain(D, feature_index, target_index):

# 计算划分数据集D前后基尼不纯度的减少量(基尼增益)

parent_gini = gini_impurity(D[:, target_index])

values, counts = np.unique(D[:, feature_index], return_counts=True)

weighted_gini = sum([(counts[i] / D.shape[0]) * gini_impurity(D[D[:, feature_index] == values[i], target_index]) for i in range(len(values))])

gini_gain = parent_gini - weighted_gini

return gini_gain

# 示例数据

D = np.array([...]) # 这里是数据集

target_index = ... # 目标变量的索引

feature_index = ... # 要评估的特征索引

# 计算基尼增益

gain = gini_gain(D, feature_index, target_index)

```

上述代码展示了如何在决策树中使用基尼不纯度来评估特征的分裂价值。

## 2.2 决策树的构建过程

决策树的构建是一个自顶向下的递归过程,通过选择最佳特征来分裂节点,直到满足停止条件。

### 2.2.1 树的生成

构建决策树的过程中,每个节点代表了对数据的一个测试,每个分支代表测试的结果,而每个叶节点代表最终的分类结果。

从根节点开始,算法会选择一个最佳特征进行数据集的划分,然后在每个子节点上递归地进行同样的操作,直到满足以下停止条件之一:

- 所有特征的分裂信息增益或基尼增益都小于一个阈值

- 所有节点的数据都属于同一类别

- 节点中的数据样本小于某个阈值,无法进一步划分

- 没有更多的特征可供选择进行分裂

### 2.2.2 树的剪枝策略

为了防止过拟合,需要对生成的决策树进行剪枝。剪枝的方法有预剪枝和后剪枝。

- 预剪枝是在树构建过程中提前停止树的生长,例如设置分裂的最小样本数或信息增益的阈值。

- 后剪枝是在树完全生成后,通过剪掉一些分支来简化树结构。通常后剪枝方法会牺牲一部分训练集的准确率以获得更好的泛化能力。

代码示例:

```python

def post_pruning(tree, validation_data):

# 后剪枝逻辑

# tree是已经构建好的决策树模型

# validation_data是验证数据集

# 实现细节省略...

pass

# 构建树的代码省略...

# 假设已经构建了完整的决策树

# 应用后剪枝

post_pruned_tree = post_pruning(tree, validation_data)

```

## 2.3 决策树算法的分类与比较

### 2.3.1 ID3、C4.5与C5.0算法

ID3算法是较早的决策树算法之一,其主要缺点是只能处理离散特征,而且对缺失数据和数值型特征支持不足。C4.5和C5.0是ID3的改进版本,可以处理数值型特征,并且在剪枝、信息增益比等方面进行了改

0

0