市场营销新境界:决策树驱动的客户细分策略

发布时间: 2024-09-04 23:57:36 阅读量: 134 订阅数: 40

# 1. 决策树在市场营销中的作用和重要性

在当今数字化营销的世界中,决策树算法已经成为了市场分析和客户行为预测的强大工具。本章节将探讨决策树在市场营销中的角色,以及其重要性如何被业内专家所认可。

首先,我们要明确决策树是一种监督式学习算法,通过学习已知的决策规则来预测未知数据的分类或回归问题。在市场营销领域,决策树能够帮助分析师处理复杂的决策问题,识别客户细分,并制定更加精准的营销策略。

接着,本章将深入讨论决策树如何帮助营销团队理解和利用客户数据,以改善产品定位、优化营销活动、提升客户满意度和忠诚度。这不仅是数据分析技术的突破,也是企业决策模式的一次革命性转变。

# 2. 决策树模型的理论基础

## 2.1 决策树的定义和工作原理

### 2.1.1 决策树的基本概念

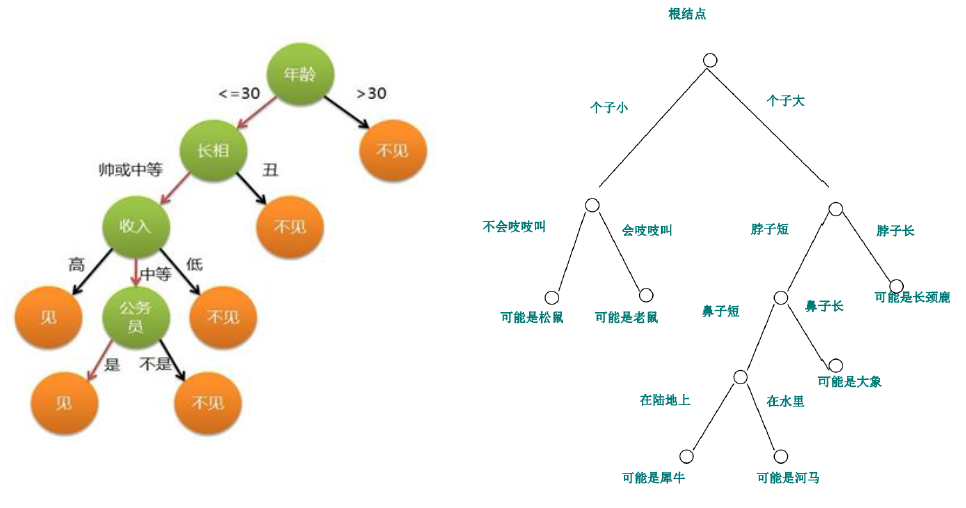

决策树是一种典型的监督学习算法,它模拟了人类在做决策时的思维过程。在机器学习中,决策树用来进行分类和回归任务。它通过一系列的条件判断将数据集拆分为越来越小的、更易于管理的子集,并最终形成树状的结构,其中每个内部节点代表了一个属性上的判断,每个分支代表了一个判断结果的输出,而每个叶节点代表了一个类的预测结果。

从概念上看,决策树非常直观易懂。它以树形结构的方式展现,就像我们人类做决策时那样,首先面临一个决策点,然后根据实际情况选择不同的路径,直至达到最终的决策结果。这种结构使得决策树模型不仅易于理解,而且非常适合进行数据分析的可视化展示。

### 2.1.2 决策树的构建过程

构建决策树的过程大致可以分为三个主要步骤:

1. **特征选择**:在每个节点,选择一个最优的特征进行分割,这个特征应能最大程度地将数据集中的样本根据目标变量分类。常用的特征选择标准包括信息增益、增益率和基尼指数等。

2. **树的生成**:递归地使用特征选择标准,在每个结点上划分数据集。每次划分都要创建两个或更多的子节点。这个过程会一直进行,直到满足停止条件,比如所有实例都属于同一类,或者没有剩余的特征等。

3. **树的剪枝**:为了避免过拟合,可能会对生成的决策树进行剪枝。剪枝的目的是去除那些对预测结果影响不大的枝节,从而得到一个更简单的树模型。剪枝可以发生在树的生成过程中(预剪枝),或者生成后(后剪枝)。

为了深入理解决策树的工作原理,我们来看一个简单的例子:

假设我们有一个天气与是否去郊游的数据集,其中包含了温度、湿度、风速三个特征,以及是否去郊游一个目标变量。构建决策树的过程将会:

1. 对于初始数据集,计算每个特征的信息增益或基尼不纯度。

2. 选择一个最优特征作为当前节点,并按照该特征的不同取值划分数据集,创建分支。

3. 对每个分支递归地重复上述过程,直至所有的特征都用尽或者满足停止条件。

## 2.2 决策树的分类和类型

### 2.2.1 分类决策树

分类决策树是决策树中用于解决分类问题的一种类型。在分类决策树中,目标变量是离散的分类标签。例如,在市场营销中,我们可以使用分类决策树来预测客户是否会响应某种促销活动,或者客户是否会留下正面的产品评价。

构建分类决策树的关键在于如何确定每个节点的最优划分方式。常用的决策树算法包括ID3、C4.5、CART等。其中,ID3使用信息增益作为特征选择标准,而C4.5在此基础上进行了改进,采用增益率来克服信息增益的一些不足,如偏向选择具有更多取值的特征。CART(分类与回归树)算法则可以同时处理分类问题和回归问题。

### 2.2.2 回归决策树

与分类决策树相对,回归决策树用于解决回归问题,其目标变量是连续值。回归决策树在房地产市场中分析影响房价的因素,或者在金融领域用于预测股票价格等方面有着广泛的应用。

回归决策树的构建方法类似于分类决策树,但划分节点的方式有所不同。一般而言,回归决策树会尝试找到最佳的分割点,使得分割后的两个子节点中目标变量的平均值差最大,以此来减少目标变量的预测误差。

一个具体的例子是使用决策树模型来预测房地产价格。模型会根据诸如房屋大小、位置、建筑年代等因素来决定树的每个节点如何分割数据集,最终得到一个能够预测房价的回归模型。

## 2.3 决策树的评估和优化

### 2.3.1 决策树的性能评估方法

对于任何机器学习模型而言,模型的性能评估都是一个重要的步骤。在决策树中,评估通常涉及以下几个步骤:

1. **交叉验证**:将数据集分成K个子集,轮流使用其中的一个子集作为测试集,其余作为训练集。这种方法可以更准确地估计模型在未知数据上的性能。

2. **错误率分析**:计算模型在训练集和测试集上的错误率,用于评估模型的泛化能力。过高的训练集错误率表明模型可能存在欠拟合,而过高的测试集错误率则表明模型可能过拟合。

3. **混淆矩阵**:特别对于分类问题,混淆矩阵能够详细地展示分类模型在各个类别上的性能。从混淆矩阵可以得到精确率、召回率等评价指标。

4. **特征重要性评估**:通过评估特征对决策树模型输出的贡献度,可以知道哪些特征对预测结果更加重要。

一个有效的性能评估方法可以确保决策树模型在实际应用中能够提供可靠的预测。

### 2.3.2 决策树的剪枝技术

剪枝技术是决策树优化中的一个关键步骤,用以防止模型过拟合。过拟合是机器学习模型中常见的问题,指的是模型对训练数据的噪声和异常值过于敏感,导致泛化能力下降。

决策树剪枝主要有预剪枝和后剪枝两种策略:

- **预剪枝**:在树的生成过程中进行剪枝,通过提前终止节点分裂来避免过拟合。预剪枝的方法包括限制树的最大深度、限制分裂前的最小样本数、以及设置目标变量的最小提升值等。

- **后剪枝**:生成完整的决策树之后再进行剪枝。后剪枝一般更为有效,因为它是在完整的树结构基础上进行的。后剪枝的方法包括减少错误剪枝(REDUCE)和误差复杂性剪枝(EC)等。

接下来,我们将详细探讨决策树模型如何在客户细分这一具体市场营销领域中得到应用。

# 3. 决策树在客户细分中的应用实践

在现代市场营销领域,客户细分是了解客户群体、定制个性化营销策略和提高营销效率的关键环节。决策树作为一种强大的预测建模工具,在客户细分中扮演了至关重要的角色。本章节将深入探讨决策树模型在客户细分方面的具体应用,并通过实践案例来展示其在现实世界中的实际效用。

## 3.1 数据准备和预处理

### 3.1.1 数据收集和清洗

在构建决策树模型之前,首要任务是获取并清洗相关数据。数据收集涉及从多个渠道(如客户调查、销售记录、网站互动、社交媒体分析等)收集信息,以确保模型有足够的输入信息进行学习和预测。

数据清洗的目的是保证数据质量,消除数据中的噪声和不一致性。这一步骤包括处理缺失值、纠正错误、去除异常值以及格式化数据等。例如,缺失的数据可以通过使用平均值、中位数、众数或其他统计方法来填补;异常值可以通过设置阈值或使用箱型图来识别和处理。

### 3.1.2 特征选择和处理

接下来的步骤是进行特征选择和处理。特征选择是确定哪些变量是预测客户细分最重要的因素。这可以通过统计测试、模型评分和专家知识等方法来完成。之后,对于选定的特征进行转换处理,例如归一化或标准化数值数据,将分类变量编码为数值等,以确保模型能够有效地处理输入数据。

### 3.1.3 示例代码块:数据预处理流程

以下是一个简单Python示例,展示数据预处理的基本流程:

```python

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.impute import SimpleImputer

# 假设我们有一个数据框架df,包含我们的客户数据

df = pd.read_csv('customer_data.csv')

# 数据清洗:处理缺失值

imputer = SimpleImputer(strategy='mean') # 使用平均值填充缺失值

df['age'] = imputer

```

0

0