Hadoop入门:HDFS、MapReduce与HBase解析

需积分: 10 116 浏览量

更新于2024-07-23

收藏 608KB PPTX 举报

"对Hadoop中的HDFS、MapReduce、HBase系列知识的介绍,适合初学者了解和学习大数据处理框架的入门资料。"

Hadoop是一个开源的分布式计算框架,最初由Doug Cutting创建,目的是为了支持大规模数据处理。它被设计成能够在普通硬件上运行,允许在大规模集群中处理PB级别的数据。Hadoop的核心组件包括HDFS(Hadoop Distributed File System)和MapReduce,这两个部分协同工作,使得处理海量数据变得高效且可靠。

**HDFS(Hadoop Distributed FileSystem)**

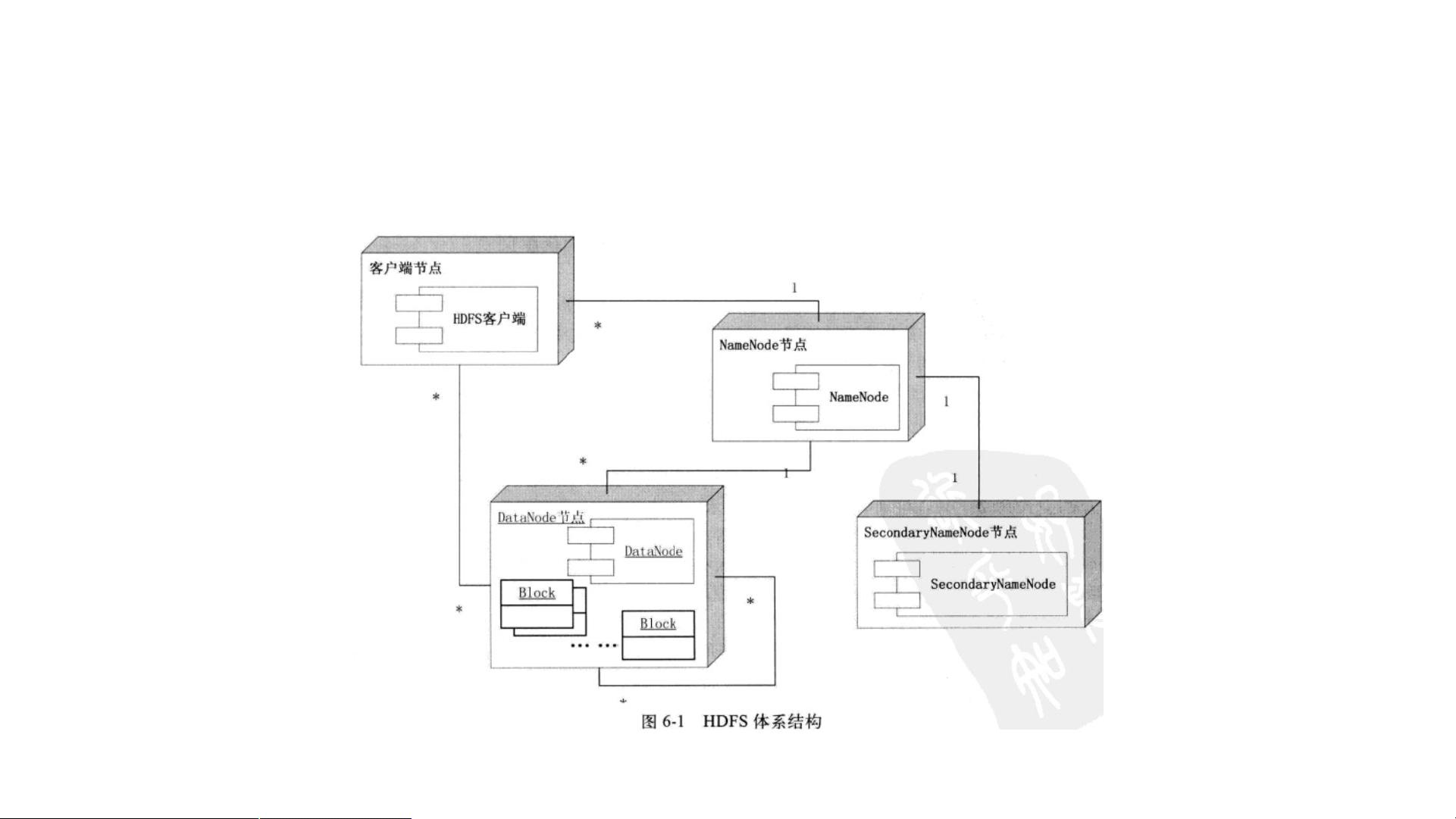

HDFS是一个分布式文件系统,旨在提供高度容错性和高吞吐量的数据访问。它的设计目标是能够处理和存储非常大的文件,同时保证数据的高可用性。HDFS采用了主从(Master/Slave)架构,主节点称为NameNode,负责管理文件系统的元数据,如文件名、文件的块位置信息等。从节点称为DataNode,它们存储实际的数据块。当客户端写入文件时,数据会被分割成多个块,并复制到多个DataNode上,以防止单点故障。HDFS的另一个特性是其“一次写入,多次读取”(WAL, Write Once, Read Many)模式,这保证了数据的一致性。

**MapReduce**

MapReduce是一种编程模型,用于大规模数据集的并行计算。它将大型任务分解为一系列小的Map任务和Reduce任务,这些任务可以在集群的不同节点上并行执行。Map阶段将输入数据拆分为键值对,并进行局部处理,Reduce阶段则对Map产生的中间结果进行合并和聚合,最终输出结果。这种模型简化了分布式计算的复杂性,开发者只需要关注Map和Reduce函数的实现,而Hadoop会处理任务调度和数据分布。

**HBase**

HBase是一个基于Hadoop的分布式NoSQL数据库,它提供了高度可扩展的随机读写能力。HBase的设计灵感来源于Google的BigTable,适用于结构化和半结构化数据的存储。它在HDFS之上构建,将数据存储在行和列族中,支持实时查询。HBase适用于那些需要低延迟、高并发读写操作的应用场景。

**相关项目**

- **Hive**:基于Hadoop的数据仓库工具,提供SQL-like查询语言HiveQL,方便用户对存储在HDFS上的大量数据进行查询和分析。

- **Mahout**:一个机器学习库,包含多种算法,如分类、聚类和推荐系统,用于构建智能应用。

- **Sqoop**:用于在关系数据库和Hadoop之间导入导出数据的工具,方便数据迁移。

- **ZooKeeper**:分布式协调服务,用于解决命名服务、配置管理、组服务等问题。

- **Avro**:Hadoop的数据序列化系统,提供紧凑、高效的二进制数据格式,用于跨语言通信和持久化。

Hadoop生态系统还包括其他项目,如Pig(用于分析的大数据处理语言)、Spark(高性能计算框架)和Tez(优化MapReduce的计算引擎)等,它们共同构成了处理大数据的全面解决方案。通过这些组件的组合,开发者可以构建复杂的数据处理管道,从数据采集、存储、处理到分析,实现大数据的价值挖掘。

2023-06-09 上传

2023-05-09 上传

306 浏览量

点击了解资源详情

点击了解资源详情

ta198

- 粉丝: 0

- 资源: 10

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常