scikit-learn MiniBatchKMeans 聚类模型详解与参数设置

下载需积分: 0 | PDF格式 | 787KB |

更新于2024-08-05

| 18 浏览量 | 举报

聚类是数据分析中的一个重要步骤,主要用于发现数据中的结构和模式,将其分成若干个有意义的类别或群组。Scikit-learn是一个广泛使用的Python机器学习库,提供了丰富的聚类算法,其中MiniBatchKMeans是其中之一。这个模型专注于高效处理大规模数据集,适用于实时或在线学习场景。

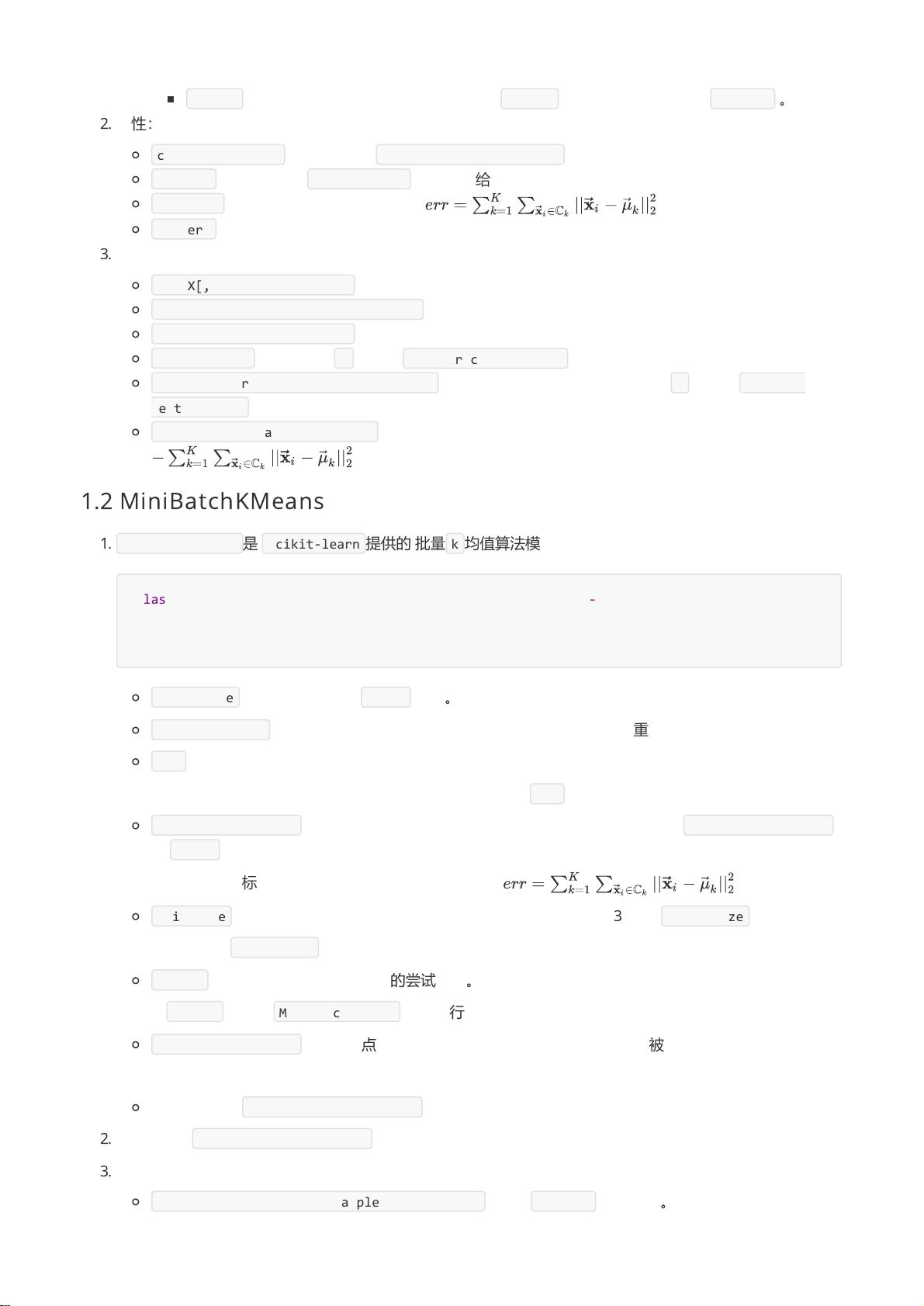

MiniBatchKMeans模型在scikit-learn中遵循一些通用的方法和参数设置。首先,让我们来看看模型的一些关键方法:

1. `get_params([deep])`:这是一个用于获取模型参数的方法,如果参数deep设置为True,还可以递归地获取嵌套对象的参数。这对于了解模型内部配置非常有用。

2. `set_params(**params)`:此方法用于设置模型的参数,通过关键字参数传递需要修改的参数值。

3. `fit(X[, y, sample_weight])`:这是训练模型的核心方法,输入数据X是一个二维numpy数组,每行代表一个样本,每列代表一个特征。y是可选的样本标签,用于监督学习;sample_weight则是每个样本的权重,可以用来调整样本的重要性。

4. `predict(X, sample_weight)`:在模型训练后,这个方法用于预测新数据X中每个样本属于哪个簇。

5. `fit_predict(X[, y, sample_weight])`:结合了训练和预测,一次性完成聚类和标签分配。

6. `transform(X)`:将输入数据转换到聚类中心空间,这里的距离度量反映了样本与各个簇中心的关联程度。

7. `fit_transform(X[, y, sample_weight])`:提供了一步到位的训练和转换功能,适用于直接从原始数据得到聚类结果的需求。

8. 参数`n_jobs`:这是一个可选参数,指定了并行计算的进程数量,可以提高模型在多核处理器上的性能。如果为正整数,模型将会利用多个核心进行计算。

在使用MiniBatchKMeans时,理解这些方法及其参数至关重要。它们帮助用户控制模型的行为,优化性能,并确保正确处理数据。例如,调整`n_jobs`可以根据硬件资源选择合适的并行性,而设置`sample_weight`则允许对某些数据点赋予更高的重要性。此外,对于大型数据集,`MiniBatchKMeans`的批量处理能力使其成为处理高维数据和大规模数据集的理想选择。

在实际应用中,根据数据集的特性(如数据大小、维度、稀疏性等),可能需要尝试不同的参数组合和算法来优化聚类效果。同时,评估聚类质量也是必不可少的,可以使用轮廓系数、Calinski-Harabasz指数等指标来衡量不同模型的性能。通过理解和熟练运用MiniBatchKMeans这样的聚类模型,数据科学家可以更有效地揭示数据中的潜在结构,支持业务决策和洞察。

相关推荐

ali-12

- 粉丝: 34

最新资源

- Subclipse 1.8.2版:Eclipse IDE的Subversion插件下载

- Spring框架整合SpringMVC与Hibernate源码分享

- 掌握Excel编程与数据库连接的高级技巧

- Ubuntu实用脚本合集:提升系统管理效率

- RxJava封装OkHttp网络请求库的Android开发实践

- 《C语言精彩编程百例》:学习C语言必备的PDF书籍与源代码

- ASP MVC 3 实例:打造留言簿教程

- ENC28J60网络模块的spi接口编程及代码实现

- PHP实现搜索引擎技术详解

- 快速香草包装技术:速度更快的新突破

- Apk2Java V1.1: 全自动Android反编译及格式化工具

- Three.js基础与3D场景交互优化教程

- Windows7.0.29免安装Tomcat服务器快速部署指南

- NYPL表情符号机器人:基于Twitter的图像互动工具

- VB自动出题题库系统源码及多技术项目资源

- AndroidHttp网络开发工具包的使用与优势