PyTorch实现Himmelblau函数优化解析

14 浏览量

更新于2024-09-07

收藏 101KB PDF 举报

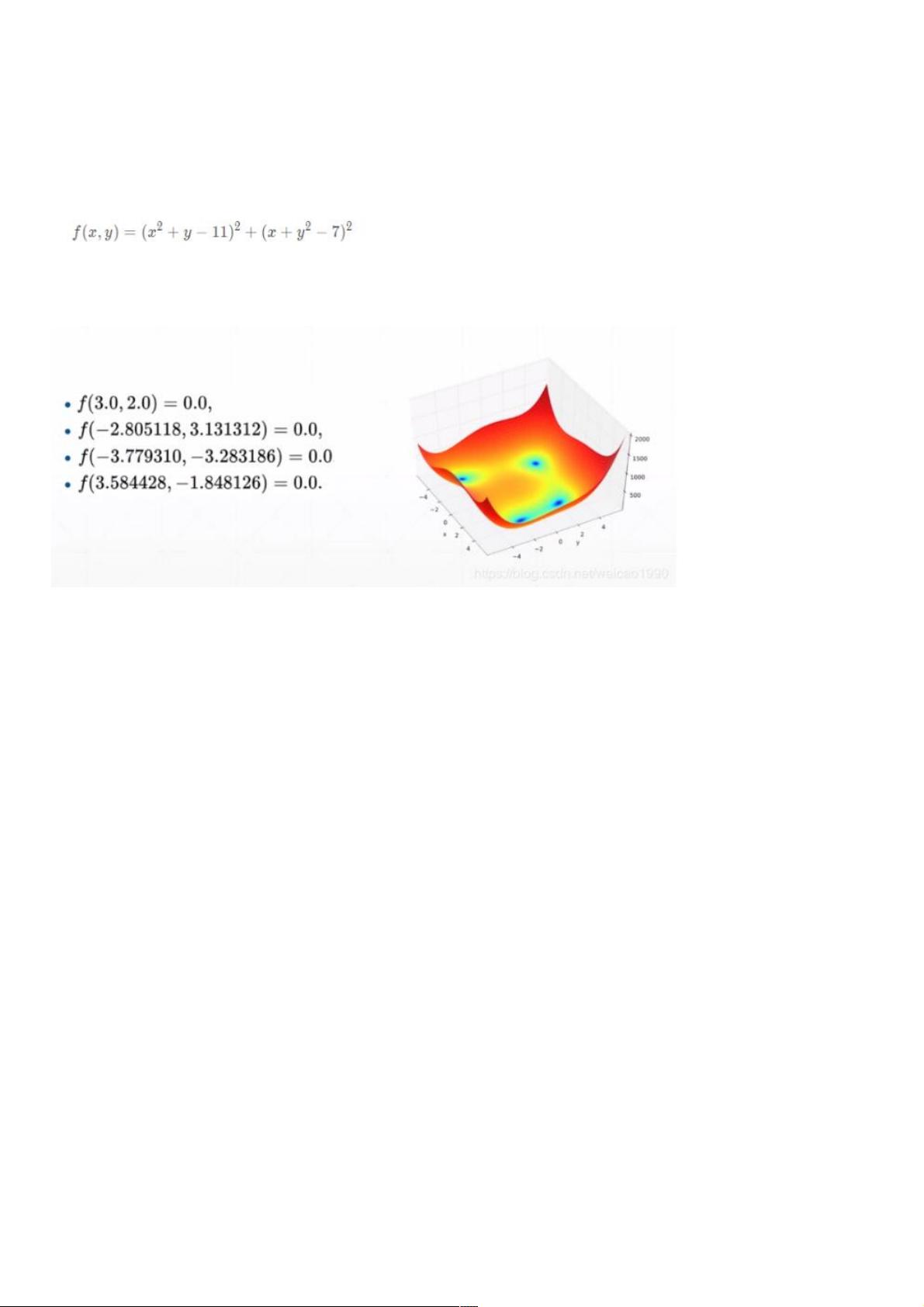

"这篇教程详细介绍了如何在PyTorch中使用优化算法来解决Himmelblau函数的最小化问题。Himmelblau函数是一个经典的多峰优化测试函数,具有四个全局最小值,常用于评估优化算法的效果。文章通过可视化Himmelblau函数的三维图像,帮助读者理解其形状和特点。接着,作者展示了如何使用PyTorch中的随机梯度下降(SGD)以及Adam优化器来寻找该函数的最小值。"

在深入探讨之前,先了解一下Himmelblau函数。这是一个二元二次函数,形如:

\( f(x, y) = (x^2 + y - 11)^2 + (x + y^2 - 7)^2 \)

这个函数有四个全局最小值,分别位于坐标点 (-3, -2), (2, -3), (3, 1) 和 (-2, 3),这些点上的函数值都是0。Himmelblau函数因其多峰特性,常用于测试和比较不同的优化算法。

在PyTorch中,我们可以使用NumPy和Matplotlib库来绘制Himmelblau函数的三维图像,以直观地观察其结构。代码示例中首先导入了必要的库,并定义了函数,然后创建了一个网格,遍历每个点并计算其对应的函数值,最后用`plot_surface`方法绘制3D图像。

接着,教程展示了如何在PyTorch中应用优化算法来寻找Himmelblau函数的最小值。首先,定义了Himmelblau函数的PyTorch版本,并初始化了一个张量`x`作为变量,设置其`requires_grad=True`以便追踪梯度。接着,使用Adam优化器(一种常用的适应性学习率优化算法)来更新`x`的值,以逐渐接近最小值。

优化过程由一个循环控制,循环内首先计算预测值`pred`,即当前点的函数值。然后,通过调用`zero_grad()`清零梯度,避免梯度累积。`backward()`方法计算预测值关于变量的梯度,而`step()`则基于这些梯度更新变量的值。这个过程持续20,000次迭代,理论上应该能收敛到Himmelblau函数的一个全局最小值。

需要注意的是,优化过程中的学习率(lr)是一个关键参数,它决定了每次更新步长的大小。在本例中,学习率为1e-3,这是一个相对较小的值,可以保证在寻找最小值时有较好的精度,但可能需要更多迭代次数。实际应用中,学习率的选择应根据具体问题和模型来调整。

本教程提供了一种使用PyTorch进行优化问题求解的方法,对于理解和实践深度学习中的优化概念非常有帮助。通过这样的实例,读者可以更深入地了解如何在PyTorch中利用自动微分和优化器解决非线性优化问题。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2020-12-23 上传

2020-12-23 上传

2020-09-18 上传

2023-05-10 上传

2023-10-11 上传

2023-10-01 上传

weixin_38708945

- 粉丝: 2

- 资源: 908

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析