Spark高可用集群搭建指南

46 浏览量

更新于2024-08-03

收藏 355KB PDF 举报

"Spark集群环境搭建,包括集群规划、前置条件、Spark集群搭建、启动集群、验证集群高可用以及提交作业。重点在于基于ZooKeeper实现Spark高可用,确保Master服务的稳定性。"

Spark集群环境的搭建是一个复杂的过程,涉及到多个步骤和组件的配置。在本文中,我们将深入探讨如何在3节点的环境中构建一个高可用的Spark集群。

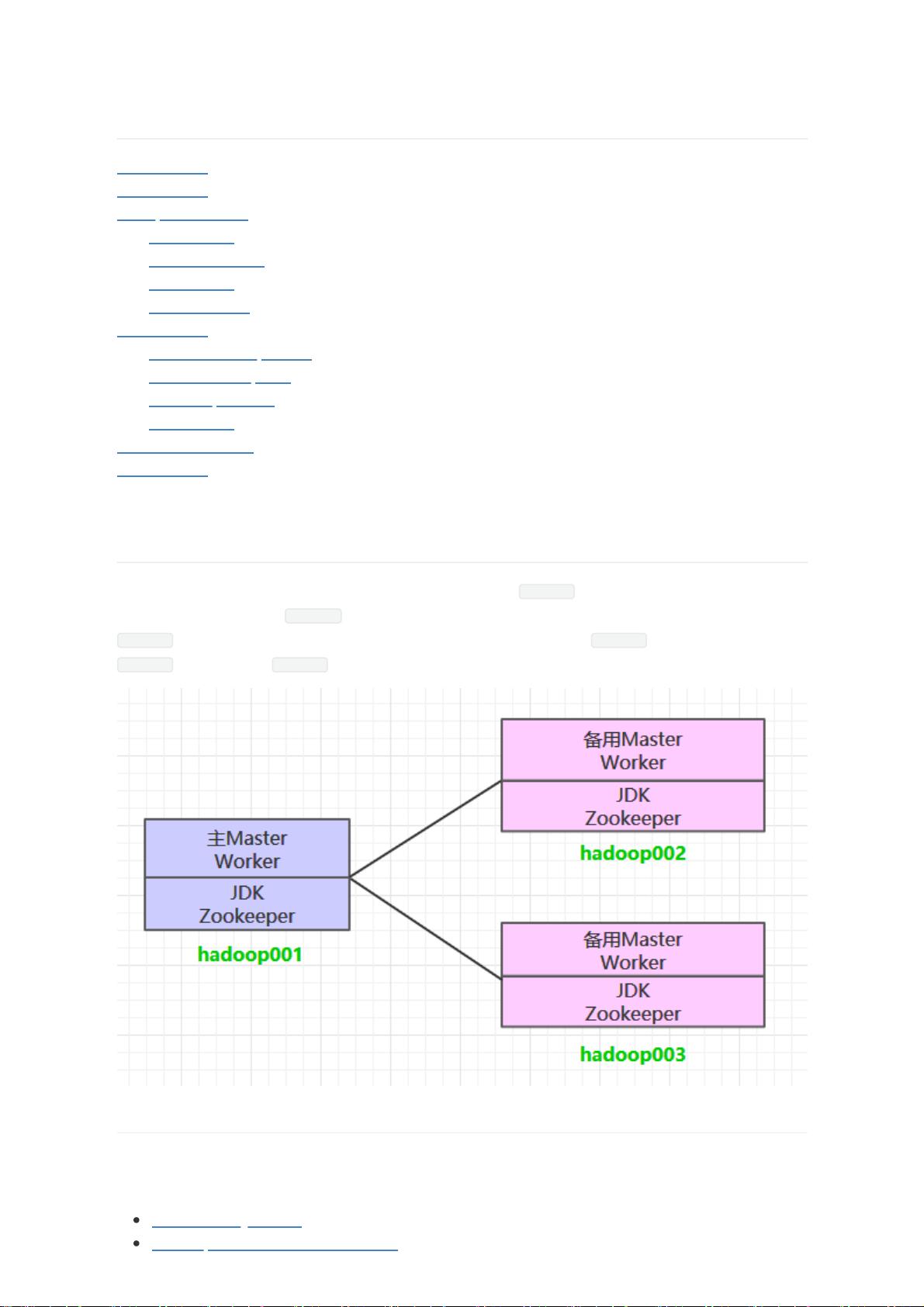

一、集群规划

规划是搭建任何集群的第一步。在这个例子中,我们计划创建一个3节点的Spark集群,每个节点都将运行Worker服务。为了提供高可用性,主Master服务将部署在hadoop001上,而备用Master服务则会在hadoop002和hadoop003上部署。这些Master服务将通过ZooKeeper集群进行管理,确保在主Master故障时能无缝切换到备用Master。

二、前置条件

在搭建Spark集群之前,必须先安装并配置好JDK、Zookeeper集群和Hadoop集群。JDK提供Java运行环境,Zookeeper用于Master节点的选举和监控,而Hadoop则作为Spark的数据存储和计算平台。

三、Spark集群搭建

1. 下载解压:从Apache Spark官方网站获取所需的Spark版本,并进行解压。

2. 配置环境变量:在系统环境变量中添加SPARK_HOME路径,并更新PATH,确保可以执行Spark的相关命令。

3. 集群配置:在${SPARK_HOME}/conf目录下,根据模板文件修改`spark-env.sh`,配置JDK、Hadoop配置文件的位置,以及Zookeeper的地址。

四、启动集群

1. 启动ZooKeeper集群:Zookeeper作为协调服务,需要首先启动。

2. 启动Hadoop集群:确保Hadoop集群正常运行,为Spark提供数据存储和处理环境。

3. 启动Spark集群:在每个节点上启动Spark的服务,包括Master和Worker。

4. 查看服务:通过Web UI检查各个服务是否正常运行,如Spark Master和Worker的状态。

五、验证集群高可用

在集群启动后,可以通过模拟主Master服务故障来验证高可用性。如果ZooKeeper能够成功选举新的主Master,并且集群作业不受影响,那么高可用性就得到了验证。

六、提交作业

一旦集群搭建完成并验证了高可用性,就可以向集群提交Spark作业。这通常通过Spark的Submit工具进行,指定Master地址、应用 jar 包、参数等信息。

总结来说,Spark集群的搭建是一个涉及多步骤的过程,包括集群规划、环境准备、配置、启动和服务验证。通过合理规划和配置,可以构建出一个稳定且高可用的Spark集群,以满足大规模数据处理的需求。同时,利用ZooKeeper进行Master服务的高可用管理,可以大大提高集群的容错性和稳定性。

417 浏览量

点击了解资源详情

465 浏览量

135 浏览量

104 浏览量

141 浏览量

118 浏览量

大数据技术派

- 粉丝: 1867

最新资源

- Cutterman: iOS代码审查与优化建议征集

- Eclipse工作空间配置文件分享与使用指南

- Linux内存分析器:检测内存泄漏与消耗

- 经典Java8 32位JDK下载 - JDK8最新版本发布

- WebOffice在线编辑器:快速处理Word和Excel文档

- Telerik Reporting 2014 Q3正式版发布,支持零序列号体验

- Delphi语言环境下的TsiLang组件范例分析

- 掌握SPI通信:C语言实现数据收发技巧

- 京东商城收货地址三级联动插件代码解析

- 通过RXTXcomm包实现Web端串口通信配置指南

- IEServer-master实现HTTP调用IE浏览器打开URL

- Chocolatey: React Native开发环境快速安装指南

- 两分钟内轻松将组织模式文件转化为炫酷HTML

- 绿色版VB图标制作工具v2.05:轻松制作与编辑ICO图标

- WoWoViewPagerAndroid:创新Android引导页面设计

- ResourceBundle Editor:提升本地化属性文件管理效率