数据科学家的探索之路:从数据格式到数据融合

43 浏览量

更新于2024-08-28

收藏 317KB PDF 举报

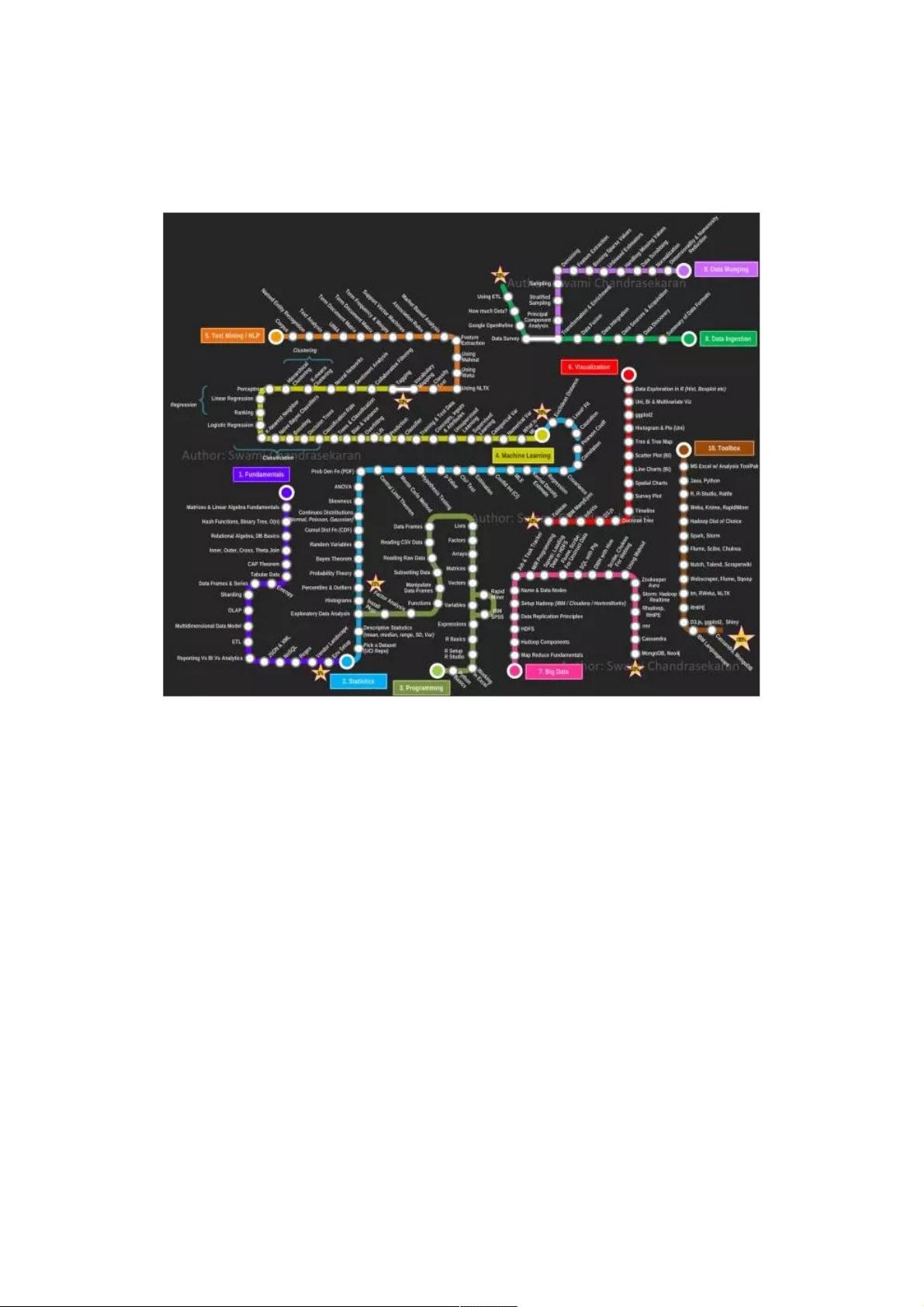

"数据科学家成长指南(下)深入探讨了数据获取、数据格式、数据发现、数据来源与采集、数据集成以及数据融合等关键概念,旨在帮助数据科学家在复杂的数据环境中提升技能和效率。"

在数据科学领域,理解和掌握各种数据相关概念至关重要。《数据科学家成长指南(下)》中,作者首先提到了DataIngestion,即数据获取,这是数据分析的起点。由于涉及众多术语,如ETL(提取、转换、加载)、API、日志文件等,数据获取阶段容易造成混淆。数据科学家需要对这些方法有清晰的认识,以便有效地收集所需数据。

接着,文章介绍了SummaryofDataFormats,即数据格式概要。数据科学家在处理数据前,必须了解数据的结构化和非结构化形式,例如表格数据、文本、图像、音频或视频等。结构化数据通常易于处理,而非结构化数据则需要特殊的技术和工具来解析。此外,即使是同类型的数据,如时间日期,也会因时区、日期格式等因素而有所不同,这要求数据科学家具备良好的数据处理和清洗能力。

DataDiscovery是数据科学家面临的重要任务,它包括对现有数据的全面了解和探索。数据发现不仅是要识别数据的丰富性,还要判断哪些数据对解决问题最有价值,哪些可能含有噪声或不准确信息。在这个过程中,探索性数据分析(EDA)是关键,它帮助数据科学家理解数据的分布、相关性和潜在模式。

DataSources&Acquisition则强调了数据来源和采集策略。数据科学家需要确定合适的数据源,如内部数据库、公共数据集、社交媒体、传感器等,并决定如何有效地采集数据,有时甚至需要通过埋点技术来收集缺失的信息。

数据集成(DataIntegration)是指将来自不同源头的数据整合成一个统一的视图,这可能涉及到企业合并时的数据整合,或者单次分析所需的多源数据汇合。数据集成通常需要解决数据一致性、主键匹配和数据质量等问题。

最后,数据融合(DataFusion)是将不同来源的数据在模型层面上进行结合。这涉及到更高级的数据处理,可能包括特征工程、异常检测和数据校准,以创建更准确的分析模型。

《数据科学家成长指南(下)》通过详细阐述这些核心概念,为数据科学家提供了宝贵的学习资源,帮助他们在数据的海洋中导航,提升数据分析和建模的能力。

点击了解资源详情

134 浏览量

点击了解资源详情

334 浏览量

254 浏览量

点击了解资源详情

150 浏览量

点击了解资源详情

102 浏览量

weixin_38611796

- 粉丝: 8

最新资源

- 网页自动刷新工具 v1.1 - 自定义时间间隔与关机

- pt-1.4协程源码深度解析

- EP4CE6E22C8芯片三相正弦波发生器设计与实现

- 高效处理超大XML文件的查看工具介绍

- 64K极限挑战:国际程序设计大赛优秀3D作品展

- ENVI软件全面应用教程指南

- 学生档案管理系统设计与开发

- 网络伪书:社区驱动的在线音乐制图平台

- Lettuce 5.0.3中文API文档完整包下载指南

- 雅虎通Yahoo! Messenger v0.8.115即时聊天功能详解

- 将Android手机转变为IP监控摄像机

- PLSQL入门教程:变量声明与程序交互

- 掌握.NET三层架构:实例学习与源码解析

- WPF中Devexpress GridControl分组功能实例分析

- H3Viewer: VS2010专用高效帮助文档查看工具

- STM32CubeMX LED与按键初始化及外部中断处理教程