深度解析:卷积神经网络(CNN)的工作原理

103 浏览量

更新于2024-08-31

收藏 699KB PDF 举报

"AI学习笔记——卷积神经网络(CNN)"

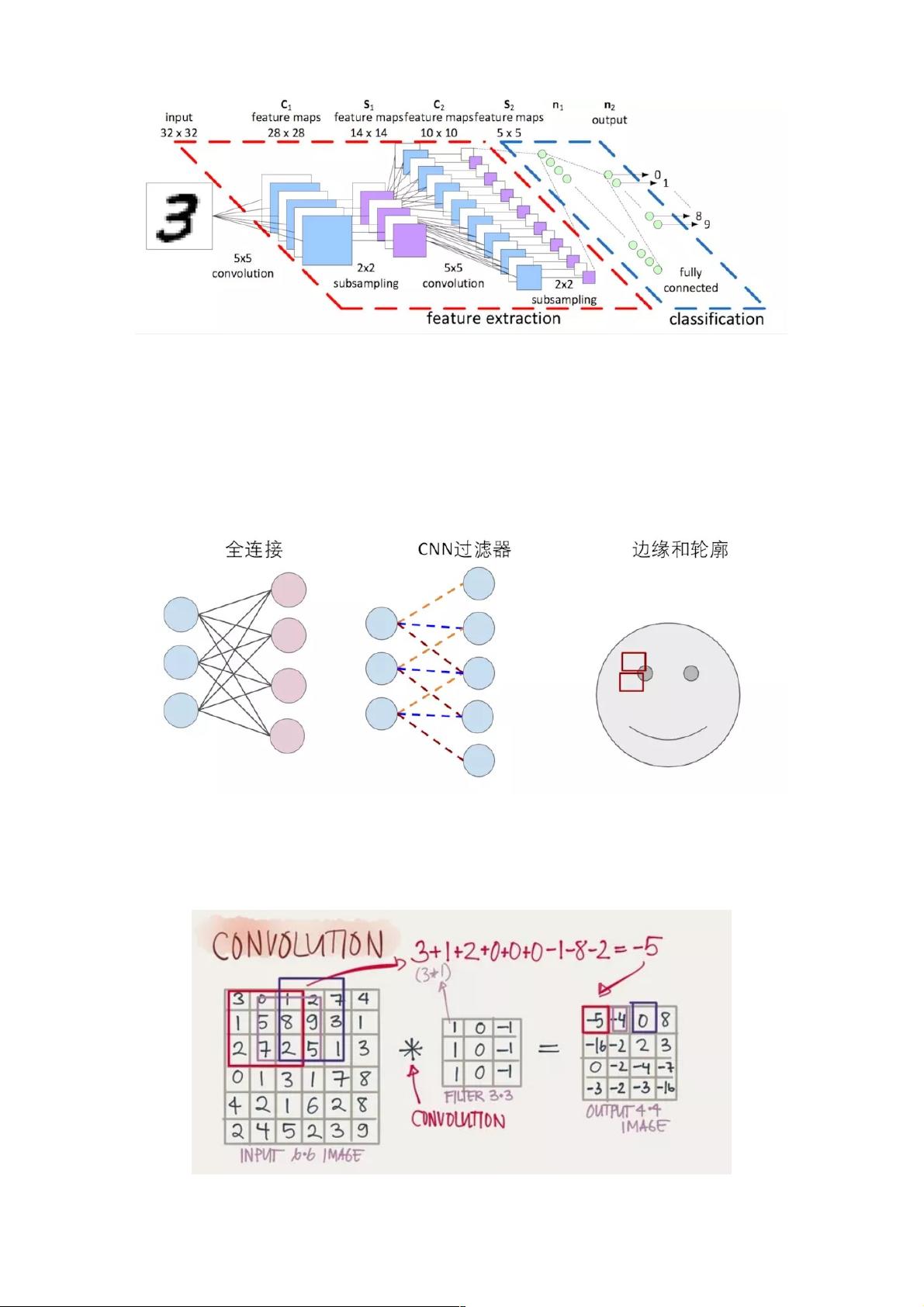

卷积神经网络(CNN)是一种专门用于处理具有网格状结构数据,如图像、声音或时间序列等的深度学习模型。在CNN中,卷积层是核心组成部分,它通过滤波器(Filter)来提取特征,从而减少了对全连接层的依赖,降低了模型复杂度。

卷积(Convolution):

卷积操作是CNN的基础,它使用滤波器在输入图像上滑动并应用权重运算。滤波器通常是一个小的多维数组,例如3x3或5x5,它在输入图像上逐行逐列地移动,每次移动称为一个步长(Stride)。在每个位置,滤波器与输入图像的部分区域(也称为感受野)进行点乘运算,然后将结果求和,加上偏置项,得到该位置的输出值。这样,滤波器在输入上滑动并计算出新的特征映射,形成了输出层的图像。

填充(Padding):

为了保持输出图像的尺寸与输入图像相同,可以使用填充技术。在输入图像的边缘添加额外的像素(通常是0),使得滤波器在覆盖输入图像时,能够覆盖到边缘,从而保持输出尺寸不变。

步长(Stride):

步长决定了滤波器在输入图像上移动的距离。较大的步长会减少计算量,但可能丢失某些细节信息;较小的步长则能捕获更多局部信息,但会增加计算复杂度。

深度(Depth):

深度指的是输出特征图的通道数。在处理彩色图像时,原始输入可能包含多个通道(如RGB的3个通道)。滤波器也对应有相同的通道数,对每个通道进行卷积,生成的输出特征图也具有相同数量的通道。因此,如果一个3x3x3的滤波器应用于6x6x3的输入图像,可能会产生一个4x4x1的输出,这里的1表示输出特征图的深度。

池化(Pooling):

除了卷积,CNN还常使用池化层来进一步降低数据维度,提高模型的鲁棒性。常见的池化操作有最大池化和平均池化,它们在小区域内选择最大值或平均值作为输出。

激活函数(Activation Function):

激活函数如ReLU(Rectified Linear Unit)为网络引入非线性,使得模型能够学习更复杂的特征。

全连接层(Fully Connected Layer):

虽然CNN主要依赖于卷积和池化层,但在最后,通常会接一个或多个全连接层,用于分类或回归任务。全连接层中的每个神经元都连接到前一层的所有神经元,形成一个密集的连接网络。

训练与优化:

CNN的训练过程包括反向传播和梯度下降,通过调整滤波器的权重来最小化损失函数,通常使用Adam、SGD等优化算法。

总结:

卷积神经网络(CNN)通过卷积、池化、激活函数以及全连接层等组件,有效地从输入数据中提取特征,特别适用于图像识别和计算机视觉任务。理解这些基本概念是深入研究和应用CNN的关键。

2018-05-29 上传

2022-11-26 上传

199 浏览量

1873 浏览量

117 浏览量

2018-05-28 上传

572 浏览量

141 浏览量

606 浏览量

weixin_38589168

- 粉丝: 7

最新资源

- C#实现自定义尺寸条形码和二维码生成工具

- Bootthink多系统引导程序成功安装经验分享

- 朗读女中文朗读器,智能语音朗读体验

- Jupyter Notebook项目培训教程

- JDK8无限强度权限策略文件8下载指南

- Navicat for MySQL工具压缩包介绍

- Spring和Quartz集成教程:定时任务解决方案

- 2013百度百科史记全屏效果的fullPage实现

- MATLAB开发电磁转矩电机瞬态响应研究

- 安卓系统短信问题解决方案:使用BlurEmailEngine修复

- 不同版本Android系统的Xposed框架安装指南

- JavaScript项目实验:模拟骰子与颜色转换器

- 封装高效滑动Tab动画技术解析

- 粒子群优化算法在Matlab中的开发与应用

- 网页图书翻页效果实现与turnjs4插件应用

- JSW: 一种新型的JavaScript语法,支持Coffeescript风格